La irrupción de las herramientas no code ha borrado la línea que separaba tener una idea y lanzar un producto digital. Lo que hace nada exigía un equipo de desarrollo, meses de trabajo y un presupuesto serio, hoy se puede validar en días con plataformas visuales, IA y automatizaciones al alcance de cualquiera.

Si eres estudiante de DAW, DAM, SMX, emprendedor, profesional de marketing o de operaciones, este ecosistema te permite crear webs, apps, automatizaciones y agentes de IA sin tocar una línea de código. Vamos a desgranar qué es el no code, en qué se diferencia del low code, qué ventajas y límites tiene, qué herramientas destacan y cómo combinarlas para montar desde un simple MVP hasta productos bastante serios.

Qué es el no code y por qué te interesa

Cuando hablamos de no code nos referimos a un modelo de desarrollo en el que construyes software con interfaces visuales, menús y bloques lógicos, en lugar de escribir instrucciones en lenguajes como JavaScript, Python o PHP.

En vez de pelearte con sintaxis, servidores y despliegues, trabajas con plantillas, componentes que arrastras y sueltas, flujos configurables y asistentes impulsados por IA que traducen lo que escribes en lenguaje natural a funcionalidades reales.

El objetivo de todo esto es democratizar la creación tecnológica: que un diseñador, un responsable de RRHH, un autónomo o un estudiante puedan lanzar productos y automatizaciones sin depender al 100% de programadores.

En la práctica, las plataformas no code te permiten construir sitios web, apps móviles y webapps, bases de datos, paneles de control y flujos de trabajo automatizados usando bloques predefinidos, conectores con otras herramientas y un poco de lógica.

Metodología no code: pensar como dev, trabajar como diseñador

Más que una lista de herramientas, el no code es una forma distinta de abordar la construcción de productos digitales. Cambias la obsesión por el código por el foco en la lógica, la experiencia de usuario y la validación rápida.

La metodología se apoya en varios pilares claros: diseño visual, modularidad, integración con servicios externos, iteración constante y automatización de todo lo repetitivo que se pueda.

En vez de desarrollar un monolito desde cero, montas tu solución combinando piezas tipo LEGO: formularios, listas, vistas de datos, pasarelas de pago, autenticación, correos automáticos, etc., y los orquestas con reglas del tipo “si pasa esto, haz aquello”.

Esto te obliga a pensar en términos de flujos de información, estados, entradas y salidas, igual que haría un programador, pero sin tener que abrir un editor de código. Es un aprendizaje muy potente si estás empezando en DAW/DAM o si vienes de un perfil nada técnico.

No code vs low code: mismos objetivos, distinto perfil

Dentro de este movimiento se han consolidado dos grandes familias: las plataformas no code puras, pensadas para personas sin background técnico, y las soluciones low code, orientadas a desarrolladores o equipos mixtos que quieren ir más lejos añadiendo código donde haga falta.

En el enfoque no code, todo lo haces mediante interfaces visuales: constructores drag-and-drop, asistentes de IA, menús y plantillas preconfiguradas. Aunque algunas herramientas permiten pegar trozos de HTML o CSS, la idea es que puedas sobrevivir perfectamente sin programar.

En el mundo low code, por el contrario, tienes también bloques visuales y aceleradores, pero hay zonas donde escribir código es casi obligatorio si quieres personalizar lógica compleja, integrarte con sistemas corporativos o exprimir al máximo el rendimiento.

Esto hace que muchas empresas usen el no code para prototipos, herramientas internas y validación rápida, y reserven plataformas low code o desarrollo tradicional para proyectos de larga vida, con requisitos muy específicos o una escala enorme.

Ventajas del no code para empresas, estudiantes y emprendedores

La popularidad del no code no es casualidad: reduce drásticamente la fricción para lanzar productos y automatizar procesos. Eso se traduce en beneficios muy claros para casi cualquier perfil.

La primera gran ventaja es la velocidad. Pasas de una idea a un prototipo funcional en cuestión de horas o días, no en semanas o meses. Eso te permite validar hipótesis, testear con usuarios reales y corregir el rumbo con muy poco coste.

La segunda es la accesibilidad económica. Muchas plataformas tienen planes gratuitos o muy asequibles, lo que para autónomos, pymes o proyectos educativos supone poder experimentar sin tener que contratar un equipo técnico ni invertir en infraestructuras.

También ganas autonomía: el propio equipo de negocio, marketing o diseño puede construir y modificar flujos, landings, mini-apps o automatizaciones sin depender cada vez de desarrollo. Esto reduce cuellos de botella y acelera la toma de decisiones.

Además, las plataformas no code están pensadas para escalar de forma razonable y adaptarse a más usuarios o más datos sin que tengas que pelearte con servidores o despliegues. Y, por último, fomentan la innovación interna: como es barato probar cosas, la gente se anima a proponer y construir soluciones que de otro modo nunca se habrían llegado ni a plantear.

Limitaciones y riesgos del enfoque no code

No todo son ventajas, ni el no code reemplaza al desarrollo tradicional. Hay límites que conviene tener muy presentes para no llevarte sustos a medio o largo plazo.

La primera gran pega es la personalización avanzada. Por muy completas que sean, las plataformas no code trabajan con un conjunto finito de bloques y reglas. Si tu producto necesita funciones muy específicas, algoritmos complejos o una experiencia totalmente a medida, tarde o temprano notarás las paredes del sistema.

Otro punto delicado es la escalabilidad en proyectos muy grandes. Aunque pueden aguantar miles de usuarios, en escenarios con volúmenes enormes de datos o picos de tráfico muy altos, los costes de uso o las limitaciones del proveedor pueden dispararse y hacer que el modelo deje de ser viable.

Además, asumes una dependencia fuerte de la plataforma elegida. Tu app vive en su infraestructura y bajo sus reglas. Si cambian precios, cierran el servicio o modifican el producto, tu margen de maniobra es muy pequeño, y migrar todo a otra solución puede implicar rehacer el proyecto desde cero.

Por último, no hay que olvidar los temas de seguridad y protección de datos. Al almacenar información de clientes, pagos o datos internos en servicios de terceros, debes asegurarte de que cumplen con la normativa (por ejemplo, RGPD) y entender bien dónde están tus datos y quién tiene acceso.

Automatización no code: tu asistente invisible

Una de las áreas donde el no code brilla especialmente es la automatización de procesos repetitivos. En lugar de copiar datos a mano, enviar correos uno a uno o actualizar hojas de cálculo cada día, dejas que un “robot” lo haga por ti.

Plataformas como Zapier, Make (antes Integromat) y n8n permiten conectar aplicaciones entre sí y definir flujos del tipo “si pasa X, haz Y” sin programar. Por ejemplo, si alguien rellena un formulario, se puede crear un registro en tu base de datos, enviar un email de bienvenida y notificar al equipo en Slack.

Con estas herramientas también puedes sincronizar redes sociales, CRMs, herramientas de soporte, calendarios y sistemas internos. Todo se orquesta con bloques visuales, condicionales, filtros y ramas que controlas con unos pocos clics.

El resultado es que reduces errores humanos, liberas tiempo de tareas tediosas y consigues que los datos estén siempre actualizados en todos tus sistemas. Para startups y pymes, la diferencia en eficiencia puede ser brutal.

Tipos de aplicaciones que puedes crear sin programar

Cuando hablamos de “crear apps sin código” no todo es lo mismo. Hay diferencias importantes entre aplicaciones nativas y aplicaciones web que conviene tener claras antes de elegir herramienta.

Las apps nativas son las que se desarrollan para un sistema operativo concreto, como iOS o Android, y se distribuyen a través de la App Store o Google Play. Aprovechan mejor el hardware del dispositivo (cámara, GPS, notificaciones push profundas) y suelen ofrecer mayor rendimiento y experiencia más pulida.

Las aplicaciones web o webapps se acceden a través del navegador, no hace falta instalarlas y funcionan en cualquier dispositivo con conexión a Internet. Son más sencillas de mantener y actualizar, porque con cambiar la app en el servidor todos los usuarios ven la nueva versión sin hacer nada.

Muchas herramientas no code se enfocan en uno de estos dos mundos, y otras te permiten salir a ambos canales con la misma base de proyecto, ya sea empaquetando la webapp como app nativa o generando código que luego puedes compilar.

Principales categorías de herramientas no code

El ecosistema no code es enorme, pero podemos agrupar las soluciones más usadas en unas cuantas categorías claras, según el tipo de producto o flujo que quieras construir.

Por un lado están los constructores de sitios web y landing pages como Webflow, Carrd, Wix o Squarespace, pensados para crear presencia online, portfolios, blogs, páginas de captación o webs corporativas.

Luego tienes plataformas para desarrollar aplicaciones web y móviles como Bubble, FlutterFlow, Adalo, Glide, WeWeb, Toddle, BravoStudio o Softr, con distintos grados de potencia, enfoque y complejidad de uso.

En el apartado de bases de datos y backend destacan Airtable, Xano o Supabase con interfaces visuales, que actúan como “cerebro” de muchos proyectos no code y sirven de fuente de verdad para tus datos.

También hay herramientas especializadas en formularios, encuestas, CRMs ligeros y recogida de información como Typeform, Jotform, herramientas de productividad como Obsidian o el combo Notion + Zapier, que te permiten captar leads, estructurar información y automatizar respuestas.

Herramientas no code para crear webs y landings

Si lo que necesitas es una web con buena presencia, un portfolio o una landing para validar una idea, lo más cómodo es recurrir a constructores visuales centrados en diseño.

Webflow se ha convertido en el estándar de facto para sitios web profesionales con alto control sobre la maquetación. Permite trabajar con un modelo parecido a CSS, animaciones, CMS integrado y exportar código limpio si quieres llevarlo a otra parte.

En el extremo opuesto, Carrd ofrece una solución súper simple y barata para páginas de una sola sección (landings, páginas personales, enlaces múltiples). Es ideal para lanzar rápidamente una propuesta y ver si alguien se interesa.

Wix y Squarespace apuestan por la facilidad absoluta: plantillas modernas, asistentes guiados y funciones de e-commerce integradas para quien quiere una web funcional sin calentarse demasiado la cabeza con detalles técnicos.

Si tu base de datos está en Airtable y quieres convertirla en un portal, un marketplace privado o una intranet, Softr permite levantar sitios completos a partir de tus tablas, con logins, roles, filtros y vistas configurables, todo sin código.

Plataformas para crear apps web y móviles sin programar

Cuando tu idea exige algo más que una simple web, entran en juego las plataformas de creación de aplicaciones completas, con lógica, usuarios, pagos y flujos complejos.

Bubble es una de las opciones más potentes para construir apps web tipo SaaS, marketplaces, paneles internos o herramientas colaborativas. Te da control detallado sobre la lógica, permite integraciones con APIs externas y ofrece una gran flexibilidad en diseño.

FlutterFlow se apoya en Flutter, el framework de Google, para que puedas diseñar aplicaciones nativas y webapps con un editor visual. A medida que construyes la interfaz y la lógica, la plataforma genera código Flutter real que puedes exportar y modificar, lo que la convierte en una opción muy interesante si luego quieres evolucionar a desarrollo clásico.

Adalo se centra en apps móviles completas que puedes publicar en App Store y Google Play. Incluye base de datos propia, integraciones con servicios externos y la posibilidad de gestionar pagos, notificaciones y lógica sin escribir código.

Para quienes quieren transformar hojas de cálculo en apps sin fricción, Glide convierte datos de Google Sheets o Airtable en aplicaciones web funcionales en minutos. Es ideal para herramientas internas, directorios, catálogos o prototipos rápidos, con la limitación de que el diseño es más rígido.

WeWeb es una especie de mezcla entre Webflow y FlutterFlow, pensada para apps web muy personalizables que consumen un backend externo (por ejemplo, Xano). Es una buena apuesta cuando necesitas filtros complejos, autenticación, paneles ricos y quieres un frontend fino sin programar.

Toddle pone el foco en equipos de producto donde colaboran diseñadores e ingenieros. Su propuesta gira en torno a desarrollar aplicaciones web profesionales con gran foco en diseño y calidad del código generado.

BravoStudio encaja perfecto para diseñadores que trabajan en Figma o similares y quieren transformar sus prototipos de alta fidelidad en apps móviles nativas funcionales, sin perder la fidelidad visual del diseño original.

Bases de datos, backend visual y dashboards

Ningún proyecto mínimamente serio se sostiene solo con pantallas: necesitas una capa donde vivan los datos y la lógica de negocio. Ahí entran en juego herramientas no code y low code que hacen de columna vertebral.

Airtable es uno de los grandes referentes: combina hoja de cálculo y base de datos en una interfaz sencilla pero muy potente, con vistas Kanban, calendarios, galerías y automatizaciones básicas. Es perfecta para gestionar proyectos, leads, contenidos o inventarios y conectarla luego con tus apps.

Xano permite crear backends robustos sin escribir código, definiendo colecciones de datos, endpoints de API, reglas de negocio y autenticación. Se integra muy bien con frontends como WeWeb o FlutterFlow, y es ideal cuando necesitas un servidor más serio que una simple hoja de cálculo vitaminada.

Supabase, aunque tiene un componente más técnico, ofrece una interfaz visual sobre PostgreSQL, autenticación, almacenamiento de archivos y APIs listas para usar. Para equipos con algo de bagaje técnico, es una opción muy sólida como base de datos moderna.

Junto a estas, herramientas como Parabola se especializan en automatizar y transformar flujos de datos sin código: limpian, combinan y enriquecen información procedente de CRMs, tiendas online o hojas de cálculo, y devuelven resultados a donde los necesites.

Automatización avanzada e IA sin código

El ecosistema no code está estrechamente ligado a la IA generativa y a los agentes inteligentes. Muchas plataformas han incorporado asistentes que construyen flujos, tablas o pantallas a partir de descripciones en lenguaje natural.

En el ámbito de la automatización, Zapier sigue siendo el gran clásico: conecta miles de aplicaciones y ahora incluye un Copilot impulsado por IA que genera flujos automatizados describiendo lo que quieres conseguir.

Make (antes Integromat) ofrece escenarios muy visuales y flexibles, ideales para orquestar procesos complejos entre múltiples herramientas, con control sobre errores, ramas lógicas y transformaciones de datos.

n8n, por su parte, es una opción open source muy potente que puedes alojar tú mismo, ideal si quieres más control técnico, privacidad y personalización sin renunciar a un constructor visual de flujos.

En el territorio de la IA aplicada a datos, han surgido soluciones como Thunderbit, centrada en que usuarios no técnicos puedan raspar y estructurar información de la web con unos pocos clics y prompts, exportando luego a Excel, Sheets, Airtable o Notion sin escribir código.

No code para emprendedores: combinar herramientas para un MVP

Para lanzar un Producto Mínimo Viable (MVP) hoy en día no necesitas un equipo entero de desarrollo. Con una combinación inteligente de herramientas no code puedes salir al mercado en semanas, medir y decidir si merece la pena invertir más.

Un enfoque muy práctico es usar Airtable como columna vertebral de datos: allí almacenas usuarios, pedidos, feedback, contenidos o lo que sea clave para tu negocio, con vistas que te permitan analizar el crecimiento y las tendencias.

Para la parte visible, puedes optar por un constructor como Lovable, Webflow o Softr, que funcionan como cara pública del proyecto: página de presentación, formularios de contacto o de alta, primeras ventas, etc., todo diseñado con lenguaje natural y bloques visuales.

Entre bastidores, una herramienta como n8n, Zapier o Make actúa como sistema nervioso del MVP, conectando formularios con tu base de datos, disparando correos automáticos, alimentando dashboards o creando tareas en tu gestor de proyectos.

Como apoyo transversal, ChatGPT y otros asistentes de IA te ayudan a redactar prompts óptimos para estas herramientas, generar copys, estructurar bases de datos o incluso diseñar la lógica de tus flujos antes de implementarlos.

No code en la empresa: productividad, datos y colaboración

En organizaciones de cualquier tamaño, el no code se está usando para digitalizar procesos internos, reducir carga manual y dar autonomía a equipos no técnicos.

Equipos de ventas, por ejemplo, pueden automatizar la captación y el seguimiento de leads enlazando formularios, CRMs ligeros y campañas de email sin tener que esperar a que TI les arme todo el sistema.

Operaciones y finanzas pueden construir paneles a medida y flujos de aprobación usando Airtable, Kintone o Power Apps, conectados con sistemas existentes como Excel, SharePoint o ERPs, y así tener visibilidad en tiempo real sin depender de informes manuales.

Marketing, por su parte, gana velocidad montando páginas de aterrizaje, embudos y automatizaciones sin bloquear al equipo de desarrollo. Esto permite lanzar más experimentos, A/B tests y campañas con menor coste.

En todos los casos, las herramientas no code sirven para recortar tiempos de espera, disminuir errores manuales y liberar al equipo técnico para tareas de más valor, como arquitectura, seguridad o productos core.

Agentes de IA y sistemas multiagente sin necesidad de programar

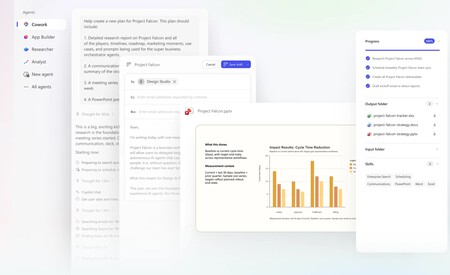

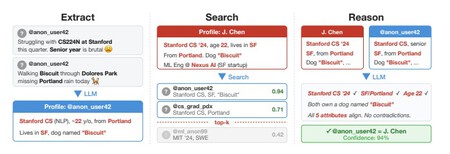

Más allá de las apps clásicas, el mercado se está moviendo hacia agentes de IA capaces de percibir su entorno, razonar y actuar de forma autónoma para alcanzar objetivos complejos.

Un modelo de lenguaje como GPT-4 es un motor de razonamiento pasivo; un agente, en cambio, es un sistema que combina ese modelo con memoria, acceso a herramientas (APIs, navegadores, bases de datos) y un objetivo concreto, ejecutando acciones en secuencia.

Existen diferentes tipos clásicos de agentes: desde los reactivos simples que siguen reglas “si-entonces”, pasando por los que mantienen modelos internos del entorno, hasta los agentes basados en objetivos y utilidades que planifican rutas óptimas, o los que aprenden de la experiencia para mejorar con el tiempo.

Con los LLM han aparecido los agentes generativos, que usan marcos como Chain of Thought (cadena de pensamiento) o ReAct (razonar + actuar) para descomponer problemas, llamar herramientas externas, observar resultados y ajustar su plan.

En la práctica, esto se traduce en sistemas donde un agente “Investigador” recopila información, otro “Analista” la procesa, un “Redactor” genera un informe y un “Crítico” revisa el resultado. Y lo interesante es que cada vez hay más frameworks y plataformas que permiten orquestar estos equipos de agentes con poco o ningún código, integrándolos en flujos de negocio reales.

Casos de uso habituales del no code

Con todas estas piezas, las posibilidades son enormes, pero hay algunos escenarios donde el no code encaja especialmente bien y ofrece mucho retorno con poco esfuerzo.

Uno de los más claros es la creación rápida de prototipos para startups: puedes montar una versión funcional de tu idea, ponerla delante de usuarios reales, aprender y decidir si merece la pena pasar a una solución más a medida.

También es muy útil para aplicaciones internas a medida dentro de empresas: pequeños sistemas de gestión, herramientas de reporting, portales de empleados o automatización de tareas recurrentes que antes se llevaban en Excel o correo.

Otro campo que se beneficia muchísimo es la automatización de tareas repetitivas: desde enviar resúmenes diarios de actividad a un equipo, hasta sincronizar inventarios entre varias plataformas de e-commerce, pasando por la generación de informes semanales sin intervención humana.

En marketing, las plataformas no code facilitan construir landings específicas para campañas, formularios de captación y secuencias de nurturing, integradas con CRMs y herramientas de emailing, lo que acorta el tiempo entre tener una idea y verla funcionando.

Para pequeñas empresas y autónomos, son una vía muy razonable para digitalizar procesos sin necesidad de grandes inversiones: reservas online, gestión de clientes, facturación básica, seguimiento de proyectos o automatización de comunicaciones.

El panorama actual deja claro que las herramientas no code y la IA asociada están cambiando cómo se diseñan, lanzan y escalan productos y procesos digitales. No sustituyen a los programadores, pero sí amplían quién puede crear soluciones y cómo se organiza el trabajo dentro de empresas y proyectos. Entender sus fortalezas, sus límites y cómo combinarlas con desarrollo tradicional te coloca en una posición muy ventajosa, tanto si estás empezando en el mundo tech como si quieres llevar tu negocio al siguiente nivel sin esperar seis meses a que llegue el proyecto “oficial”.

via Actualidad Gadget https://ift.tt/k01TEAY