Tenemos nuevo chatbot en la oficina. Se trata de Meta.ai, el asistente que la empresa de Mark Zuckerberg lanzó en septiembre de 2023 y que ahora gana enteros por dos motivos.

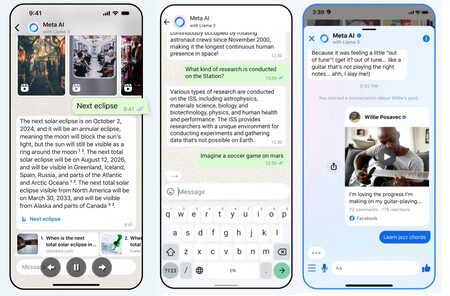

El primero, por estar basado en el nuevo modelo fundacional, Llama 3. Y el segundo, porque podemos usarlo en la web: ya no dependemos de su integración en apps como WhatsApp, Instagram, Facebook o Messenger.

Precisamente eso es lo que hemos querido hacer en Xataka, y tras estas primeras horas de uso ya tenemos unas impresiones sobre lo que puede dar de sí. La sorpresa no es que se comporte bien —que lo hace— sino que su verdadero potencial no está precisamente en la web: eso es solo "el caramelo" de Meta para poder competir con el resto de sus rivales en su terreno. Su ventaja es otra.

Cómo probar el chatbot de Meta.ai

Teóricamente solo se puede usar Meta.ai si estamos en Estados Unidos o alguno de los 13 países adicionales que han sido incluidos en el lanzamiento inicial, a saber: Australia, Canada, Ghana, Jamaica, Malawi, Nueva Zelanda, Nigeria, Pakistán, Singapur, Sudáfrica, Uganda, Zambia, y Zimbabwe.

Además, el chatbot se puede usar solo en inglés. En Meta indican que próximamente estará disponible en otros idiomas y regiones, pero por el momento esas son las limitaciones geográficas y de idioma que impone el servicio.

La limitación geográfica se puede superar fácilmente con una VPN. Es un método que ya nos ha funcionado en otras ocasiones para probar chatbots que también se lanzaban inicialmente en países como EEUU, y eso vuelve a cumplirse en esta ocasión: al conectarse a la VPN basta elegir algún nodo en uno de los países que el chatbot está disponible, y listo.

Nosotros usamos una conexión que simulaba que estábamos en Atlanta, tras lo cual apareció una página de inicio que nos animaba a utilizar algunos de los ejemplos de uso del chatbot, y que también nos instaba a preguntarle cualquier cosa a la IA de Meta.

Un chatbot difícilmente diferenciable de sus rivales

En una barra lateral izquierda contamos con un historial de conversaciones, y sobre todo una opción para iniciar sesión en Facebook, algo imprescindible para poder acceder a otra de las opciones interesantes de esta plataforma: generar imágenes por IA.

Nosotros nos centramos inicialmente en realidar algunas preguntas para evaluar sus respuestas. Tras comprobar que Meta.ai no habla español —el chatbot se disculpó y aseguró que en el futuro dispondría de ese soporte— preguntamos todo tipo de cosas.

Empezamos por algo de actualidad deportiva para saber cómo de actualizado estaba el chatbot. Contestó correctamente al preguntarle cuáles eran los próximos partidos de Champions League, mientras que al preguntarle cuál era el favorito para ganarla, dio respuestas basadas en un sitio de apuestas, una decisión curiosa pero ciertamente razonable.

También quisimos saber si tenía algún tipo de información sobre Xataka. Una vez más, respondió con rapidez y precisión. La descripción fue precisa e incluso añadió un dato en el que otros chatbots se habían equivocado en el pasado, el año en el que se fundó, 2004.

Para añadir más cuestiones informativas —y de nuevo, deportivas— le pedimos a Meta.ai algo que hemos pedido a otros chatbots que hemos evaluado en el pasado: que nos crease una tabla con los países que más campeonatos y segundos puestos habían logrado en los mundiales de fútbol.

Aquí el asistente de Meta hizo algo estupendo que ni siquiera le habíamos pedido: añadió los años en los que esos países ganaron los campeonatos que ganaron. No incluyó una columna más con los años de los subcampeonatos, y cuando se lo pedimos primero la creó aparte de la primera.

Sin embargo, tras pedirle que las uniera, realizó esa fusión para crear una tabla casi perfecta: había datos erróneos, como el subcampeonato de Francia de 1986 que no se produjo ese año sio en 2006. Luego volvió a lograrlo en el último Mundial de Qatar en 2022, pero ese dato sí lo indicó bien.

También quisimos pedirle a Meta.ai que resolviera algunos pequeños problemas matemáticos. En el primero de ellos falló: le preguntamos lo siguiente (traducido al inglés): "La suma de las edades de tres adultos es 60 años. El mayor de ellos tiene 6 años más que el menor. ¿Cuál es la edad de cada uno de ellos? Supongamos que un adulto tiene al menos 18 años". Respondió 18,24,24, lo que no era correcto.

Tanto ChatGPT como Claude 3 (en sus versiones gratuitas en la web) respondieron correctamente al problema. La solución es 18,18,24, y tras indicarle a Meta.ai que había cometido un error, volvió a intentarlo pero se equivocó de nuevo y dijo que la solución era 12,30,18. Señalado su error de nuevo, pidió la solución para entender qué estaba haciendo mal. Un detalle curioso que de nuevo demuestra que estos chatbots pueden acertar (o errar) pero sin saber cómo lo hacen.

Meta.ai sí respondió correctamente a otros pequeños problemas matemáticos, y también quisimos preguntarle otras cuestiones, por ejemplo cómo instalar una unidad SSD en un Mac mini. Respondió de forma correcta aunque algo imprecisa en algunos puntos.

Por ejemplo, al indicar "Asegúrate de que el SSD es compatible con tu modelo de Mac mini", no especificó más, pero al incidir en ese apartado sí nos ayudó siendo más concreto porque necesitaba más información. Un detalle curioso fue la inclusión de las herramientas necesarias, y aquí al preguntarle por las fuentes —que no aparecían inicialmente— indicó que sus datos provenían de la la web de soporte de Apple —probablemente, la mejor fuente posible, punto a favor de Meta.ai—, de la que ofreció hasta cinco enlaces distintos.

Estas pruebas demostraron un comportamiento que parece equiparable al que ofrecen otros chatbots del mercado. Las respuestas se generan con gran velocidad —más que ChatGPT 3.5, a la par que Claude 3, por ejemplo—, y su corrección y precisión es notable, aunque como siempre es posible que el chatbot cometa errores o incluso invente datos.

Para terminar, quisimos probar su toque creativo y ver cómo combinaba con otro modelo de IA especialmente llamativo en los últimos días. Quisimos crear una canción con Suno.ai y que la letra la compusiese Meta.ai. El tema, un pequeño guiño a esa guerra entre tabuladores y espacios que desde hace décadas mantienen los programadores.

El resultado, que podéis disfrutar en ese vídeo, es desde luego aparente, y demuestra que este tipo de sistemas puede acabar dando resultados sorprendentes. La cosa no paró ahí, y en Xataka quisimos probar un elemento más de este chatbot. Uno más creativo.

Generando imágenes con Meta.ai

Como comentábamos, otra de las opciones interesantes de este chatbot es que ofrece también la posibilidad de generar imágenes, algo que desde hace algún tiempo también permiten algunos de sus rivales. La opción hace necesario que iniciemos sesión en Meta (o creemos una cuenta), tras lo cual podremos crear imágenes con un "Imagine..." —el mismo comando que en Midjourney— aunque podemos usar otras fórmulas como "Generate an image" o "show a...".

También realizamos alguna prueba de generación de imágenes. El motor integrado en este chatbot es desde luego decente, aunque tiene un filtro especialmente notable que hace que muchas imágenes no se generen. Incluso términos o prompts inofensivos parecen provocar problemas, y por ejemplo intentamos generar una imagen con un hipotético Real Madrid ganando la Champions League este año y se negó a generarla.

A la izquierda, las imágenes generadas por Meta.ai. A la derecha, las imágenes extremadamente inclusivas que en su día generó Google con Gemini y que tanta polémica provocaron. Por cierto, atentos: Meta.ai integra una marca de agua visible en la esquina de las imágenes.

A la izquierda, las imágenes generadas por Meta.ai. A la derecha, las imágenes extremadamente inclusivas que en su día generó Google con Gemini y que tanta polémica provocaron. Por cierto, atentos: Meta.ai integra una marca de agua visible en la esquina de las imágenes.

Lo que sí hizo por ejemplo fue generar "una pareja alemana de 1820", que es precisamente el mismo prompt que hizo que hace unas semanas Gemini generara imágenes excesivamente inclusivas. Eso le costó un buen disgusto reputacional a Google, pero al menos en Meta no parece existir ese problema, y las imágenes, sin ser perfectas, al menos son razonables en su aspecto final.

El generador de imágenes es por tanto interesante como potencial ayuda para generar imágenes, pero creemos que no está a la altura de modelos específicos más potentes como Midjourney. Aquí nota curiosa: Meta.ai incrusta una pequeña marca de agua visible en la esquina inferior izquierda de las imágenes. Es una medida a la que están acudiendo otros como Google, Adobe u OpenAI.

El verdadero as en la manga de Meta.ai son sus plataformas móviles

Tras estas pruebas ha quedado claro que el comportamiento de Meta.ai no es especialmente diferente —tampoco especialmente peor y mejor, al menos, en estas pruebas— al que ofrecen otros chatbots que compiten en este mercado, y eso deja claro que hoy por hoy estas propuestas son difícilmente distinguibles a nivel de resultados a no ser que se usen de forma muy intensiva y en segmentos muy específicos.

Eso hace que para Meta la guerra por la IA se ponga tan al alcance (o no) como para el resto, pero aunque la disponibilidad de un chatbot en la web es interesante para quienes usan un PC, el verdadero potencial de este asistente está precisamente donde Meta lo introdujo inicialmente: en el móvil.

Es fácil entender por qué. El asistente de Meta.ai ya está disponible para algunos usuarios de Facebook, Instagram, Messenger o WhatsApp, pero poco a poco se irá desplegando en todo el mundo y estará disponible a tan solo un clic de estas aplicaciones.

Eso supone un oportunidad de crecimiento potencialmente enorme para la propuesta de Meta, que tiene a su alcance miles de millones de usuarios que aprovechan todas esas plataformas a diario —y de forma constante— y que podrían recurrir a Meta.ai por la sencilla razón de que está especialmente disponible en esas aplicaciones. No habría que salir de Instagram, Facebook o WhatsApp para preguntar cómo quedó ayer el Madrid o qué tiempo hará en Soria este fin de semana: podremos obtener respuesta a esas preguntas directamente desde esas plataformas.

Eso hace que junto al nuevo funcionamiento basado en Llama 3 estemos ante un fuerte candidato a chatbot de referencia. La batalla está servida, y cada vez parece más difícil prever quién la ganará.

En Xataka | Mark Zuckerberg anuncia el nuevo gran objetivo de Meta: crear una inteligencia artificial general

via Robótica e IA - Xataka https://ift.tt/TndV2c7