Anthropic lanzó esta semana Claude 3.7 Sonnet, su modelo más inteligente, el primero que razona... y el primer modelo "de razonamiento híbrido" del mercado.

He pasado unas cuantas horas probándolo en distintos escenarios para ver de qué es capaz, dónde brilla y si supone un avance importante respeto a 3.5 Sonnet. Y por supuesto, qué tal sale en la foto frente a otros razonadores como Grok 3 o los 'o' de OpenAI.

Razonamiento híbrido

Lo primero que llama la atención es el concepto de "razonamiento híbrido". A diferencia de OpenAI, que ofrece modelos separados para tareas de razonamiento profundo (o1, o3-mini), Anthropic ha integrado ambas capacidades en un único modelo:

- Modo estándar. Para respuestas rápidas y conversacionales.

- Modo de pensamiento extendido. Para problemas complejos que requieren razonamiento paso a paso.

En la interfaz web aparece un simple interruptor para alternar entre ambos modos. Los desarrolladores que usen la API pueden especificar un "presupuesto de pensamiento" en tokens (hasta 128K) para controlar el equilibrio entre velocidad y profundidad.

Como explica Anthropic: "Así como los humanos usamos un solo cerebro tanto para respuestas rápidas como para reflexiones profundas, creemos que el razonamiento debería ser una capacidad integrada de los modelos frontera en lugar de un modelo completamente separado".

Pensamiento extendido vs razonamiento estándar

Para poner a prueba esta nueva capacidad, decidí probarla con el clásico problema de Monty Hall, un rompecabezas de probabilidad famoso por ser contraintuitivo.

En modo estándar, Claude 3.7 dio una explicación correcta, pero concisa.

Claude 3.7 en razonamiento estándar. Imagen: Xataka.

Claude 3.7 en razonamiento estándar. Imagen: Xataka.Al activar el modo de pensamiento extendido, la diferencia fue grande: el modelo dedicó tiempo a analizar el problema desde varios ángulos, desarrollando el razonamiento paso a paso y, algo interesante, detectando y corrigiendo un error en su propio razonamiento inicial.

Claude 3.7 con el razonamiento extendido activado. El campo de texto con scroll que aparece entre pregunta y respuesta final es su largo proceso de razonamiento, que duró 57 segundos antes de pasar a escribir el veredicto. Imagen: Xataka.

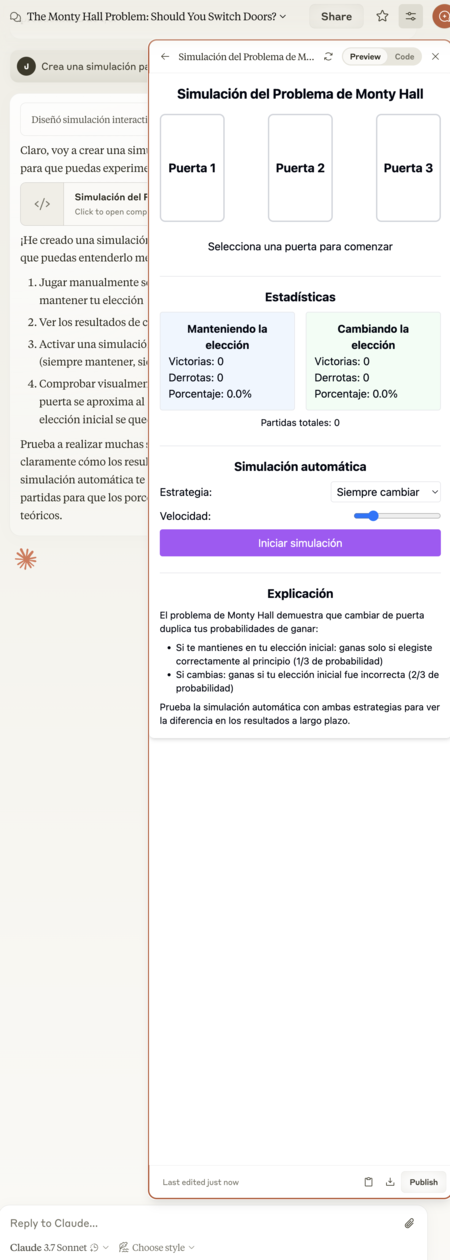

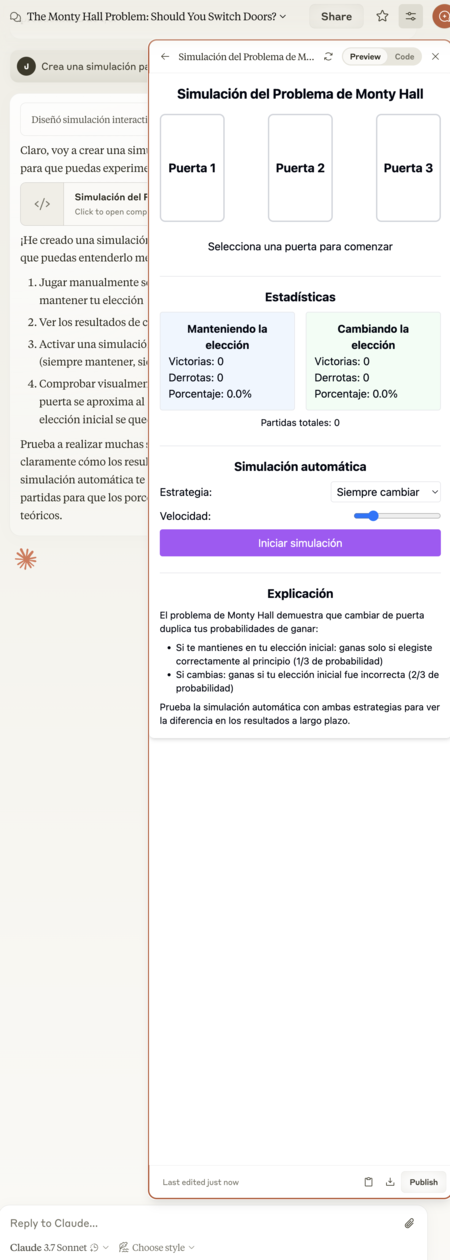

Claude 3.7 con el razonamiento extendido activado. El campo de texto con scroll que aparece entre pregunta y respuesta final es su largo proceso de razonamiento, que duró 57 segundos antes de pasar a escribir el veredicto. Imagen: Xataka.Más impresionante aún, cuando le pedí que creara una simulación para entender mejor el problema, Claude 3.7 generó un componente React interactivo que permitía jugar con el problema de Monty Hall directamente en la ventana de chat. Espectacular y muy bien ejecutado.

El componente React interactivo que creó Claude 3.7 para permitirme jugar con el problema de Monty Hall. Imagen: Xataka.

El componente React interactivo que creó Claude 3.7 para permitirme jugar con el problema de Monty Hall. Imagen: Xataka.Y para finalizar, le pedí que me generase el código adecuado para incrustarlo aquí y que los lectores de Xataka pudieran jugar a este problema por ellos mismos.

Pruebas matemáticas y razonamiento

Según los datos proporcionados por Anthropic, Claude 3.7 Sonnet muestra mejoras significativas en pruebas matemáticas como AIME (American Invitational Mathematics Examination). Es el mismo examen que le pasé a Grok 3.

Con el modo de pensamiento extendido, Claude 3.7 puede resolver alrededor 10 de sus 15 problemas. Grok 3 se quedó en 6. o3-mini-high, en 9. Minipunto para Claude 3.7.

La relación entre el tiempo de pensamiento y el rendimiento es directa: a más tokens de pensamiento, mejores resultados. Lo fascinante es que puedes ver todo el proceso de razonamiento en tiempo real, algo hasta ahora imposible en Claude. Mostrar el trabajo interno genera confianza y permite entender cómo llegó a sus conclusiones.

Más allá de las matemáticas, y como hice con Grok 3, le pedí analizar el impacto de la IA en el diseño de chips. Claude 3.7 incluye razonamiento, pero no una función equiparable a Deep Research. Solo quedaba activar el pensamiento extendido y a ver qué salía. Eso sí, activé también el modo de respuesta más extensa, que no es un 'Deep Research' pero tiene un enfoque algo similar.

Un fragmento de la respuesta en el modo más similar que tiene Claude 3.7 a los 'Deep Research' que hemos visto en OpenAI, Google o Grok: la combinación del pensamiento extendido y el tipo de respuesta explicativa, en lugar de la formal o la concisa. Imagen: Xataka.

Un fragmento de la respuesta en el modo más similar que tiene Claude 3.7 a los 'Deep Research' que hemos visto en OpenAI, Google o Grok: la combinación del pensamiento extendido y el tipo de respuesta explicativa, en lugar de la formal o la concisa. Imagen: Xataka.¿El resultado? Un texto de 807 palabras apropiado, correcto por lo general, pero poco profundo en comparación a otros. De hecho solo tardó cinco segundos en razonarlo, un síntoma de que apostó por lo genérico, lo evidente.

No mencionó siquiera AlphaChip, por ejemplo. Claude es potentísimo pero le sigue pesando su carencia de conexión a Internet y aquí se aprecia esa costura.

También le pedí un informe completo sobre Xataka a nivel financiero, mediático, reputacional, etc. Con la misma combinación activada: pensamiento extendido y respuesta explicativa.

Estuvo generalmente acertado y esta vez se extendió hasta las 1.508 palabras, con matices y algún derrape (como decir que nos compró Webedia en 2014, cuando fue en realidad en 2018; o un análisis erróneo del origen de nuestro nombre). Hasta hizo un DAFO que no estuvo nada mal como punto de partida.

Nuestro informe. Imagen: Xataka.

Nuestro informe. Imagen: Xataka.También mostró, como Grok 3, una limitación inherente a todo sistema Deep Research: sabe mucho de lo que hay en público, pero no tiene muchos insights, carece del ese conocimiento tangencial e intuitivo o fruto de conversaciones a puerta cerrada que tiene un experto.

Es fácil que estas omisiones o pequeños derrapes se le puedan colar a un inexperto, pero canta en cuanto lo lee alguien de ese campo.

Claude vs OpenAI y xAI

¿Cómo se compara Claude 3.7 con la competencia más directa?

Frente a OpenAI: A diferencia de OpenAI, que tiene múltiples modelos para diferentes necesidades (GPT-4, o1, o1-mini, o3-mini), Claude 3.7 ofrece un enfoque más unificado. No es que esté simplificado al máximo, pero al menos es un poco más intuitivo saber cuándo elegir cuál.

En cuanto a rendimiento, mientras que o1 es extremadamente potente para problemas de razonamiento puro, Claude 3.7 ofrece un mejor equilibrio entre pensamiento profundo y velocidad, todo dentro del mismo modelo. Claude es de hecho, en general, equilibrado y muy profundo a la hora de leer entre líneas y sacar conclusiones más allá de las que pueden ser evidentes. ChatGPT peca de cierta torpeza en comparación.

Comparado con Grok 3 de xAI: Grok 3 también ofrece un modo de pensamiento profundo, Claude es algo más consistente en mantener el contexto y seguir instrucciones complejas. Eso sí, Grok vapulea a Claude en cualquier asunto que implique actualidad.

No obstante, Claude está muy por encima de Grok en cuanto a producto. No es tan completo como ChatGPT en ese sentido, pero tiene proyectos, capacidad para guardar conversaciones, distintos submodelos, tipos de respuesta a elegir... Es mucho más versátil y usable en el día a día.

- Claude brilla en razonamiento matemático y profundidad emocional y humana.

- En cambio, se queda por detrás en cualquier cosa que implique acceder a Internet y estar actualizado. Tampoco permite personalizar el comportamiento del modelo, solo configurar levemente los estilos de respuestas, que no es exactamente lo mismo.

Claude Code

Por otro lado, Claude 3.7 incluye Claude Code como herramienta para asistir a desarrolladores. No soy uno de ellos, así que simplemente le he pedido que cree un minijuego para el navegador con el siguiente prompt:

Crea un juego para navegador, dándome el código para incrustarlo en un artículo de Xataka. El juego debe constar de un cubo en el que el jugador recoja letras que van cayendo del cielo, controlándolo con las flechas del teclado, añade flechas virtuales para los jugadores que acceden desde un móvil. El jugador solo puede recoger las letras que conforman 'XATAKA' (X, A, T, K). Cada letra correcta suma un punto, cada letra incorrecta resta dos puntos. Un marcador va actualizando la puntuación en tiempo rea, el marcador parte de cero y va aumentando y disminuyendo. Al llegar nuevamente a cero, el jugador pierde la partida y tiene que volver a empezar. El diseño debe ser retrofuturista, con neones, pero manteniendo una buena visibilidad y legibilidad de las letras, tonalidades que predominen: verdes y negros. Velocidad a la que caen las letras en aumento según pasa el tiempo. 600 pixeles de ancho.

Solo tuve que hacerle dos modificaciones posteriores:

- Que todas las letras sean verdes (Claude decidió que las incorrectas serían rojas).

- Que las letras que estaban cayendo sigan cayendo cuando el jugador recoge una, en lugar de desaparecer.

Pueden jugarlo ustedes, aquí está el resultado.

Pues muy bien.

La experiencia del pensamiento extendido

Lo que realmente distingue a Claude 3.7 es la experiencia de ver su proceso de pensamiento desplegarse en tiempo real. De una forma particularmente humana.

En el caso del problema de Monty Hall no solo dio toda la respuesta que mencioné (correcta, profunda, desglosada, hasta con un entorno multimedia con el que experimentar). También mostró cómo llegó hasta ella, incluyendo momentos en los que iba cuestionando sus suposiciones iniciales. Nuevamente, con puntos muy similares a tal y como los pensaría un humano ("¿Un momento, qué pasa con la oscuridad?").

Los desarrolladores tienen aquí una herramienta muy potente, pero que deben vigilar para que no se coma sus presupuestos. El precio por tokens de entrada y salida se mantiene respecto a Claude 3.5, pero el modo de pensamiento extendido dispara el consumo y por tanto los costes.

Por eso Anthropic ha activado la opción de fijar un presupuesto para el modo de pensamiento extendido de cara a evitar sustos en la factura.

Claude 3.7 es un avance gigante. Si hasta para alguien como yo, que no tiene ni idea de programar, ha podido convertir un triste prompt sin mucha precisión en un juego funcional, en menos de dos minutos, entiendo que Claude Code también está en esa cuerda.

El gran valor de Claude 3.7 no es tanto el de sus mejores incrementales, sino la atmósfera de trabajo que crea entre el chatbot y el humano. Es una experiencia más cálida que la del resto. De hecho cálidas son sus tonalidades de fondo y las correcciones de color de sus demos. Es intencional, es la contraposición al blanco nuclear de ChatGPT.

Claude 3.7 perfecciona lo que ya hacía 3.5: destilar naturalidad, profesionalidad y rigor con una precisión estupenda, con alta versatilidad y con un producto no tan profundo como ChatGPT, pero mucho mejor que el promedio de los chatbots.

Es lo más parecido a acercarse a la forma de pensar de un humano. Por sus razonamientos, y por sus análisis profundos, su mirada experta, su nivel intelectual abrumador capaz de explicarse muy bien. Su nubarrón es que tiende a consumir sus límites de uso demasiado pronto si estamos haciendo un uso intensivo, y nos deja unas horas esperando a que se reinicie el contador.

Claude 3.7 ya está disponible en la web y la app de Claude, y para desarrolladores a través de la API de Anthropic. Los usuarios de la versión gratuita pueden acceder al modelo base, pero el pensamiento extendido requiere una suscripción Pro.

Imagen destacada | Anthropic, Xataka con Mockuuups Studio

via Robótica e IA - Xataka https://ift.tt/d2jNtFO

No hay comentarios:

Publicar un comentario