Quizás recuerdes el caso. Hace poco menos de un año, en mayo de 2021, Jonas Bendiksen, fotoperiodista noruego, publicó un libro titulado 'The Book of Veles'. En apariencia se trataba de un catálogo de imágenes tomadas en la ciudad de Veles, en Macedonia del Norte. Curiosas y muy evocadoras, sí; pero poco más. Eso era en apariencia, claro. En realidad, Bendiksen había falseado con software las fotos, incluyendo incluso personajes generados con modelos 3D similares a los que se emplea en los videojuegos, en un intento por abrir un debate sobre la manipulación.

Para asombro de Bendiksen, sin embargo, el libro se distribuyó como un trabajo de fotoperiodismo al uso, una serie de imágenes totalmente verídicas que mostraban la realidad del ex satélite soviético. Incluso pasó los filtros del prestigioso festival internacional de Visa Pour L´Image, en Francia, sin que nadie notase el más mínimo engaño. Solo al final de todo terminó destapándose.

Lo que quería demostrar, explicaría más tarde, es algo que los medios de comunicación, la clase política y, cada vez más, la propia sociedad, tienen interiorizado: manipular imágenes y vídeos resulta muy fácil. Y efectivo. Tanto, que empieza a ser un problema inquietantemente común.

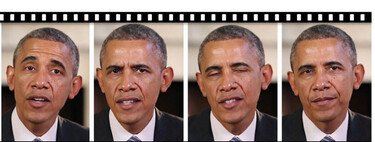

Un estudio de Sensity concluía el año pasado que en cuestión de seis meses la cantidad de deepfakes en circulación se había duplicado. Lo más grave es que solo el 7% se habían elaborado para el “entretenimiento”. Los mismísimos Obama o Trump han sido protagonistas de un tipo de manipulación que se utiliza con frecuencia para fines tan cuestionables e ilícitos como generar pornografía superponiendo el rostro de víctimas involuntarias o realizar estafas.

Objetivo: la confianza

En un intento por atajar el problema o crear al menos herramientas que permitan a medios y particulares destapar las manipulaciones, hace un tiempo algunas grandes firmas del sector tecnológico —Adobe, Arm, BBC, Intel, Microsoft y Truepic— lanzaron la Coalition for Content Provenance and Authenticity (C2PA). El movimiento aúna el trabajo de la Iniciativa de Autenticidad de Contenido (CAI), abanderada por Adobe; y Project Origin, impulsada a su vez por Microsoft y la BBC, y acaba de dar sus primeros frutos: la versión inicial de un estándar, una especie de “sello de garantía” que avala el material verídico y, de esa forma, ayuda a cazar deepfakes.

La idea pasa por habilitar un estándar abierto que puede integrarse en cualquier software, dispositivos o plataformas online y ayude a acreditar la procedencia y estructura del material, definir la información asociada a cada imagen, vídeo o audio, por ejemplo, y cómo se almacena.

“C2PA permite a los autores vincular de forma segura declaraciones de datos de procedencia utilizando sus credenciales únicas. Estas declaraciones se denominan aserciones por C2PA. Pueden incluir afirmaciones sobre quién, cómo, cuándo y dónde se creó el contenido. También sobre cuándo y cómo se editó. El autor del contenido y el editor —si es el autor de los datos de procedencia— siempre tiene el control sobre si incluir datos de procedencia, así como sobre las aseveraciones que se añaden”, detalla la propia coalición de empresas tecnológicas en su web oficial.

Los responsables del proyecto alertan que, a día de hoy, los creadores que desean incluir metadatos sobre su trabajo —la autoría, sin ir más lejos— “no pueden hacerlo de forma segura, a prueba de manipulaciones y estandarizada en todas las plataformas”, lo que complica que los editores tengan un “contexto crítico” para confiar en la autenticidad del material. Para solucionarlo, Adobe y el resto de firmas embarcadas en C2PA busca ofrecer “indicadores de autenticidad” que ayude a saber, llegado el caso, quién ha alterado una foto y qué ha cambiado exactamente.

“Esta capacidad de proporcionar la procedencia es esencial para facilitar la confianza”, reflexiona C2PA, que aclara que su objetivo es “permitir la adopción global y voluntaria de técnicas de procedencia digital a través de la creación de un rico ecosistema de aplicaciones”.

La pregunta del millón: ¿Cómo se consigue?

Eso, y ¿Cómo pretende C2PA establecer esa confianza?

La clave para en gran medida por el uso de credenciales de firmas únicas que gracias a una autoridad de certificación (CA) acredita que una persona es quien asegura ser. El proceso no es muy distinto al que ya se usa en la World Wide Web (WWW) y su objetivo es evitar que haya atacantes que suplanten una identidad. “Por ejemplo, antes de emitir un certificado para https://c2pa.org/, la CA verificó que el solicitante controlaba de hecho el nombre de dominio de C2PA antes de emitir un certificado para ese nombre de web”, relata, a modo de ejemplo, la propia coalición.

“Los datos de procedencia y el activo son las dos partes de un mismo rompecabezas, uno único. La posibilidad de que alguna otra pieza coincida, ya sea por coincidencia o por una creación intencional, es tan baja que sería prácticamente imposible. Se conoce como enlace duro. En otras palabras, cualquier alteración del activo o de la procedencia, por insignificante que sea, alteraría el algoritmo matemático, la forma de pieza del rompecabezas, de tal manera que ya no coincidiría”.

¿Para qué sirve esa garantía en la práctica? Pues básicamente para tener una idea precisa de quién ha creado el archivo o si se ha modificado. Imagínate, por ejemplo, que un amigo te envía un vídeo con un contenido controvertido. Si cumple con el estándar C2PA podrás ver —con una aplicación habilitada para C2PA— si ha sido validado por una organización de la que puedas fiarte. Podrás hacerlo porque el vídeo se habrá tomado con una cámara habilitada que, entre otras cosas, habrá creado un manifiesto con información sobre el propio dispositivo y hash criptográficos.

Algo similar pasaría con una red social. Gracias a la procedencia C2PA, la plataforma puede verificar si una foto proviene de la misma fuente que lo publicó. El objetivo: “Establecer la confianza”.

"Es un paso monumental para los creadores, editores y consumidores de todo el mundo", reflexionaba Andy Parsons, de CAI de Adobe, poco después de la presentación del C2PA: "Continuaremos impulsando la conciencia de la industria sobre la importancia de la procedencia y trabajaremos para buscar una adopción amplia para combatir el aumento de contenido no auténtico". El reto ahora pasa, precisamente, por lograr el uso generalizado del estándar.

No es la primera vez que Adobe muestra interés en los efectos del deepfake. El otoño pasado presentó por ejemplo Project Morpheus, que permite ajustar la apariencia de las personas en los vídeos, cambiando su expresión facial. La herramienta tiene aplicaciones interesantes, por ejemplo, para profesionales de la edición; pero también puede usarse en la propaganda política.

via Robótica e IA - Xataka https://ift.tt/ps9NSBh

No hay comentarios:

Publicar un comentario