Abres el móvil y, en pocos segundos, te ves a ti mismo dentro de una escena que no existía hace un minuto: eres el protagonista de un clip que parece rodado de verdad, con movimientos y rebotes que se sienten coherentes. La mecánica no tiene misterio, grabas una breve toma para capturar tu voz y tu cara, y la app te “coloca” en el escenario. Lo llamativo es la sensación de control, puedes encadenar planos y mantener el estado del mundo sin que nada se desmorone. Ahí empieza el juego de Sora 2.

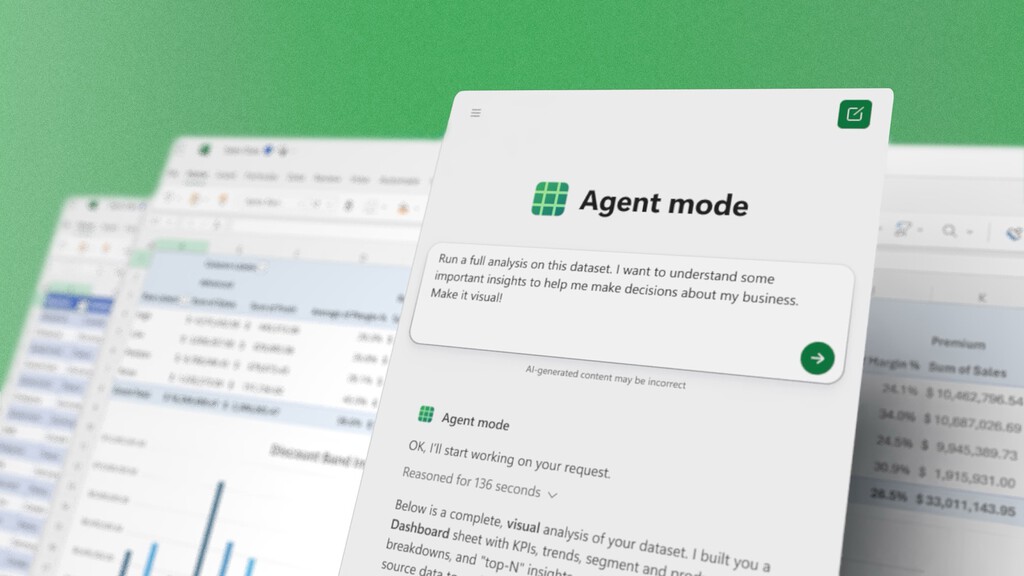

Para entender qué supone Sora 2 conviene mirar atrás. El camino se abrió en 2022, cuando ChatGPT colocó la generación de texto en el centro del debate tecnológico. Aquel impulso dio paso a modelos de imágenes y, en febrero de 2024, a la primera versión de Sora, un prototipo que ya mostraba permanencia de objetos y cierta coherencia visual. La competencia no tardó en reaccionar: Runway con su Gen-4 y otros proyectos marcaron la pauta de un mercado en plena ebullición que ahora recibe un nuevo capítulo.

Qué hay de nuevo en Sora 2. OpenAI describe este modelo como un salto comparable al que en su día supuso GPT-3.5 para el texto. La gran diferencia está en la fidelidad física: si una pelota falla el aro, rebota en el tablero en lugar de teletransportarse, un error común en sistemas anteriores. También puede mantener el estado de una escena entre planos y seguir instrucciones más complejas. Además de vídeo, genera voces, efectos y paisajes sonoros, lo que lo convierte en una herramienta de vídeo-audio mucho más completa.

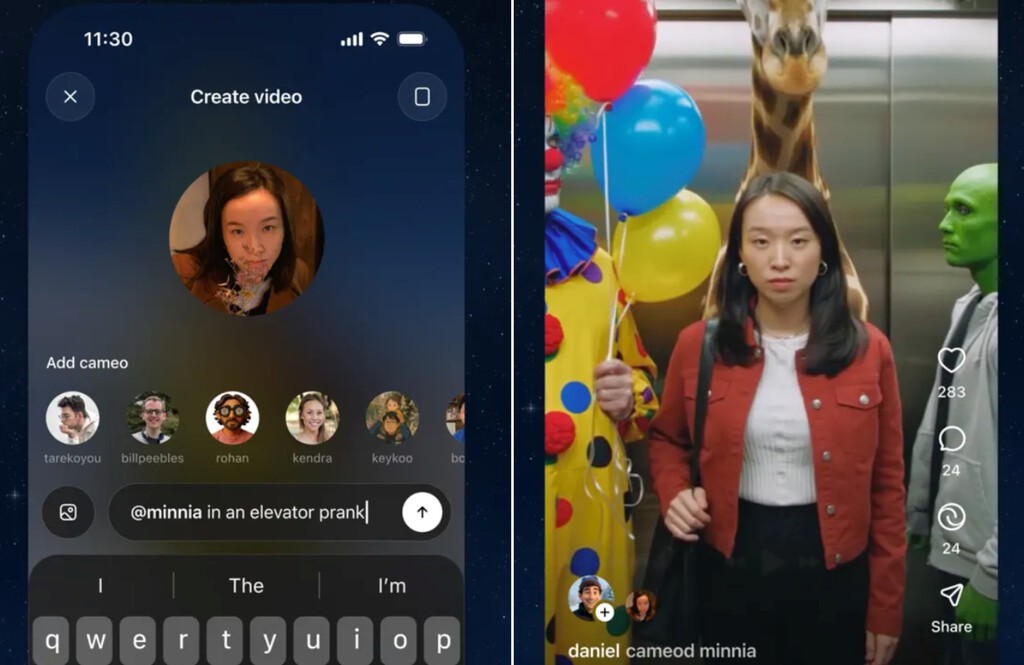

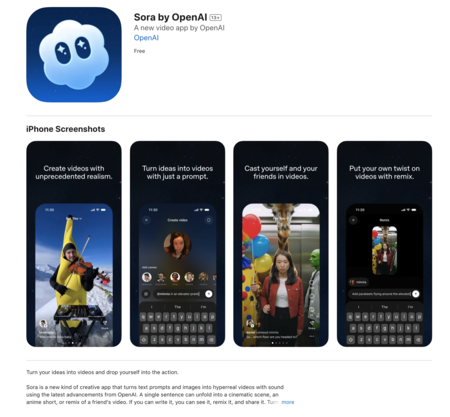

La app: cameos, remix y feed. junto con el modelo llega una aplicación pensada para usarlo en clave social. Tras una verificación rápida de rostro y voz, el usuario puede insertarse como cameo en cualquier escena y compartir el resultado con sus contactos. La app permite remezclar vídeos de otros y navegar por un feed que se ajusta a las preferencias mediante lenguaje natural. OpenAI asegura que la experiencia está diseñada para fomentar la creación conjunta, no el consumo pasivo, y que se estrena bajo invitación en iOS.

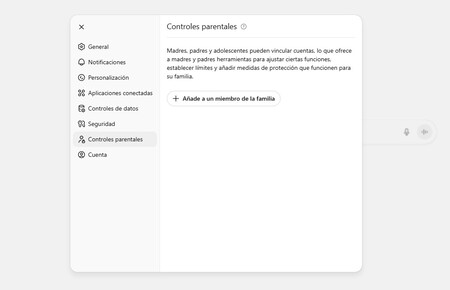

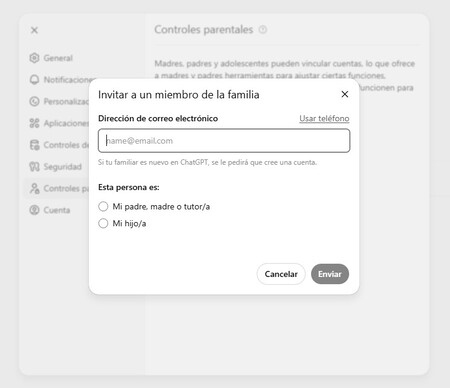

Bienestar y seguridad: controles y límites. La compañía liderada por Sam Altman insiste en que su aplicación no busca atrapar al usuario en un scroll infinito. Está diseñada para priorizar a personas conocidas y fomentar la creación más que el consumo. Para los adolescentes se aplican restricciones de base, como un número limitado de generaciones y permisos más estrictos en cameos. A esto se suman controles parentales desde ChatGPT y la posibilidad de revocar cualquier uso de tu imagen. También habrá moderadores humanos para casos de acoso.

¿Es gratis? Como decimos, la aplicación de Sora 2 se estrena de forma gradual en iOS, con un despliegue inicial en Estados Unidos y Canadá. OpenAI promete extenderla a más países, aunque de momento no está disponible en España. El acceso requiere invitación. El servicio arranca de manera gratuita, con límites de uso que dependen de "la capacidad de cómputo". Además, los suscriptores de ChatGPT Pro, el plan de 200 dólares mensuales, tienen acceso a una versión Sora 2 Pro con mayor calidad, y la compañía prevé habilitar el modelo vía API.

Algunos fallos permanecen. Entre los ejemplos que podemos ver en el vídeo que acompaña este artículo aparecen combates de anime, exploradores que gritan bajo una ventisca o acrobacias que respetan la rigidez y la flotación. El modelo consigue dar la impresión de que los fallos pertenecen al propio personaje, no al algoritmo. Aun así, OpenAI admite que los errores abundan y que la coherencia general está lejos de ser perfecta, aunque considera que el avance respecto a Sora 1 es evidente.

Sora 2 plantea un escenario en el que los vídeos dejan de ser solo un producto de consumo y pasan a ser un espacio de juego compartido. La clave está en esa capacidad de convertir a cualquiera en protagonista de un clip listo para circular. Puede que sea una moda de corta duración o que inaugure una etapa de creatividad más participativa. Lo que sí parece claro es que OpenAI ha vuelto a situar el foco en el usuario cotidiano, como hizo con ChatGPT y las imágenes estilo Studio Ghibli, con una propuesta pensada para desencadenar oleadas de contenido viral.

Imágenes | OpenAI

via Robótica e IA - Xataka https://ift.tt/8k1sGnM