Se respira incertidumbre y miedo. No sabemos cuánto y sobre todo cuándo se producirá el impacto de la inteligencia artificial en el mundo del trabajo, pero todo apunta a que tarde o temprano (y quizás más temprano que tarde), ese impacto será notable. Eso es al menos lo que vuelve a decirnos Sam Altman, CEO de OpenAI, que de esto sabe un poco.

El impacto estará ahí. En una reciente entrevista con The Atlantic, Altman explicaba que "Mucha gente que trabaja en IA pretende que [la revolución de la IA] sólo va a ser buena; que sólo va a ser un complemento; que nunca se va a sustituir a nadie". Él era mucho más crudo y apuntaba a que "los puestos de trabajo van a desaparecer, y punto".

La pregunta del millón. Por supuesto, lo interesante de verdad es saber qué sectores y profesiones serán las más afectadas. En marzo de 2023 varios investigadores de OpenAI y de la Universidad de Pennsylvania publicaron un estudio que trataba de dar una respuesta preliminar a esa pregunta. Las respuestas no eran especialmente claras, pero parecían indicar que los traductores e intérpretes estarían más afectados que otros como los escritores (que también se verán muy impactados) o los profesionales del mundo de las encuestas.

Lo difícil es saber qué profesiones no estarán impactadas. Ese mes de marzo Ed Gelten, profesor de tecnología de la información en Princeton, publicó otro estudio del mismo estilo. Entre las profesiones más afectadas según sus datos estaban los abogados, los profesores, los jueces o los gestores financieros, por ejemplo. Como en el caso anterior, el impacto se parece extender a prácticamente todos los ámbitos, por lo que lo difícil es saber qué profesiones estarían a salvo de esa teórica revolución del mundo del trabajo.

Pero todo será para bien. A pesar de que el impacto existirá y habrá profesiones que según Altman desaparecerán, el CEO de OpenAI también explicaba cómo ese cambio en nuestro mundo será para bien. "No creo que queramos volver atrás" porque aunque unas profesiones morirán, habrá trabajos mucho mejores que se crearán a raíz de dicha revolución. Altman explicaba cómo aún así los profesores serán un tipo de profesionales que quizás estén más a salvo por una razón: la gente siempre preferirá que les enseñe un ser humano.

Una revolución más rápida que otras. Aunque se han vivido otras revoluciones muy importantes que han afectado al mundo del trabajo, los cambios han tardado mucho en ser patentes. Para Altman los cambios que plantea la IA se producirán "más rápido que en el pasado".

Falacia de la porción de trabajo. Aquí recomiendo leer el excelente artículo que el analista Benedict Evans publicó a principios de julio y que meditaba sobre este tema. Él mencionaba por ejemplo la falacia de la porción (o escasez) de trabajo, que es la idea errónea de que hay una cantidad fija de trabajo por hacer, y que si parte del trabajo lo realiza una máquina, habrá menos trabajo para las personas. Y sin embargo, como él decía:

"Pero si resulta más barato utilizar una máquina para fabricar, por ejemplo, un par de zapatos, entonces los zapatos son más baratos, más gente puede comprar zapatos y tienen más dinero para gastar en otras cosas además, y descubrimos nuevas cosas que necesitamos o queremos, y nuevos puestos de trabajo...".

Así pues, es probable (como ha ocurrido en el pasado) que aunque se destruyan trabajos, se creen muchos otros nuevos que estén destinados a ofrecernos esas nuevas cosas que necesitaremos o querremos en el futuro.

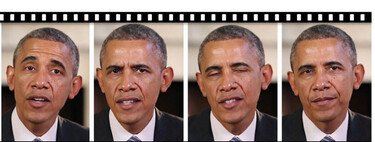

Imagen | Arno Senoner | TechCrunch

via Robótica e IA - Xataka https://ift.tt/8mvGIlN