viernes, 28 de febrero de 2020

jueves, 27 de febrero de 2020

Amazon ha comenzado a utilizar inteligencia artificial en lugar de humanos para su servicio de atención al cliente

Los servicios de atención al cliente no tienen la mejor de las reputaciones. A menudo las largas esperas y la falta de una correcta comunicación hacen que la experiencia empeore. Humanos que atiendan cada caso al momento y de forma personal ha sido una de las mejores soluciones que se han encontrado hasta ahora. Amazon, por su parte, ve en la IA una alternativa.

Tal y como han anunciado, el gigante tecnológico ha comenzado a implementar dos sistemas basados en inteligencia artificial para gestionar las consultas de los clientes. Uno de estos sistemas se dedica a ayudar a humanos que traban en soporte técnico encontrando rápidamente soluciones que puedan ofrecer, el otro directamente interactúa con el cliente y soluciona problemas sin intervención humana.

Amazon ha explicado que de momento los dos sistemas ya se han utilizado tanto en pruebas internas como con consultas de clientes reales. Se han estado utilizando por ejemplo para las solicitudes de reembolso de los clientes y para las cancelaciones de pedidos ya hechos.

Más allá de seguir un diagrama de flujos

La automatización de los servicios de atención al cliente, a día de hoy, generalmente ha significado un robot haciendo dos o tres preguntas para finalmente remitir a un humano. Amazon dice que no es su caso, utilizan aprendizaje automático para decidir qué responder, en lugar de utilizar unas reglas predefinidas en un diagrama de flujos. Esto, como en todo, habría que verlo en la práctica y no sólo en la teoría.

Jared Kramer, responsable del proyecto, explica que "no somos conscientes" de que se utilicen modelos basados en redes neuronales para conversaciones de extremo a extremo en servicios de atención al cliente. En principio, la IA puede ir aprendiendo cómo interactuar mejor y qué tipo de respuestas son más útiles a medida que conversa más y más con los clientes.

¿Y cómo hace para conversar con ellos? Amazon explica que ahora mismo la IA utiliza una plantilla de respuestas que modifica ligeramente (nombres, productos, fechas...) para adaptar a cada caso y cliente. Planean utilizar sistemas generativos para que la propia IA comience a crear respuestas en el contexto de cada conversación. Si bien no se ha confirmado, puede que utilicen el generador de voz sintética que ya dieron a conocer en 2019.

Poco a poco Amazon está automatizando cada vez más áreas de sus negocios. Un ejemplo claro y directo son las tiendas Amazon Go sin cajeros, pero también utiliza robots para la logística de sus almacenes. Como respuesta a esto, una de las medidas que tomaron en 2019 era invertir 700 millones de dólares para formar de nuevo a los empleados de EE.UU. que vean sus trabajos peligrar por la automatización.

Vía | Amazon

via Magazine - robotica-e-ia https://ift.tt/3a9GY2M

lunes, 24 de febrero de 2020

Llegan las fábricas sin cables

via Robótica https://ift.tt/38QByt8

Un agricultor autómata

via Robótica https://ift.tt/38V6R65

jueves, 20 de febrero de 2020

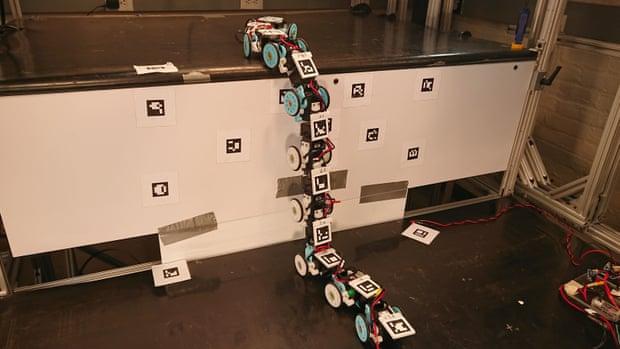

Serpientes robots o saltamontes cíborgs: el futuro de las labores humanitarias

En el amor y en la guerra no hay enemigo suficientemente pequeño. Y en las labores humanitarias toda ayuda es poca. Cada vez más se emplean artilugios y aparatos electrónicos para agilizar los rescates tras un desastre. Tecnologías que empiezan a ser herramientas cotidianas en este campo. Ya se utilizan drones desde hace tiempo. Aeronaves no tripuladas que prestan sus capacidades para intentar avistar a supervivientes en una tragedia o para trazar las líneas geoestratégicas delimitando zonas de investigación. En ocasiones emplean georadares y sensores de calor para afinar las búsquedas. Y su uso va a más. Pero, en el futuro, muy probablemente se tenga como compañero de fatigas robots y dispositivos con autonomía. Un grupo de ingenieros mecánicos de la Universidad Johns Hopkins en EE.UU. han desarrollado una serpiente robótica que se mueve con gran rapidez. Como si fuera un animal real, el dispositivo es capaz de subir todo tipo de superficies de una manera ágil y estable. Avances que permitirían, en opinión de sus desarrolladores, ayudar en los rescates, que son situaciones de riesgo en donde hay que ser rápido en la toma de decisiones. Los expertos confían en las habilidades de las máquinas para estos fines. Se espera, de hecho, que los robots algún día puedan ayudar a explorar terrenos inaccesibles, como los escombros acumulados después de un terremoto. Sus creadores se han inspirado, como otras tantas veces a lo largo de la historia de la tecnología, en la propia naturaleza a la ahora de abordar las distintas soluciones que se plantean en la sociedad. «Buscamos inspiración en estas criaturas espeluznantes porque ya son muy hábiles para escalar obstáculos de manera estable en su día a día. Esperemos que nuestro robot pueda aprender a balancearse a través de superficies como una serpiente real», señala en declaraciones a la revista «Royal Society Open Science» Chen Li, profesor asistente de ingeniería mecánica en la Universidad Johns Hopkins y autor principal de la investigación. No es la primera vez que se observa el comportamiento natural de los reptiles para emularlo de manera mecánica. Estudios anteriores habían analizado principalmente los movimientos de serpientes en superficies planas, pero rara vez en terreno abrupto y tridimensional. Los investigadores estudiaron en el laboratorio cómo la serpiente común, cuyo hábitat se encuentra principalmente en desiertos y densos bosques, podía superar obstáculos en forma de escalones. «Estas serpientes tienen que viajar regularmente a través de cantos rodados y árboles caídos: hay mucho que podemos aprender de ellas», añade. Los ingenieros observaron detenidamente las porciones del cuerpo de la serpiente que se retorcían para ganar estabilidad de cara a intentar replicar su comportamiento de manera mecánica. Al margen de la imitación de las habilidades naturales de los animales, en los últimos años también se han producido importantes avances en la integración de tecnología en cuerpos vivos. Una serie de experimentaciones que han llevado a reimaginar a los androides. En ese contexto, un grupo de científicos de la Universidad de Washington han probado a instalar chips en las antenas de los saltamontes diseñados para detectar la presencia de armas biológicas en un conflicto bélico. Insectos robots preparados para múltiples tareas de defensa. El proyecto ha empleado saltamontes de la especie Schistocerca americana. Los investigadores demostraron que las señales del cerebro de un insecto se pueden utilizar directamente para detectar y distinguir vapores químicos utilizados en explosivos. Lo que hicieron fue instalar una serie de microchips para ampliar las señales olfativas de estos insectos y que reciben a través de sus peculiares antenas. Según el estudio, se cree que cada saltamontes tiene más de 50.000 de estas neuronas.

En el amor y en la guerra no hay enemigo suficientemente pequeño. Y en las labores humanitarias toda ayuda es poca. Cada vez más se emplean artilugios y aparatos electrónicos para agilizar los rescates tras un desastre. Tecnologías que empiezan a ser herramientas cotidianas en este campo. Ya se utilizan drones desde hace tiempo. Aeronaves no tripuladas que prestan sus capacidades para intentar avistar a supervivientes en una tragedia o para trazar las líneas geoestratégicas delimitando zonas de investigación. En ocasiones emplean georadares y sensores de calor para afinar las búsquedas. Y su uso va a más. Pero, en el futuro, muy probablemente se tenga como compañero de fatigas robots y dispositivos con autonomía. Un grupo de ingenieros mecánicos de la Universidad Johns Hopkins en EE.UU. han desarrollado una serpiente robótica que se mueve con gran rapidez. Como si fuera un animal real, el dispositivo es capaz de subir todo tipo de superficies de una manera ágil y estable. Avances que permitirían, en opinión de sus desarrolladores, ayudar en los rescates, que son situaciones de riesgo en donde hay que ser rápido en la toma de decisiones. Los expertos confían en las habilidades de las máquinas para estos fines. Se espera, de hecho, que los robots algún día puedan ayudar a explorar terrenos inaccesibles, como los escombros acumulados después de un terremoto. Sus creadores se han inspirado, como otras tantas veces a lo largo de la historia de la tecnología, en la propia naturaleza a la ahora de abordar las distintas soluciones que se plantean en la sociedad. «Buscamos inspiración en estas criaturas espeluznantes porque ya son muy hábiles para escalar obstáculos de manera estable en su día a día. Esperemos que nuestro robot pueda aprender a balancearse a través de superficies como una serpiente real», señala en declaraciones a la revista «Royal Society Open Science» Chen Li, profesor asistente de ingeniería mecánica en la Universidad Johns Hopkins y autor principal de la investigación. No es la primera vez que se observa el comportamiento natural de los reptiles para emularlo de manera mecánica. Estudios anteriores habían analizado principalmente los movimientos de serpientes en superficies planas, pero rara vez en terreno abrupto y tridimensional. Los investigadores estudiaron en el laboratorio cómo la serpiente común, cuyo hábitat se encuentra principalmente en desiertos y densos bosques, podía superar obstáculos en forma de escalones. «Estas serpientes tienen que viajar regularmente a través de cantos rodados y árboles caídos: hay mucho que podemos aprender de ellas», añade. Los ingenieros observaron detenidamente las porciones del cuerpo de la serpiente que se retorcían para ganar estabilidad de cara a intentar replicar su comportamiento de manera mecánica. Al margen de la imitación de las habilidades naturales de los animales, en los últimos años también se han producido importantes avances en la integración de tecnología en cuerpos vivos. Una serie de experimentaciones que han llevado a reimaginar a los androides. En ese contexto, un grupo de científicos de la Universidad de Washington han probado a instalar chips en las antenas de los saltamontes diseñados para detectar la presencia de armas biológicas en un conflicto bélico. Insectos robots preparados para múltiples tareas de defensa. El proyecto ha empleado saltamontes de la especie Schistocerca americana. Los investigadores demostraron que las señales del cerebro de un insecto se pueden utilizar directamente para detectar y distinguir vapores químicos utilizados en explosivos. Lo que hicieron fue instalar una serie de microchips para ampliar las señales olfativas de estos insectos y que reciben a través de sus peculiares antenas. Según el estudio, se cree que cada saltamontes tiene más de 50.000 de estas neuronas.via Tecnología https://ift.tt/2SG5jqU

miércoles, 19 de febrero de 2020

La Estrategia Digital Europea y el Libro Blanco de Inteligencia Artificial ya son oficiales: estas son sus claves

La Unión Europea acaba de hacer oficiales la Estrategia Digital Europea y el Libro Blanco de Inteligencia Artificial. En el primero de los documentos, la UE busca explicar su visión de un "mercado único de datos" y "atajar los problemas identificados a través de medidas políticas y financiación. En el Libro Blanco de Inteligencia Artificial, el organismo busca poner sobre la mesa las "opciones de políticas" para promover la asimilación de la IA y abordar los riesgos asociados a ciertos usos de esta nueva la tecnología".

Ambos documentos son accesibles a través de la web del Parlamento Europeo y, por el momento, solo están disponibles en inglés. Son documentos densos, así que en los próximos párrafos vamos a desglosar las ideas clave de cada uno de ellos.

Las claves de la Estrategia Digital Europa: problemas y medidas

De acuerdo a la UE, la Estrategia Digital Europea responde a ocho problemas principales, que pasamos a exponer a continuación con un pequeño resumen:

- La disponibilidad de los datos: "el valor de los datos radica en su uso y reutilización. Actualmente no hay suficiente datos disponibles para una reutilización innovadora, incluso para el desarrollo de la inteligencia artificial".

- Desequilibrios en el poder del mercado: "además de la alta concentración en la prestación de servicios en la nube y las infraestructuras de datos, también hay desequilibrios de mercado en relación con el acceso y la utilización de datos, por ejemplo cuando se trata del acceso a los datos por parte de las PYMES".

- Interoperabilidad y calidad de los datos: "debe fomentarse la aplicación de formatos y protocolos compatibles estándar y compartidos para reunir y procesar datos de diferentes fuentes de manera coherente e interoperable en todos los sectores y mercados verticales".

- Gobierno de los datos: "para que estos espacios de datos sean operativos, se necesitan enfoques y estructuras organizativas (tanto públicas como privadas) que permitan la innovación impulsada por los datos sobre la base del marco jurídico existente".

- Infraestructura de datos y tecnologías: "la UE necesita reducir sus dependencias tecnológicas en estas infraestructuras estratégicas".

- Potenciación de los individuos para que ejerzan sus derechos: "los individuos valoran el alto nivel de protección que otorga el GDPR y la privacidad electrónica. Sin embargo, sufren de la ausencia de instrumentos y normas técnicas que hagan que el ejercicio de sus derechos sea sencillo y no excesivamente oneroso".

- Habilidades y conocimientos de datos: "el nivel de conocimiento general de los datos en la fuerza de trabajo y en toda la población es relativamente bajo y existen lagunas en la participación (por ejemplo, de las personas de mayor edad)".

- Ciberseguridad: "en la esfera de la seguridad cibernética, Europa ha desarrollado un amplio marco para ayudar a los Estados Miembros, las empresas y los ciudadanos a hacer frente a las amenazas a la seguridad cibernética y ataques, y Europa seguirá desarrollando y mejorando sus mecanismos para proteger sus datos y los servicios que se basan en ellos".

Dichos problemas quieren abordarse a través de medidas políticas y financiación que la Unión Europea resumen en cuatro acciones principales. La primera es la creación de un marco de gobernanza intersectorial para el acceso y la utilización de los datos. En ese sentido, la UE propone:

- Crear un "marco legislativo operativo para la gobernanza de los espacios comunes de datos europeos" que llegará en el cuarto trimestre de 2020. La idea es que se pueda usar para tomar decisiones en torno a qué datos pueden usarse en según qué situaciones, facilitar a utilización transfronteriza y dar prioridad a los requisitos de interoperabilidad.

- Implementar una "ley de aplicación de los conjuntos de datos de alto valor" en el primer trimestre de 2021 basada en la Directiva de Datos Abiertos. Su objetivo es abrir los conjuntos de datos de referencia del sector público, es decir, ponerlos a disposición de los usuarios de forma gratuita en toda la UE, convirtiéndolos a un formato legible por las máquinas a través de APIs estandarizadas.

- En la línea con lo anterior, la UE estudiará la necesidad de adoptar medidas legislativas sobre las cuestiones que afectan a las relaciones entre los agentes de la economía de la información a fin de ofrecer incentivos para el intercambio horizontal de datos entre los sectores.

- Todo esto se contemplará en la Data Act (2021).

La segunda estrategia de la Unión Europea se resume en "Habilitadores" y básicamente consiste en inversiones en datos y en el fortalecimiento e infraestructuras de Europa para el "alojamiento, procesamiento y utilización de los datos y su interoperabilidad". Entre las medidas que se contemplan están las siguientes:

- En el periodo 2021-2017, la Comisión invertirá en "Proyectos de Alto Impacto" en los espacios de datos europeos y en las infraestructuras de nubes federadas. Eso se resumen en invertir en infraestructura, herramientas de intercambio de datos, arquitecturas y mecanismos de gobernanza que faciliten el intercambio de datos y, por lo tanto, los ecosistemas de inteligencia artificial. Este proyecto sumará entre cuatro y seis billones de euros, de los cuales dos billones los pondrá la comisión y el resto la industria y los Estados Miembros. Se prevee que la primera implantación se ejecute en 2022.

- Este proyecto se presentará en marzo de 2020 como parte de una "estrategia industrial" que contemplará un "amplio abanico de inversiones europeas en nuevas tecnologías".

- También se pretende financiar la creación de unos "espacios de datos comunes e interoperables en toda la UE" en sectores estratégicos, para lo cual se facilitará un "Memorando de entendimiento con los Estados Miembros" para el tercer trimestre de 2020. Estos espacios se detallan más adelante.

- Se lanzará un mercado europeo de servicios en la nube, integrando toda la oferta de servicios en la nube, en el cuarto trimestre de 2022

- Se creará un reglamento de autorregulación de la nube en la Unión Europea, algo programado para el segundo trimestre de 2022.

La tercera estrategia consiste en el "empoderamiento de los individuos e inversión en habilidades y en PYMES". La medida más clara es que se actualizará el Plan de Acción de Educación Digital para reforzar el acceso y el uso de los datos, pero hay algunas acciones interesantes:

- Se añadirán fondos para ampliar la reserva de talentos digitales a unas 250.000 personas que podrán desplegar las últimas tecnologías en las empresas de toda la UE. Para 2025, se quiere haber salvado la brecha de un millón de especialistas digitales, poniendo especial foco en las mujeres.

- El programa de competencias reforzadas establecerá una vía que muestre cómo la acción de la UE y de los Estados miembros puede aumentar la proporción de la población de la UE con competencias digitales básicas, del 57% actual al 65% para 2025.

- Finalmente, se explorará la mejora del derecho de portabilidad de las personas en virtud del artículo 20 del GDPR para darles "más control sobre quién puede acceder y utilizar los datos generados por las máquina".

En relación a los "espacios de datos europeos comunes en sectores estratégicos y dominios de interés público", la Unión Europea establecerá los siguientes nueve espacios, cada uno para un sector en concreto:

- Espacio Común Europeo de Datos Industriales: "para apoyar la competitividad y el rendimiento de la industria de la UE".

- Espacio de datos del Pacto Verde Europeo: "para utilizar el mayor potencial de datos en apoyo a las medidas prioritarias del Acuerdo Verde sobre el cambio climático, la economía circular, la contaminación cero, la biodiversidad, la deforestación y la garantía de cumplimiento".

- Espacio Común Europeo de Datos de Movilidad: "para posicionar a Europa en la vanguardia de la desarrollo de un sistema de transporte inteligente, incluyendo coches conectados, así como otros medios de transporte".

- Espacio Común Europeo de Datos sobre la Salud: "para los avances en prevenir, detectar y curar enfermedades".

- Espacio Común Europeo de Datos Financieros: "para estimular, mediante la mejora de los datos compartir, la innovación, la transparencia del mercado, la financiación sostenible, así como el acceso a financiación para las empresas europeas y un mercado más integrado".

- Espacio Común Europeo de Datos sobre Energía: "para promover una mayor disponibilidad y intercambio de datos entre sectores, de forma centrada en el cliente, segura y fiable".

- Espacio Común Europeo de Datos sobre Agricultura: "para mejorar la sostenibilidad, rendimiento y la competitividad del sector agrícola mediante la elaboración y análisis de la producción y otros datos".

- Espacio Común Europeo de Datos para la Administración Pública: "para mejorar la transparencia y la rendición de cuentas del gasto público y la calidad del gasto, la lucha contra la corrupción en el ámbito de la UE y nacional".

- Espacio Común Europeo de Datos para la Administración Pública: "para reducir los desajustes de habilidades entre los sistema de educación y capacitación por un lado y las necesidades del mercado laboral por el otro".

Finalmente, la cuarta estrategia se refiere a "un enfoque internacional abierto, pero proactivo", para lo que se creará un "marco analítico europeo para la medición de los flujos de datos" que llegará en el cuarto trimestre de 2021 y cuyo objetivo es ofrecer un marco con instrumentos que permitan analizar de forma continua los flujos de datos y el desarrollo económico del sector de procesamiento de datos.

Las claves del Libro Blanco sobre inteligencia artificial

El Libro Blanco sobre inteligencia artificial, como todo libro blanco, busca ofrecer información sobre cómo se aproxima una organización a cierto problema, en este caso, la regulación de la IA. La UE opina que para aprovechar las oportunidades y sobrepasar los retos que supone la implantación de la IA, se debe actuar basándose en "valores europeos" y promoviendo el desarrollo y despliegue de la inteligencia artificial.

Desde la UE se muestran a favor de un "enfoque orientado a la regulación y la inversión" con el doble objetivo de promover la adopción de la IA y de "abordar los riesgos asociados a determinados usos de esta nueva tecnología". Eso sí, siempre desde el punto de vista de un mercado único que evite la "fragmentación" y permita conseguir la suficiente escala.

El libro blanco se resumen en dos grandes bloques: desarrollar un "ecosistema de excelencia" y desarrollar un "ecosistema de confianza". Como hicimos antes, remarcaremos los principales puntos clave. Aquí van los relacionados con el "ecosistema de excelencia":

- La UE cree que es necesario aumentar significativamente la inversión en investigación en IA, puesto que solo en 2016 se invirtieron 3,2 billones de euros en Europa, mientras que en Estados Unidos y Asia la inversión fue de 12,1 y 6,5 billones, respectivamente.

- "La Comisión, teniendo en cuenta los resultados de la consulta pública sobre el Libro Blanco, propondrá a los Estados miembros una revisión del Plan coordinado que se adoptará a finales de 2020".

- Crear centros de excelencia y de pruebas que puedan combinar inversiones europeas, nacionales y privadas, posiblemente incluyendo un nuevo instrumento jurídico. La Comisión ha propuesto una cantidad ambiciosa y específica para apoyar a los centros de pruebas de referencia mundial en Europa en el marco del Programa Europa Digital y se complementará, cuando proceda, por las actividades de investigación e innovación de Horizonte Europa como parte del Marco Financiero Plurianual para 2021-2027.

- Establecer y apoyar, a través del pilar de conocimientos avanzados del Programa Europa Digital, redes de las principales universidades e institutos de enseñanza superior para atraer a los mejores profesores y científicos y ofrecer programas de maestría en IA de primer nivel mundial.

- Trabajar con los Estados miembros para garantizar que al menos un centro de innovación digital por Estado miembro tenga un alto grado de especialización en la IA.

- Poner en marcha un plan piloto de 100 millones de euros en el primer trimestre de 2020 para proporcionar financiación a los desarrollos innovadores en materia de IA. La intención es ampliarlo a partir de 2021 a través de InvestEU.

- Establecer una nueva asociación público-privada en materia de IA, datos y robótica para combinar esfuerzos, garantizar la coordinación de la investigación y la innovación en materia de IA, así como colaborar con otras asociaciones público-privadas en Horizonte Europa.

- Iniciar diálogos abiertos y transparentes sobre el sector, dando prioridad a la atención de la salud, las administraciones rurales y los operadores de servicios públicos, a fin de presentar un plan de acción para facilitar el desarrollo, la experimentación y la adopción. Aquí la UE hace hincapié en que se pondrá especial foco en las áreas relacionadas con la salud y el transporte.

En cuanto al "ecosistema de confianza", la UE es menos clara y quizá algo más abstracta. En pocas palabras, la UE afirma que los actores económicos (las empresas, por ejemplo) son completamente responsables de cumplir con las actuales normativas relacionadas con la inteligencia artificial, como la Race Equiality Directive, la Data Protection Law Enforcemnt Directive y la Euroopean Accesibility Act, que se aplicará a partir de 2025 a los bienes y servicios.

Sin embargo, añade algunos aspectos en los que el marco legislativo podría mejorar para cubrir los posibles riesgos asociados a la inteligencia artificial. Ponen los siguientes ejemplos:

- La aplicación y el cumplimiento efectivos de la legislación nacional y de la UE en vigor: debido a la "opacidad de la IA" se hace "díficil identificar y probar posibles violaciones de leyes", por lo que puede ser "necesario ajustar o aclarar la legislación vigente en determinadas esferas".

- Limitaciones del ámbito de aplicación de la legislación vigente de la UE: si bien la legislación de seguridad de los productos de la UE se aplica al software cuando forma parte de un producto final, "queda abierta" la pregunta de si el software independiente, como una IA, está cubierto por esta regulación.

- Funcionalidad cambiante de los sistemas de IA: dado que la IA se actualiza, se pueden añadir funciones que den lugar a nuevos riesgos que no se contemplaban en la legislación aplicada en el momento de su comercialización.

- Incertidumbre en cuanto a la asignación de responsabilidades entre los distintos agentes económicos en la cadena de suministro: la responsabilidad de la seguridad de un producto recae en el productor que lo pone en el mercado, pero no queda claro si estas reglas se pueden aplicar si la IA se añade al producto una vez está en el mercado por alguien que no es el productor.

- Cambios en el concepto de seguridad: el uso de la IA en productos y servicios puede dar lugar a riesgos que la legislación de la UE no aborda explícitamente en la actualidad. Además, estos riesgos pueden estar presentes en el momento de su comercialización o llegar después tras una actualización.

En lo referente a cuándo una inteligencia artificial debe considerarse de alto riesgo, la Comisión opina que debe considerarse "de alto riesgo a la luz de lo que esté en juego", es decir, en función de si su implementación en cierto sector implica riesgos significativos. Para resumir, la Comisión establece dos parámetros que, de cumplirse, calificarían a la IA de "alto riesgo":

- La aplicación de la IA se emplea en un sector en el que, dadas las características de las actividades que se realizan habitualmente, cabe esperar que se produzcan riesgos importantes.

- La aplicación de la IA en el sector en cuestión se utiliza, además, de tal manera que es probable que surjan riesgos importantes.

Por otro lado, la Comisión también se refiere a los requisitos legales que se le impondrán a los "actores relevantes" que desarrollen IAs de alto riesgo. Los requisitos planteados son algo genéricos y no están definidos. Para eso, proponen que se definan posteriormente mediante estándares. Los campos que se contemplan, acompañados por sus posibles criterios, son los siguientes:

- Datos de entrenamiento: que sean suficientemente amplios para evitar situaciones peligrosas, que no generen discriminación y que protejan la privacidad de los datos personales.

- Conservación de datos y registros: mantener un registro de los datos que se han usado y por qué se han seleccionado y documentar la programación, entrenamiento, procesos y técnicas usadas para construir la IA.

- Información que debe proporcionarse: como las capacidades y limitaciones de la IA, o informar "claramente" a los usuarios de que están interactuando con una IA y no con un humano.

- Robustez y precisión: que los resultados sean replicables y que la IA pueda lidiar con errores e inconsistencias durante su vida útil.

- Supervisión humana: por ejemplo, que los resultados de la IA no sean efectivos hasta que un humano los valide o que sean efectivos de inmediato, pero luego se supervisen.

- Requisitos específicos para ciertas aplicaciones particulares de la IA, como las utilizadas con fines de identificación biométrica a distancia: tal y como está la normativa europea, el reconocimiento facial a distancia está limitado por el GDPR. Para lidiar con este asunto, la Comisión lanzará un debate relacionado con el uso de la IA en espacios públicos.

Finalmente, en cuanto a la gobernanza de las estructuras de inteligencia artificial, la Comisión opina que "una estructura de gobernanza europea sobre la IA en forma de un marco de cooperación de los es necesaria para que las autoridades competentes eviten la fragmentación de responsabilidades, aumenten la capacidad de los Estados Miembros y se aseguren de que Europa se dote progresivamente de la capacidad necesaria para el ensayo y la certificación de los productos y servicios habilitados para la IA".

En la creación de esta estructura, afirman que se "debería garantizar la máxima participación de los interesados. Las partes interesadas -organizaciones de consumidores e interlocutores sociales, empresas, investigadores y organizaciones de la sociedad civil- deben ser consultadas sobre la aplicación y el desarrollo ulterior del marco".

Este libro blanco es un inicio, pero no es definitivo ni mucho menos. Hasta el 19 de mayo de 2020, hay abierto un sistema de comentarios y consultas para añadir mejoras, comentarios, etc. Este sistema es accesible desde el siguiente enlace.

via Magazine - robotica-e-ia https://ift.tt/2vKcXrk

Call center y centralitas virtuales como tecnología para reflotar el negocio empresarial

La agilidad y la optimización de las actividades de una empresa son un requisito indispensable para el nuevo mundo. La inmediatez a la que acostumbra la virtualidad se extiende a todo dominio físico y hace del cliente un sujeto firme en su exigencia. El sistema Neotel, mediante la innovación y la consciencia, ofrece un software para call center y centralitas virtuales con las que reflotar en el océano empresarial. Ganando en velocidad El mundo de la empresa requiere siempre de medidas innovadoras que agilicen su actividad al máximo. El tiempo moderno exige inmediatez en la gestión de cualquier servicio o recurso. Y no sólo para satisfacer las demandas del cliente, sino para hacer de la fluidez de un negocio uno de sus puntos fuertes. Lejos han quedado ya las acciones más rudimentarias de una empresa, como recurrir a archivos físicos o saltar de llamada en llamada para saciar consultas. El hoy precisa de rapidez. Dentro del estadio de las llamadas telefónicas, que acarrean mucha dedicación y perseverancia, existen para su simplificación los software call center. Ello consiste en un programa informático que, junto a una centralita telefónica, reúne distintos servicios de integración de voz y datos. Su propósito principal tiene que ver con una reducción de gastos, ahorro de tiempo y, por ende, una mejora de la atención al cliente. Consiguiendo al mismo tiempo un aumento de la productividad. Cuanto a su funcionamiento, los software call center funcionan a través de una llamada telefónica que, pasando por un conmutador, conecta al cliente con un agente disponible. En otras palabras, la intención es la de evitar el tiempo de espera conduciendo al cliente a un agente que esté comprobadamente libre. A causa de dicha operación algorítmica, la empresa gana en velocidad y el cliente en atención. Tan sencillo como contar con un software que haga parte del trabajo. ¿Qué es un software call center? Los software call center cuentan con un diseño fácil y ergonómico con el que saber qué hacer en todo momento mediante la intuición. Del mismo modo, el acceso para agentes y coordinadores se realiza mediante nombre de usuario y contraseña en una plataforma web. Esta misma naturaleza virtual hace que su instalación carezca de costes, tan sólo pagando por puesto con tarifa plana de llamadas incluida y sin contrato de permanencia alguno. Asimismo, su existencia en la red lo hace geográficamente universal, contando con varios canales de comunicación. A fin de reducir el tiempo dedicado a tareas transitorias, dispone de tres tipos de marcadores o llamadas automatizadas. Uno de índole progresiva, con el que familiarizarse con el sistema poco a poco y realizando la llamada cuando el agente está a la espera. Cuanto al modo predictivo, su priorización del tiempo se regula administrando posibles clientes al otro lado de la línea cuando el agente atiende una llamada. En tercer lugar, robot call no precisa de agente alguno, ya que una grabación ofrecerá información adicional al cliente durante la breve espera. Además, los packs de software call center como Neotel incluyen un módulo estadístico para medir la productividad y ajustarla al calendario con sincronización en Google Calendar. Así como otros servicios de videollamada, grabación de llamadas y monitorización o ficha del «Lead» en web del agente. Todo pensado para mejorar la gestión de una empresa en sus llamadas con todo lo que ofrece la innovación de una perfecta centralita virtual. El valor de la ubicuidad: las centralitas virtuales Muchas empresas cuentan con un departamento específico dedicado a la atención al cliente, con el que un grupo de agentes responden con concreción todo tipo de consulta. Cuando la implementación de dicho departamento no es posible, por razones de espacio o coste de inversión, es francamente contemplable recurrir a una centralita virtual. Un sistema telefónico por IP, es decir, a través de la nube de Internet, con el que solventar el problema de no poder contar con un espacio físico donde gestionar llamadas. Este método permite, además, optimizar la comunicación interna de la empresa sin olvidar la eficacia relacional entre clientes. Dado que no es necesario mantener las líneas, su coste se reduce y supone un desahogo económico, así como una apuesta por un rendimiento mayor. Basta con tener conexión a internet, pudiendo así contactar con todas las sedes de la empresa que estén repartidas en distintos puntos geográficos. Permitiendo elegir entre numeraciones telefónicas acordes a cada país o región. Las terminales de la empresa cuentan con un breve número de identificación interno conocido como extensión, cuyo coste entre ellas es gratuito. Cuanto a las llamadas externas, el precio es más bajo que en una llamada común, dado su propósito comercial y la contratación de dichos servicios. Un modo de acelerar y llevar la atención al cliente al estadio más óptimo de realización. Sin sobrecostes y pensando en efectivizar las operaciones telefónicas de una empresa mediante los beneficios que a ello aporta la virtualidad empresarial. Neotel: control para su negocio Encauzando todos los aspectos antes mencionados, Neotel es un sistema cuyo servicio ofrece centralita virtual, software call center y CRM (Customer Relationship Management o plataforma de gestión de las relaciones con los clientes). Desde 2001, el propósito de Neotel es el de optimizar la comunicación entre cliente y empresa a través de los comentados productos de propio desarrollo. Una empresa del ámbito de las telecomunicaciones con presencia en diferentes países que presta sus servicios a los cinco continentes desde su sede española. Su actividad se centra en la implementación de centralitas virtuales basadas en el protocolo de internet, contando con todo el hardware necesario en sus propias instalaciones. Un software para call center óptimo y sencillo cuyas prestaciones persiguen incrementar el tiempo de conversación entre agentes y clientes. Así como un CRM con centralita integrada para acceder automáticamente a todos los datos del cliente y del negocio. Disponiendo, además, de una atención personalizada para resolver cualquier duda, o recurrir a cualquier soporte técnico, referente a sus packs y productos. Bajo la premisa de controlar el negocio, Neotel se especializa en los productos y servicios mencionados desde la profesionalidad y la experiencia. En un mundo cambiante, ubicuo y cada vez más virtual, picar en la mina de internet para extraer su beneficioso jugo sólo puede conllevar ventajas. Simplificar y agilizar una empresa no supone jamás un declive operacional, al contrario. Ello se traduce en un cliente contento y en una empresa competente y capaz de enfrentarse a todo.

La agilidad y la optimización de las actividades de una empresa son un requisito indispensable para el nuevo mundo. La inmediatez a la que acostumbra la virtualidad se extiende a todo dominio físico y hace del cliente un sujeto firme en su exigencia. El sistema Neotel, mediante la innovación y la consciencia, ofrece un software para call center y centralitas virtuales con las que reflotar en el océano empresarial. Ganando en velocidad El mundo de la empresa requiere siempre de medidas innovadoras que agilicen su actividad al máximo. El tiempo moderno exige inmediatez en la gestión de cualquier servicio o recurso. Y no sólo para satisfacer las demandas del cliente, sino para hacer de la fluidez de un negocio uno de sus puntos fuertes. Lejos han quedado ya las acciones más rudimentarias de una empresa, como recurrir a archivos físicos o saltar de llamada en llamada para saciar consultas. El hoy precisa de rapidez. Dentro del estadio de las llamadas telefónicas, que acarrean mucha dedicación y perseverancia, existen para su simplificación los software call center. Ello consiste en un programa informático que, junto a una centralita telefónica, reúne distintos servicios de integración de voz y datos. Su propósito principal tiene que ver con una reducción de gastos, ahorro de tiempo y, por ende, una mejora de la atención al cliente. Consiguiendo al mismo tiempo un aumento de la productividad. Cuanto a su funcionamiento, los software call center funcionan a través de una llamada telefónica que, pasando por un conmutador, conecta al cliente con un agente disponible. En otras palabras, la intención es la de evitar el tiempo de espera conduciendo al cliente a un agente que esté comprobadamente libre. A causa de dicha operación algorítmica, la empresa gana en velocidad y el cliente en atención. Tan sencillo como contar con un software que haga parte del trabajo. ¿Qué es un software call center? Los software call center cuentan con un diseño fácil y ergonómico con el que saber qué hacer en todo momento mediante la intuición. Del mismo modo, el acceso para agentes y coordinadores se realiza mediante nombre de usuario y contraseña en una plataforma web. Esta misma naturaleza virtual hace que su instalación carezca de costes, tan sólo pagando por puesto con tarifa plana de llamadas incluida y sin contrato de permanencia alguno. Asimismo, su existencia en la red lo hace geográficamente universal, contando con varios canales de comunicación. A fin de reducir el tiempo dedicado a tareas transitorias, dispone de tres tipos de marcadores o llamadas automatizadas. Uno de índole progresiva, con el que familiarizarse con el sistema poco a poco y realizando la llamada cuando el agente está a la espera. Cuanto al modo predictivo, su priorización del tiempo se regula administrando posibles clientes al otro lado de la línea cuando el agente atiende una llamada. En tercer lugar, robot call no precisa de agente alguno, ya que una grabación ofrecerá información adicional al cliente durante la breve espera. Además, los packs de software call center como Neotel incluyen un módulo estadístico para medir la productividad y ajustarla al calendario con sincronización en Google Calendar. Así como otros servicios de videollamada, grabación de llamadas y monitorización o ficha del «Lead» en web del agente. Todo pensado para mejorar la gestión de una empresa en sus llamadas con todo lo que ofrece la innovación de una perfecta centralita virtual. El valor de la ubicuidad: las centralitas virtuales Muchas empresas cuentan con un departamento específico dedicado a la atención al cliente, con el que un grupo de agentes responden con concreción todo tipo de consulta. Cuando la implementación de dicho departamento no es posible, por razones de espacio o coste de inversión, es francamente contemplable recurrir a una centralita virtual. Un sistema telefónico por IP, es decir, a través de la nube de Internet, con el que solventar el problema de no poder contar con un espacio físico donde gestionar llamadas. Este método permite, además, optimizar la comunicación interna de la empresa sin olvidar la eficacia relacional entre clientes. Dado que no es necesario mantener las líneas, su coste se reduce y supone un desahogo económico, así como una apuesta por un rendimiento mayor. Basta con tener conexión a internet, pudiendo así contactar con todas las sedes de la empresa que estén repartidas en distintos puntos geográficos. Permitiendo elegir entre numeraciones telefónicas acordes a cada país o región. Las terminales de la empresa cuentan con un breve número de identificación interno conocido como extensión, cuyo coste entre ellas es gratuito. Cuanto a las llamadas externas, el precio es más bajo que en una llamada común, dado su propósito comercial y la contratación de dichos servicios. Un modo de acelerar y llevar la atención al cliente al estadio más óptimo de realización. Sin sobrecostes y pensando en efectivizar las operaciones telefónicas de una empresa mediante los beneficios que a ello aporta la virtualidad empresarial. Neotel: control para su negocio Encauzando todos los aspectos antes mencionados, Neotel es un sistema cuyo servicio ofrece centralita virtual, software call center y CRM (Customer Relationship Management o plataforma de gestión de las relaciones con los clientes). Desde 2001, el propósito de Neotel es el de optimizar la comunicación entre cliente y empresa a través de los comentados productos de propio desarrollo. Una empresa del ámbito de las telecomunicaciones con presencia en diferentes países que presta sus servicios a los cinco continentes desde su sede española. Su actividad se centra en la implementación de centralitas virtuales basadas en el protocolo de internet, contando con todo el hardware necesario en sus propias instalaciones. Un software para call center óptimo y sencillo cuyas prestaciones persiguen incrementar el tiempo de conversación entre agentes y clientes. Así como un CRM con centralita integrada para acceder automáticamente a todos los datos del cliente y del negocio. Disponiendo, además, de una atención personalizada para resolver cualquier duda, o recurrir a cualquier soporte técnico, referente a sus packs y productos. Bajo la premisa de controlar el negocio, Neotel se especializa en los productos y servicios mencionados desde la profesionalidad y la experiencia. En un mundo cambiante, ubicuo y cada vez más virtual, picar en la mina de internet para extraer su beneficioso jugo sólo puede conllevar ventajas. Simplificar y agilizar una empresa no supone jamás un declive operacional, al contrario. Ello se traduce en un cliente contento y en una empresa competente y capaz de enfrentarse a todo.via Tecnología https://ift.tt/2P0qjqf

Este político hizo varios vídeos deepfake para hablar a sus votantes en idiomas que no conoce

Fue durante el año pasado cuando vimos un boom en los vídeos deepfake. Este tipo de vídeos que, mediante inteligencia artificial, modifican el rostro de una persona en el vídeo tienen utilidades muy variadas. El mayor uso que se les ha dado es en el porno, donde se suele modificar la cara del actor o la actriz para colocar el rostro de algún famoso. Pero, ¿y si se usa para que alguien hable en diferentes idiomas? Es lo que ha hecho un candidato a las elecciones de Delhi de India.

Según explican en Vice, el candidato político Manoj Tiwari a la Asamblea Legislativa en Delhi dio el pistoletazo de salida para comenzar a usar los deepfakes en campañas políticas el pasado 7 de febrero. Lo hizo con un simple vídeo de 44 segundos, o más bien tres vídeos de 44 segundos. Este es el original:

A raíz de este vídeo publicó dos más en inglés y el dialecto hindi Harayanvi, pero en estos dos últimos él no era el que hablaba, sino una IA que además modificaba su rostro para sincronizar los labios según las palabras que se pronunciaban.

Explican los representantes del partido político BJP (al que pertenece el candidato) que se aliaron con una agencia de comunicación llamada The Ideaz Factory para crear "campañas positivas" utilizando los deepfakes. El resultado parece ser que ha sido un éxito, los videos se propagaron y viralizaron rápidamente por WhatsApp. Siendo o no conscientes sus receptores, los deepfakes permitieron comunicar el mensaje en el idioma nativo/preferido de los votantes. Según los responsables del partido, los vídeos se distribuyeron por más de 5.800 grupos de WhatsApp llegando a aproximadamente 15 millones de personas.

Todo apunta a que se ha usado precisamente un software desarrollado en India que permite traducir vídeos a otros idiomas y a la vez sincronizar labios. Se trata de un software que vimos en profundidad hace unas semanas. Lo cierto es que si nos fijamos con detalle o si somos conscientes de que es un deepfake se aprecian pequeños errores en los vídeos, tanto los del estudio como los de la campaña política. Pero, ¿es algo que nota una persona que recibe el vídeo sin conocer el contexto? Complicado.

Una poderosa (y peligrosa) herramienta

Generalmente los deepfakes han tenido una mala reputación y rechazo (además de asombro) por parte de los usuarios por el uso que se les ha dado. Es decir, se han utilizado para engañar a base de vídeos falsos, que es esencialmente lo que son. Uno de los primeros en viralizarse fue el de Obama dando un discurso falso. Pero en este caso, ¿se está engañando? La campaña política ha traducido el mensaje en idiomas diferentes, el engaño en sí no está en el mensaje sino en dar a entender que el político habla idiomas que realmente no conoce.

Debido a las preocupaciones que generan estos tipos de vídeos, están siendo cada vez más regulados. California tomó medidas al respecto, Facebook los ha bloqueado y en China están prohibidos.

Vía | Vice

via Magazine - robotica-e-ia https://ift.tt/2V2ekMB

martes, 18 de febrero de 2020

Así es Verba, el servicio de Civio que disecciona cada Telediario de TVE para saber cuánto, cuándo y de qué se habla en él

"Las palabras vuelan, lo escrito permanece". Ese es el lema de Verba, un proyecto de Civio dirigido por David Cabo para analizar la cobertura de los Telediarios de Televisión Española desde 2014.

El proyecto —que además es Open Source— ve la luz estos días tras meses de trabajo, y lo hace demostrando que no todas estas ideas geniales tienen por qué salir de alguna startup de Silicon Valley. Hemos podido hablar con Cabo para que nos cuente cómo se concibió Verba, qué nos permite hacer y qué futuro le espera a esta interesante iniciativa.

Los orígenes de Verba

Civio es una organización independiente y sin ánimo de lucro que lleva años combinando periodismo y tecnología porque como decía David Cabo (@dcabo), su fundador, "la tecnología está a merced del periodismo". En este caso, para —como ellos mismos explican— "vigilar a los poderes públicos, informar a todos los ciudadanos y presionar para lograr una transparencia real y eficaz en las instituciones".

La búsqueda de la transparencia y el acceso de información que persigue Civio se han ido demostrando a través de esfuerzos como 'el BOE nuestro de cada día' con el que Eva Belmonte (@evabelmonte) acerca a los ciudadanos las conclusiones de cada uno de los Boletines Oficiales del Estado que se publican, o 'Medicamentalia', una investigación periodística de Ángela Bernardo (@maberalv) sobre la brecha global en el acceso a la salud, entre otros proyectos.

Este proyecto llamado Verba, no obstante, es muy diferente. David Cabo nos contaba como hace unos años vio en Estados Unidos una emisión con las sesiones del Congreso en la que surgió la idea: en el sitio web de "A la carta" de RTVE comprobó que cada Telediario contaba con subtítulos que no solo estaban disponibles al reproducir el vídeo: también se podían descargar.

Eso se unió a un debate recurrente que entonces comenzaba a surgir sobre las temáticas que se cubrían en los informativos de la televisión pública estatal. ¿De qué se hablaba en cada Telediario, y cuánto tiempo?

Los subtítulos permitían responder a esa pregunta, y tras conseguir una beca Google News Initiative —que incentiva el uso de la tecnología en la industria de los medios de comunicación— pusieron en marcha el proyecto aprovechando un ámbito científico muy especial: el Procesamiento del Lenguaje Natural (PLN).

Perdona, ¿qué estás diciendo?

El Procesamiento del Lenguaje Natural ha avanzado de forma excepcional gracias a la introducción de algoritmos de aprendizaje automático (machine learning) para el procesamiento del lenguaje, y permite que las máquinas puedan procesar grandes cantidades de datos procedentes del lenguaje natural que usamos en nuestro día a día.

Un ejemplo de lo que permite Verba: ¿de qué trama de corrupción se ha hablado más en RTVE en los últimos años? No ha sido la Púnica con 357 apariciones, sino tanto la Gürtel (712 apariciones) como los ERE (804). Fuente: Verba.

Un ejemplo de lo que permite Verba: ¿de qué trama de corrupción se ha hablado más en RTVE en los últimos años? No ha sido la Púnica con 357 apariciones, sino tanto la Gürtel (712 apariciones) como los ERE (804). Fuente: Verba.La técnica es perfecta para analizar y extrapolar información de esos subtítulos que ofrecían los Telediarios de RTVE. Como explicaba Cabo, Verba "tiene cierta complejidad técnica, pero no demasiada". Su funcionamiento se basa en primer lugar en la descarga de los subtítulos, que se van agregando a una gran base de datos construida con Elasticsearch, un potente motor de búsqueda distribuido.

Eso sí, destacaba Cabo, antes hay un paso intermedio: esos subtítulos se parten o dividen por frases gracias a una librería PLN que permite "diseccionar" cada Telediario en partes que luego facilitan encontrar resultados de búsqueda de forma eficaz.

A partir de ahí empieza el trabajo de la aplicación, realizada en JavaScript con Vue.js, y que a su vez hace llamadas a una librería de visualización llamada D3.js que es la que ofrece los resultados que ve el usuario al procesarse su búsqueda. Este proyecto de Civio, explicaba Cabo en el anuncio oficial, ha avanzado entre otras cosas gracias a la colaboración de expertos como Víctor Peinado o Pablo Rey.

Ya puedes saber cuándo se habló de cierto tema en el Telediario

Verba convierte los informativos de RTVE en una singular hemeroteca: una por la que es posible navegar con simples términos de búsqueda que además podremos combinar usando los operadores de Elasticsearch. Así, podremos excluir términos (con el símbolo "-") o hacer por ejemplo búsquedas "OR" usando el símbolo "|" (por ejemplo buscando "Trump | Obama").

La búsqueda no solo se puede compartir en redes —cada una genera una URL, como ocurre con nuestro ejemplo— sino que al hacerla aparece un gráfico que muestra el número de apariciones de esos términos de búsqueda a lo largo de los años en los informativos de TVE. Podremos además descargar los resultados de la búsqueda en formato .csv.

Ese gráfico es una representación visual de esas apariciones, pero tendremos cada una de ellas disponibles con un pequeño extracto de la transcripción en el que se encontraron esos términos de búsqueda con el día y la edición del Telediario al que pertenecen. En esas "cajas" para cada resultado podremos además pasar el ratón por encima (el tradicional hover) para acceder al contexto, lo que hará que aparezca una ventana pop-up con la transcripción algo más ampliada, pero también con un enlace directo al vídeo de esa retransmisión, que se abrirá en una nueva pestaña del navegador.

Ejemplo de un primer resultado para la búsqueda realizada como ejemplo. Se indica el momento en el que se mencionan los términos de búsqueda en el programa, se resalta el término encontrado y se da acceso al contexto o bien un enlace al vídeo en el servicio "A la carta" de RTVE.

Ejemplo de un primer resultado para la búsqueda realizada como ejemplo. Se indica el momento en el que se mencionan los términos de búsqueda en el programa, se resalta el término encontrado y se da acceso al contexto o bien un enlace al vídeo en el servicio "A la carta" de RTVE.En ese vídeo podremos localizar fácilmente el momento exacto en el que se nombraba el término o términos de búsqueda, porque esa información también aparece como parte de los datos publicados en cada resultado.

Además del buscador, en Civio ponen a nuestra disposición algunos ejemplos de los análisis que se pueden realizar a partir de esos resultados. En el apartado "Titulares" muestran cinco ejemplos de coberturas que se han realizado en el Telediario en los últimos años para analizar entre otras cosas el rigor científico al hablar de las dietas o la diferencia de cobertura que han tenido distintas tramas de corrupción como la Gürtel o los ERE.

Esto es solo el principio

El servicio es funcional y su respuesta es sorprendentemente rápida y precisa, pero para David Cabo "solo hemos lanzado una primera parte". Él y su equipo en Civio quieren "aplicar más tecnologías PLN" que entre otras cosas "permitan la extracción de entidades". Gracias a esa capacidad Verba podrá reconocer nombres propios y diferenciarlos según el contexto.

En Civio ofrecen todas las transcripciones de los distintos informativos de RTVE de las 15 y las 21 horas que se han emitido desde 2014 organizados por año, mes y día de emisión.

En Civio ofrecen todas las transcripciones de los distintos informativos de RTVE de las 15 y las 21 horas que se han emitido desde 2014 organizados por año, mes y día de emisión.Hay un ejemplo muy claro de las actuales limitaciones de Verba: de momento una búsqueda de "Podemos" confundirá el partido político con el uso de la forma verbal, pero esa extracción de entidades ayudará a diferenciar entre uno y otro.

Como nos explicaba Cabo, esa opción "está cerca" de implementarse, pero no era lo precisa que hubieran querido y han preferido retrasar su lanzamiento. Para ofrecerla volverán a aprovechar técnicas de aprendizaje automático que con un montón de entrenamiento —y un pequeño truco, la detección de mayúsculas— permiten ayudar a diferenciar con ayuda del contexto entre unos casos y otros.

Para poder medir tiempos, estamos trabajando en partir las transcripciones en noticias individuales, y entrenando un modelo que clasifique las noticias en temas. Algo así: pic.twitter.com/rgnO61PwT7

— David Cabo (@dcabo) 18 de febrero de 2020

No solo eso: David Cabo también apuntaba a otra opción de futuro especialmente interesante: la división de la transcripción en trozos clasificados por temas, de forma que en cada Telediario se sepa cuánto se ha hablado de deportes o de política, por ejemplo. De hecho la idea es poder realizar una clasificación muy precisa que permita saber cuánto se ha hablado de cada tema en cada informativo.

Eso permitirá responder a preguntas que ahora tienen respuesta algo más difusa como si se está hablando poco, nada o mucho de diversas temáticas en los informativos de una cadena pública como RTVE, y hace que Verba se postule por tanto como una herramienta muy útil para analizar la verdadera transparencia de estos informativos.

Y aquí podemos encontrar, una vez más gracias a Civio, (hola, @evabelmonte) la promesa de Pedro Sánchez de derogar las leyes mordaza. Nada como la buena tecnología para aliviar la amnesia de los políticos. https://t.co/Qie1Y3GK3L

— Almeida (@bufetalmeida) 18 de febrero de 2020

Eso, por supuesto, además de ser una "maldita (bendita) hemeroteca" que permita detectar qué se dijo, quién lo dijo y cuándo lo dijo, algo que algunos usuarios y expertos ya han descubierto.

Verba funciona con una base de datos construida a partir de 2014 por una sencilla razón: es el momento en el que RTVE comenzó a subtitular sus Telediarios y a poner en la web esos subtítulos.

¿Es factible que esa búsqueda acabe yendo aún más atrás en el pasado? Por supuesto, pero para eso necesitan la transcripción de esos informativos. Aunque han hecho pequeños experimentos para transcribirlos con sistemas automáticos —como Transcribe de Amazon—, Cabo nos indicaba que la conclusión es que ese proceso es costoso en tiempo y dinero.

Transcribir un solo Telediario no es muy caro, pero cuando hablamos de hacerlo con todos los informativos durante varios años la cosa cambia. En Civio hablarán de hecho con RTVE para intentar recabar más subtítulos de informativos anteriores, así que es factible que por una u otra vía acabe ampliándose ese rango de tiempo que está cubierto por Verba.

Con Verba es por ejemplo fácil encontrar las apariciones de Pichai o Zuckerberg en un Telediario. Ambos lo hicieron en el Mobile World Congress de 2015 en Barcelona. Fuente: RTVE

Con Verba es por ejemplo fácil encontrar las apariciones de Pichai o Zuckerberg en un Telediario. Ambos lo hicieron en el Mobile World Congress de 2015 en Barcelona. Fuente: RTVEDe hecho el proceso es totalmente extrapolable a los informativos de otras cadenas. En Civio trataron de obtener los subtítulos de los informativos como los de las privadas, pero no se publican o no lo hacen en un formato que sea fácilmente tratable para ellos de momento.

La idea de Cabo es ofrecer esta herramienta no solo a cualquier usuario —que puede replicar el proyecto sin problemas gracias al repositorio de GitHub donde está el código— sino a consejos audiovisuales, universidades y facultades de periodismo, u organismos reguladores para que lo utilicen y puedan así sacar sus propias conclusiones.

Precisamente GitHub —en el apartado de Issues del proyecto— desvela muchas de las claves de la evolución de un proyecto en el que David Cabo por ejemplo comparaba distintas plataformas PLN y también hablaba de los problemas a la hora de reconocer nombres propios o el coste económico que tendría ese procesamiento antes de llevarlo a cabo.

Lo que está claro es que Cabo y todo el equipo de Civio quieren ver crecer esta iniciativa. De hecho el fundador de Civio ha realizado un llamamiento a la Comunidad Civio que nosotros extendemos.

Como él mismo decía tanto en la presentación oficial del servicio en el blog de Civio como en Twitter, "si tienes curiosidad por estas cosas, pásate por la comunidad de Civio y hablamos". No solo eso: si quieres ayudarles a encontrar historias interesantes en los Telediarios a través de Verba, ya puedes hacerlo también gracias a su Comunidad.

via Magazine - robotica-e-ia https://ift.tt/39OFhYp

Margrethe Vestager cree que el reconocimiento facial, "tal y como está ahora mismo", incumple el GDPR

El reconocimiento facial es un tema controvertido. Algunos países, entre ellos Estados Unidos y China, usan esta tecnología para alimentar sus sistemas de vigilancia y su regulación lleva tiempo siendo objeto de debate. Hace un mes, se filtró que la Unión Europea planeaba vetar el uso del reconocimiento facial en zonas públicas durante cinco años para, más tarde, filtrarse otro borrador que decía que, finalmente, no sería así, sino que se plantearían ciertas excepciones "en sectores de alto riesgo".

Se espera que el 19 de febrero, es decir, mañana, se presente el documento definitivo, por lo que será cuando conozcamos la postura oficial de la Unión Europea, pero mientras tanto, Margrethe Vestager, Comisaria de Competencia de la Unión Europea, se ha pronunciado al respecto. La Comisaria lo tiene claro y es contundente: "tal y como está ahora mismo, el GDPR diría 'no lo uses', porque no puedes conseguir el consentimiento".

La clave está en el artículo 6

Margrethe Vestager, Comisaria de Competencia de la Unión Europea.

Margrethe Vestager, Comisaria de Competencia de la Unión Europea.Para entender la postura de Vestager debemos recordar el Reglamento General de Protección de Datos, más conocido por sus siglas en inglés, GDPR. En el artículo 6 se dicho texto se expone de forma clara lo siguiente.

"El tratamiento solo será lícito si se cumple al menos una de las siguientes condiciones:

- el interesado dio su consentimiento para el tratamiento de sus datos personales para uno o varios fines específicos;

- el tratamiento es necesario para la ejecución de un contrato en el que el interesado es parte o para la aplicación a petición de este de medidas precontractuales;

- el tratamiento es necesario para el cumplimiento de una obligación legal aplicable al responsable del tratamiento

- el tratamiento es necesario para proteger intereses vitales del interesado o de otra persona física;

- el tratamiento es necesario para el cumplimiento de una misión realizada en interés público o en el ejercicio de poderes públicos conferidos al responsable del tratamiento;

- el tratamiento es necesario para la satisfacción de intereses legítimos perseguidos por el responsable del tratamiento o por un tercero, siempre que sobre dichos intereses no prevalezcan los intereses o los derechos y libertades fundamentales del interesado que requieran la protección de datos personales, en particular cuando el interesado sea un niño."

En otras palabras, el Reglamento contempla la obligatoriedad de que el usuario de su consentimiento para procesar sus datos personales. Además, el propio texto ya aporta cierto marco en lo que a reconocimiento facial se refiere, puesto que en el artículo 9, apartado 1, se afirma que:

"Queda prohibido el tratamiento de datos personales que revelen el origen étnico o racial, las opiniones políticas, las convicciones religiosas o filosóficas, o la afiliación sindical, y el tratamiento de datos genéticos, datos biométricos dirigidos a identificar de manera unívoca a una persona física, datos relativos a la salud o datos relativos a la vida sexual o las orientación sexuales de una persona física". (Las negritas son propias).

Lo que nos interesa es "datos biométricos", definidos en el reglamento como "datos personales obtenidos a partir de un tratamiento técnico específico, relativos a las características físicas, fisiológicas o conductuales de una persona física que permitan o confirmen la identificación única de dicha persona, como imágenes faciales o datos dactiloscópicos".

En pocas palabras, a efectos del GDPR, el reconocimiento facial a distancia mediante una cámara en una calle, por ejemplo, no sería correcto puesto que el usuario no puede darle el consentimiento a la organización para que procese su información. Ahora bien, por el momento, la Comisión no va a tomar ninguna medida, sino que prefiere optar por un enfoque más circunstancial. En sus propias palabras:

"Lo que diremos en el documento en un lenguaje muy legal es, hagamos una pausa y averigüemos si hay alguna [situación], y si la hay, bajo qué circunstancias el reconocimiento facial a distancia debería ser autorizado".

Cuadra, por lo tanto, con el borrador con el que Reuters si hizo hace algunas semanas, en el que el veto de cinco años desaparecía. Ya en ese borrador se contemplaban ciertas excepciones en "sectores de alto riesgo", como el transporte o la sanidad. En cuanto al uso de la inteligencia artificial, Vestager cree que puede tener "efectos muy adversos en los valores fundamentales y la integridad humana" y que "creemos que habrá un llamamiento a la regulación de las partes arriesgadas de la tecnología".

20.000 millones de euros para investigar la IA

EUObserver, por su parte, se ha hecho con un borrador de la European Data Strategy, que se publicará el 19 de febrero junto al AI White Paper, del que también hay borrador. En dichos textos se contemplan una serie de medidas enfocadas, mayormente, a generar un ecosistema de datos adecuados en Europa que fomente la innovación en Inteligencia Artificial y otras tecnologías como el Internet de las Cosas (IoT).

¿Qué medidas se contemplan? Según los borradores a los que ha tenido acceso EUObsever, la Unión Europea planea dedicar 20.000 millones de euros (públicos y privados) anuales y durante una década para desarrollar la inteligencia artificial, siendo esto un intento por igualar a Estados Unidos y China en lo que a desarrollo se refiere.

Asimismo, se establecerán nuevos requisitos vinculantes para el desarrollo de aplicaciones de "alto riesgo", definidas estas como aquellas que puedan suponer una amenaza para los derechos fundamentales y estén relacionadas con sectores específicos como la salud, la policía o el transporte.

Finalmente, el borrador contempla la visión de la UE en lo referente al dominio de grandes empresas, alegando que "es importante que las reglas de competencia sean adecuadas para un mundo que está cambiando rápidamente y cada vez más digital", que "unas pocas empresas con la mayor cuota de mercado reciben la mayor parte de los ingresos, que a menudo no se gravan en el lugar donde se han generado, lo que distorsiona la competencia y socava la base impositiva de una sociedad" y que "es inaceptable que algunas empresas paguen sus impuestos y otras no".

Sea como fuere, se espera que todos estos documentos se hagan oficiales mañana, así que será entonces cuando conozcamos la postura oficial de la Unión Europea.

Vía | Euractiv

via Magazine - robotica-e-ia https://ift.tt/2SCuScl

lunes, 17 de febrero de 2020

Personas / robots / inteligencia artificial

from RSS de lo último publicado en 'Computing España' https://ift.tt/323Lf4J

via IFTTT

“PigeonBot”, el primer robot que dobla sus alas como un pájaro

La inventiva humana es impresionante y gracias a eso podemos presentarte a “PigeonBot”, el primer robot que dobla sus alas como un pájaro. Simula a una de las aves mejor conocidos por todos “las palomas”. La intención es que a partir de esta invención se puedan fabricar una nueva flota de máquinas voladoras que pueda revolucionar no solo el mundo de la aviación sino desde luego de la tecnología. Se trata de un robot construido a partir de las plumas de estas aves y que cuenta con mecanismos que aunque a simple vista parecen simples, en realidad es bastante complejo.

PigeonBot el robot volador que mejor imita a las aves

Las aves pueden modificar la forma de sus alas desplegando sus plumas o arrastrándolas más cerca. Esos ajustes permiten a las aves atravesar el cielo de manera más ágil que los drones rígidos. Ahora, utilizando nuevas ideas sobre cómo las articulaciones de las palomas controlan la extensión de las plumas de sus alas, los investigadores han construido una paloma robótica, llamada PigeonBot, cuyas alas emplumadas cambian de forma como las aves verdaderas.

Las aves como las palomas cambian la forma de sus alas en pleno vuelo al doblar las articulaciones de sus muñecas y dedos para doblar las plumas de sus alas o separarlas más. Esos ajustes ayudan a las aves a hacer giros cerrados y maniobrar a través de la turbulencia. Ante este conocimiento, lo responsables de la investigación se encaminan a crear aviones más ágiles y versátiles.

Según los comentarios de Dario Floreano, un robotista de la Escuela Politécnica Federal de Lausana en Suiza que no participa en el trabajo, un robot con alas de pájaro, permitiría que las máquinas aerotransportadas pudieran hacer giros más cerrados en espacios desordenados, como alrededor de edificios o bosques, y podrían navegar mejor por el aire áspero, dice. El nuevo robot, que fue descrito la revista Science Robotics, también ofrece una forma de estudiar los aspectos básicos del vuelo de los pájaros sin tener que hacer experimentos con animales.

Los investigadores doblaron y extendieron las alas de las palomas muertas para investigar cómo las aves controlan la forma de sus alas. Esos experimentos revelaron que los ángulos de las dos articulaciones del ala, la muñeca y el dedo, afectan la alineación de las plumas de vuelo de un ala. Las orientaciones de esas plumas largas y rígidas, que sostienen al pájaro en vuelo, ayudan a determinar la forma del ala. En base a esos hallazgos, el equipo construyó un robot con plumas de paloma reales, cuyas muñecas y dedos falsos pueden cambiar su forma de ala como se ve en los cadáveres de palomas.

Este robot sin duda asienta las bases para construir drones más elegantes, y lo que es realmente genial de este robot es que podrá inclusive hacer manipulaciones en un ala de robot que nunca podrías hacer o querer hacer en un pájaro real para estudiar el vuelo. Una paloma robótica controlable resuelve muchos problemas. Por ejemplo podemos ver cómo esta paloma controlable ayudó a los desarrolladores a descubrir cómo las palomas pueden controlar en ocasiones su vuelo con doblar solo un dedo.

La entrada “PigeonBot”, el primer robot que dobla sus alas como un pájaro se publicó primero en IntelDig.

via IntelDig https://ift.tt/2SQb6ZV

Tras cientos de millones de dólares invertidos este robot sigue sin saber hacer pizzas, ahora se limitará a las cajas para pizzas

La startup Zume apareció hace cinco años con la premisa de hacer pizzas y entregarlas a domicilio en un entorno más sostenible, de paso eliminar a parte de los humanos en el proceso. La jugada no ha salido tan bien, después de unos años intentando que los robots automatizaran el proceso estos no han aprendido tan bien como un humano a hacer pizzas. Ahora la empresa se va a centrar en que sus robots hagan las cajas para las pizzas y sean otros quienes hagan el el popular alimento.

Pizza Zume no es la única startup en intentar hacer las pizzas con máquinas en vez de humanos. Sin embargo, conseguir una pizza recién horneada con el mismo aspecto que la que sale de un restaurante italiano no parece ser tan sencillo. Zume recibió en 2018 una inversión de 375 millones de dólares de SoftBank, el fondo de inversión que está detrás de muchas de las empresas de éxito actuales y también detrás de algunos grandes fracasos que están abriendo polémicas. Esta inversión y otras previas que consiguió hicieron que estuviese valorada en más de mil millones de dólares.

Camión de Zume que sirve de cocina ambulante para hacer los aliemntos cerca del cliente final.

Camión de Zume que sirve de cocina ambulante para hacer los aliemntos cerca del cliente final.Humanos 1 - 0 Robots

La idea que tenía Zume en mente era ofrecer un proceso sostenible en la creación y entrega de las pizzas (y en el futuro otros alimentos). Para ello utilizaban unas "cocinas ambulantes" dentro de camiones que merodeaban las áreas donde operaban en las ciudades para que la entrega fuese más rápida. Después de cuatro años operativos, como anunciaron el mes pasado, sirvieron su última porción de pizza. En consecuencia, aproximadamente la mitad del personal fue despedido.

Que ocurrio exactamente no está claro, según un informe de Bloomberg la realidad dentro de la empresa era distinta a la que se veía en el exterior. Los robots no eran tan precisos con los ingredientes y los resultados no eran los deseados. En 2016 un vídeo de CBS mostraba cómo era el proceso del robot, aunque aún no estaba del todo automatizado, los toppings seguían siendo colocados por una persona y el robot se limitaba a transportar la pizza y poner la base de tomate:

Qué va a ocurrir ahora más o menos sí que se sabe por el anuncio oficial de la empresa: esencialmente se centrarán en hacer cajas de pizza y otros envases. El año pasado Zume compró Pivot Packaging, una empresa dedicada al embalaje y envasado de alimentos. Es hacia donde van a pivotar su negocio, dejando la creación de los alimentos en sí a otros.

Por ahora Zume se ha asociado con algunas empresas para ello, siendo la más destacable Pizza Hut, para producir sus cajas de pizza con materiales biodegrabales. En su página web explican que las características de Zume son las de crear envases sostenibles 100% compostables que reducen la huella medioambiental más que otras opciones como el papel y el plástico. Una alternativa más económica y rápida de fabricar según explican.

Zume tambien seguirá con su negocio de entrega gracias a los vehículos personalizados y aprovechando la tecnología y experiencia acumulada. Analizan por ejemplo las áreas donde hay más demanda y dirigen sus camiones a esas zonas para que los platos lleguen lo antes posible. Todo conectado en sus correspondientes apps para los usuarios. El tema de hacer la pizza, de momento, seguirá siendo cosa del pizzero humano.

Vía | Business Insider

Más información | Zume

via Magazine - robotica-e-ia https://ift.tt/2SB9yEp

domingo, 16 de febrero de 2020

“Las ‘casas móviles’ permiten vivir en 40 metros cuadrados igual o mejor que en 80”

via Robótica https://ift.tt/38vFiQN

sábado, 15 de febrero de 2020

Curro, un "terapeuta" robótico que ayuda a los niños con cáncer

Alrededor de 1.006 niños de entre 0 y 14 años enferman cada año de cáncer en España. Para ayudarles en sus tratamientos, algunos hospitales han incluido terapias con robots o juguetes que pretenden aumentar la autoestima y autonomía de los más pequeños.

Ver vídeo

via Ciencia y tecnología en rtve.es https://ift.tt/2Hp3nfV

viernes, 14 de febrero de 2020

Captcha: por qué cada vez es más difícil probar que eres humano

from INFORMACION - Tecnología https://ift.tt/2US5mRW

via IFTTT

jueves, 13 de febrero de 2020

La barriada sevillana donde los niños aprenden a programar

via Robótica https://ift.tt/39t2jne

El MIT ha desarrollado una inteligencia artificial que edita las frases anticuadas en los artículos de la Wikipedia

La Wikipedia, como wiki que es, es una plataforma colaborativa. Cualquier persona, entre comillas, puede editarla para añadir información, verificar un hecho, añadir una fuente o, por supuesto, actualizar un dato desfasado. No es una tarea sencilla, porque la Wikipedia tiene más de seis millones de artículos en inglés y 40 millones si sumamos todos los idiomas. Editar datos anticuados de todos ellos puede ser una tarea muy tediosa para los colaboradores humanos, pero no para una inteligencia artificial.

Eso es, precisamente, lo que ha desarrollado el MIT, un sistema que se podría usar para "actualizar inconsistencias factuales en los artículos de la Wikipedia, reduciendo el tiempo y el esfuerzo de los editores humanos que hacen este trabajo manualmente". Pensemos que la Wikipedia tiene artículos con cifras, cargos o ubicaciones que pueden ser cambiantes, por lo que la IA podría "estar pendiente" de estos cambios y actualizarlos automáticamente, aunque por ahora, el sistema requiere de cierta intervención humana.

Cambios en los datos manteniendo el lenguaje humano

Los investigadores explican que se trata de un sistema de generación de texto que "señala y reemplaza información específica en frases relevantes de Wikipedia", pero "manteniendo el lenguaje similar a la forma en la que los humanos escriben y editan". En un futuro, creen que existe la posibilidad de crear un sistema completamente automático que detecte las informaciones obsoletas y las actualice manualmente, pero por el momento se necesita de la intervención humana.

¿En qué sentido? En que para que el sistema funcione, el usuario debe escribir en una interfaz una oración no necesariamente estructurada con la información actualizada, supongamos "XX persona tiene 30 años". Introducido el dato, el sistema buscaría la página a la que se refiere la información, que sería en este caso la biografía de esa persona, y actualizaría el dato, reescribiendo la frase tal y como lo haría un humano. En pocas palabras, la IA es una especie de bot de automatización.

Precisamente por eso no es el primero, ya que existen bots que hacen ediciones automáticas en la Wikipedia. La clave explica Darsh Shah, uno de los autores principales del artículo, es que esos bots se basan "en reglas", es decir, que si tal palabra malsonante se pone en un artículo, sea eliminada, por ejemplo. La tarea de editar un artículo en la Wikipedia, explica Shah, "requiere razonar sobre partes contradictorias en dos frases y generar un texto coherente".

Los autores ponen el siguiente ejemplo. Supongamos que tenemos la frase:

"El Fondo A considera que 28 de sus 42 participaciones minoritarias en empresas operativas son de particular importancia para el grupo"

Y que el dato debe cambiarse por lo siguiente:

"El Fondo A considera que 23 de sus 43 participaciones minoritarias son significativas.

Hay que cambiar dos datos: 28 y 42 por 23 y 43. ¿Qué haría el sistema? Buscar el artículo del Fondo A y cambiarlos automáticamente, manteniendo la estructura de la frase y, por lo tanto, la concordancia del texto. Para conseguirlo, el sistema ha sido entrenado con un conjunto de datos basado en pares de oraciones: una reclamación y una frase relevante de la Wikipedia. Cada par fue etiquetado como "De acuerdo", "En desacuerdo" o "neutral".

El modelo analizó, en función de cómo estaban etiquetados los pares, qué palabras de la frase de la Wikipedia contradecían a las de la reclamación, reduciendo el número de palabras al mínimo (en el caso anterior, los datos 28 y 42) para ser lo más neutral posible. Hecho esto, un sistema de codificador-decodificar generaba la frase final.

¿El resultado? Según los investigadores, su modelo era más preciso al hacer actualizaciones factuales que otros sistemas de generación de textos (no identificados en el artículo). En otra prueba, unas personas puntuaron el modelo sobre cinco basándose en las frases resultantes y la nota fue de 4 puntos en las actualizaciones de los hechos y de 3,85 en la gramática.

Vía | Engadget

Imagen | Wikimedia Commons con licencia CC BY-SA 3.0

via Magazine - robotica-e-ia https://ift.tt/39uSi9i

lunes, 10 de febrero de 2020

Retrato robot del nuevo director financiero

from RSS de lo último publicado en 'Computing España' https://ift.tt/38er0E3

via IFTTT

domingo, 9 de febrero de 2020

Las máquinas inteligentes expulsarán a los oficinistas

via Robótica https://ift.tt/2SHuqZt

jueves, 6 de febrero de 2020

"Tenemos 7 nm para rato": entrevista a Manuel Ujaldón, que le da un sobresaliente a los Tensor Core y un bien a los RT Cores

Manuel Ujaldón, CUDA fellow desde 2012, Deep Learning Ambassador de NVIDIA y profesor de la Universidad de Málaga, ya es un habitual en Xataka. Tras entrevistarle en 2012, 2016 y 2018 para analizar el segmento de las tarjetas gráficas, vuelve con nosotros para tratar de descubrirnos cuál es el estado actual de un mercado en constante ebullición.