Meta es conocida por ser la propietaria de Facebook, Instagram y WhatsApp. También por su insistencia con el Metaverso, las Meta Quest 3 o las Ray-Ban Meta. Pero más allá de los entusiastas de la tecnología no es tan conocida en torno a la Inteligencia Artificial como pueden serlo OpenAI o Google. Lo cual no significa, como sabemos los que seguimos de cerca esta industria, que Meta no esté ahí.

De hecho está ahí desde hace mucho. Todo empezó con FAIR (Fundamental AI Research, anteriormente Facebook AI Research), un laboratorio creado en 2013 con sede en Menlo Park —donde las oficinas centrales de la empresa—, Londres y Nueva York.

Su objetivo, estudiar la ciencia de datos, el aprendizaje automático y la IA, parecían ajenos a lo que era en ese momento la empresa: básicamente Facebook, en menor medida Instagram. Muy poco más. Ni siquiera se había hecho todavía la compra de WhatsApp.

Hoy FAIR es Meta AI y sus avances han ido muchísimo más allá. Uno de sus hitos fue la predicción de la estructura tridimensional de 600 millones de proteínas en 2022. Y ahora, visitando la sede parisina de Meta AI, hemos podido hablar con algunos de sus líderes sobre el pasado, presente y futuro de esta ambición de la empresa.

Tecnología dura, rentabilidades futuras

"Muchas de las aplicaciones de IA que vemos hoy día en productos de Meta son el resultado de años de investigación y desarrollo", explica Joëlle Pineau, VP de AI Research en Meta. ¿Dónde se reflejan? Principalmente, en las funciones de clasificación y de recomendación, así como en algunas funciones concretas de las aplicaciones. Por ejemplo, en el recorte de imágenes.

El camino de Meta en este campo ha sido curioso. Sus ingresos vienen de la publicidad, la cual maximizan manteniendo a sus usuarios el máximo tiempo posible dentro de sus aplicaciones. Sus esfuerzos en IA, en cambio, vienen de más de una década atrás, y la apuesta se hizo por tecnología dura con la incógnita de qué resultados llegarían, y cómo podrían rentabilizarlos.

A veces esos resultados no llegan tanto en forma de funciones evidentes para el usuario, sino en mejoras sutiles, incluso que deciden lo que no va a ver el usuario. Como la eliminación automática del contenido inapropiado, según explicó Pineau: más del 95% del contenido relacionado con discursos de odio y el contenido violento es retirado de la plataforma antes de que una sola persona pueda verlo. Dentro o fuera de la empresa. Es decir, ya sean usuarios o ya sean moderadores. Un logro que tiene ver con el uso de IA en los algoritmos para este fin.

Algo parecido a lo que consigue en el terreno publicitario: mostrar anuncios mucho más interesantes para cada usuario y reducir la exposición a publicidad que no le resulta atractiva.

Y en esa misma línea está algo recién anunciado por la empresa: el etiquetado de contenido como "hecho con IA", ya sea audio, vídeo o imagen, si se detectan indicadores de ello o si el propio usuario lo ha revelado. De esa forma se busca reducir los posibles casos de manipulación y aumentar la transparencia. Esto comenzará a hacerse efectivo en mayo.

En los resultados más tangibles, unas recién llegadas, las Ray-Ban Meta, que pudimos probar recientemente. Son un producto que podríamos definir como estratégico para Meta: no solo son una forma de capilarizar su presencia en el mundo, sino también la mejor forma de conseguir que el mundo utilice Meta AI, su chatbot.

Siri, Alexa o el asistente de Google tienen sus productos físicos listos para que el usuario los invoque. Meta necesita sus propios productos físicos para no tener que confiar en que el usuario abra una aplicación para ello, con la fricción que eso supone.

Las Ray-Ban Meta tienen en Estados Unidos su mejor terreno, porque es en el país norteamericano donde se le puede sacar más partido a este asistente. Por ejemplo, usando estas gafas como unos auriculares mediante los que hablar con él e ir haciéndole consultas sobre lo que necesitamos en cada momento. Fuera de allí su asistente está mucho más limitado, de momento.

Y si hablamos de algo presente en una aplicación, no en un dispositivo, tenemos el modelo Segment Anything, que permite separar objetos de las imágenes con un solo toque. Es algo orientado en el lado comercial a incluirlo como función en redes como Instagram para la creación de stickers o la edición de imágenes. Tiene su propia demo pública.

El trabajo acumulado en Meta AI no se limita a funciones, evidentes o sutiles, para sus plataformas: mantiene la apuesta por la investigación abierta mediante la construcción y liberación pública de modelos, papers y código relacionado.

PyTorch, una biblioteca de desarrollo de Machine Learning, comenzó como un proyecto interno para acelerar la productividad de sus investigadores. Hoy no solo está liberada sino que ha sido una pieza clave en el desarrollo de muchas herramientas relevantes en la IA, desde el Autopilot de Tesla hasta ChatGPT.

En los últimos años, lógicamente la apuesta principal ha sido la IA generativa. Pineau considera que la unificación organizativa en Meta ha sido esencial para este salto, reuniendo al equipo de IA fundamental y al de IA generativa, para lograr "un traspaso mucho más rápido de la investigación a la producción".

Sobre el futuro al que se dirige el laboratorio, la VP dice que la empresa trabaja en la creación de "modelos mundiales" más avanzados que puedan capturar y entender información multimodal para hacer razonamientos y planificaciones de forma más precisa.

Aquí se contextualiza bien la presencia de dispositivos de realidad aumentad y virtual, como las Meta Quest 3, dentro de la empresa: no es solo cuestión de vender un producto y crear una plataforma en su interior, sino de aprovechar los desarrollos de comprensión del entorno en doble dirección.

Estos esfuerzos, un año y medio después de la llegada de ChatGPT, que agitó el avispero como nadie antes para despertar el interés de la IA por parte de la población general, podríamos asumir que tienen que ver con la cacareada llegada de la AGI (Inteligencia Artificial General, la cual logrará superar al ser humano en todas las facetas del conocimiento).

En absoluto. O al menos no con ese término.

Yann LeCun, vicepresidente y científico jefe de IA en Meta, es un peso pesado en la empresa y en el sector. Ganó el Premio Turing en 2018 y es uno de los creadores de la tecnología de compresión de imagen DjVu, entre otros hitos. Y en su opinión, el término 'AGI' carece de sentido, pues la inteligencia humana es "muy especializada".

Además, considera que la IA y el aprendizaje automático han conseguido mejoras significativas, pero siguen sin poder igualar la rapidez y la eficiencia del aprendizaje humano. Incluso del aprendizaje animal.

En su opinión, la tecnología aún está lejos de poder replicar la inteligencia humana "ni la de un gato doméstico", subrayando las carencias en comprensión, memoria persistente, planificación y razonamiento. Y de paso, echando por tierra las predicciones que sugieren un logro inminente en este campo. Un exceso de optimismo.

¿De qué depende que la IA siga progresando para ir venciendo esos límites? "Lo que ha traído el progreso es lo que se llama aprendizaje auto-supervisado", dice LeCun. Uno que permita a los sistemas entender y manipular el lenguaje de forma más eficiente, además de conseguir que puedan modelar y entender el mundo físico, un desafío especialmente complejo.

La arquitectura de IA que propone para ello es una arquitectura "orientada a objetivos", que se enfoque en lograr esos objetivos mientras cumple con límites tanto éticos como de seguridad. De esa forma se diferenciaría de los modelos generativos tanto en enfoque como en aplicación.

Considera LeCun que a día de hoy las máquinas no aprenden cómo funciona el mundo, haciendo el símil con un niño de diez años: es capaz de aprender a limpiar la mesa o poner el lavavajillas en minutos, pero a día de hoy los robots no pueden igualar eso. O con un chico de 17 años: puede aprender a conducir con veinte horas de práctica, pero hoy seguimos sin tener conducción autónoma de nivel 5 sin límites. Ahí entra la paradoja de Moravec: la IA hace fácil lo que para un ser humano es difícil, y viceversa.

Yann LeCun durante la entrevista, portando unas Ray-Ban Meta. Imagen: Xataka.

Yann LeCun durante la entrevista, portando unas Ray-Ban Meta. Imagen: Xataka.

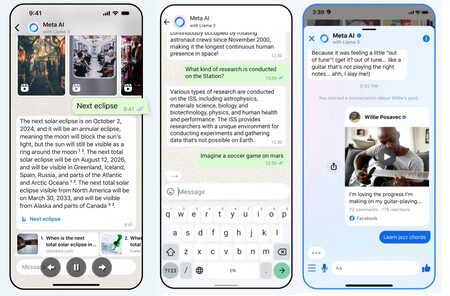

De momento, el futuro de Meta AI confesado por sus propios portavoces es ser accesible en todas las plataformas, incluida WhatsApp, tanto para personas como para negocios.

Algo similar a lo del asistente en las Ray-Ban Meta: no esperar a que sea invocado en un dispositivo ajeno. Tampoco en una aplicación específica, sino en las que los usuarios ya utilizan, un plan anunciado en septiembre que todavía está por llegar al público general.

Y el futuro de los asistentes virtuales, según su opinión, pasa por ser de código abierto y constituir una infraestructura compartida (como el Internet actual) para convertirse en un repositorio de todo el conocimiento y la cultura humanas. Y subraya la importancia del código abierto: "la cultura y el conocimiento no pueden ser controlados por unas pocas empresas en la costa oeste estadounidense o en China".

Hablando de modelos y volviendo al presente: LLaMA, el LLM de Meta, acaba de anunciar su versión 3, está disponible en formato web, tiene versiones 8B y 70B (8.000 y 70.000 millones de parámetros respectivamente), y está por venir una versión 400B multimodal con 400.000 millones de parámetros.

Y además, seguramente su mayor hecho diferencial: es de código abierto, o casi. Porque se parece mucho al usar una licencia comunitaria, pero sin ser completamente Open Source. No obstante, ya marca una importante diferencia frente a sus competidores.

¿Por qué en código abierto? Porque de esa forma consiguen posicionarse de forma más atractiva para los grandes investigadores. No dejaron pasar desde Meta la ocasión de señalar que les resulta impactante pensar que un reducido número de personas en una sala cerrada, sin rendir cuentas ni mostrar transparencia, siempre harán lo correcto.

Remata la entrevista LeCun sin esquivar una pregunta sobre el futuro del Metaverso, toda vez que su espectacular inversión está como mínimo en el aire al menos de cara a la opinión popular.

"Al igual que la IA, es una inversión a largo plazo. La pregunta es: ¿llegaremos a donde queremos llegar antes de quedarnos sin dinero? De eso se trata básicamente la investigación. O antes de que la gente que espera esos resultados pierda la paciencia. La empresa y Zuckerberg han sido muy claros en que tanto la estrategia en realidad aumentada, virtual y mixta como el metaverso son juegos a largo plazo, como una nueva plataforma que necesita ser inventada. Y eso requiere una gran inversión a muy largo plazo en cosas como... pequeños chips que puedan procesar, que quepan en la patilla de unas gafas y que no agoten la batería en diez minutos".

Quizás entonces es que asumimos que el anuncio del Metaverso sonaba a revolución inminente, pero necesitaba algo más de tiempo. Como la AGI. O como quiera llamarla LeCun.

Imagen destacada | Xataka

En Xataka | Se acabó el "muévete rápido y rompe cosas": las Big Tech se han vuelto empresas muy cautas y muy aburridas

via Robótica e IA - Xataka https://ift.tt/qaLSyln