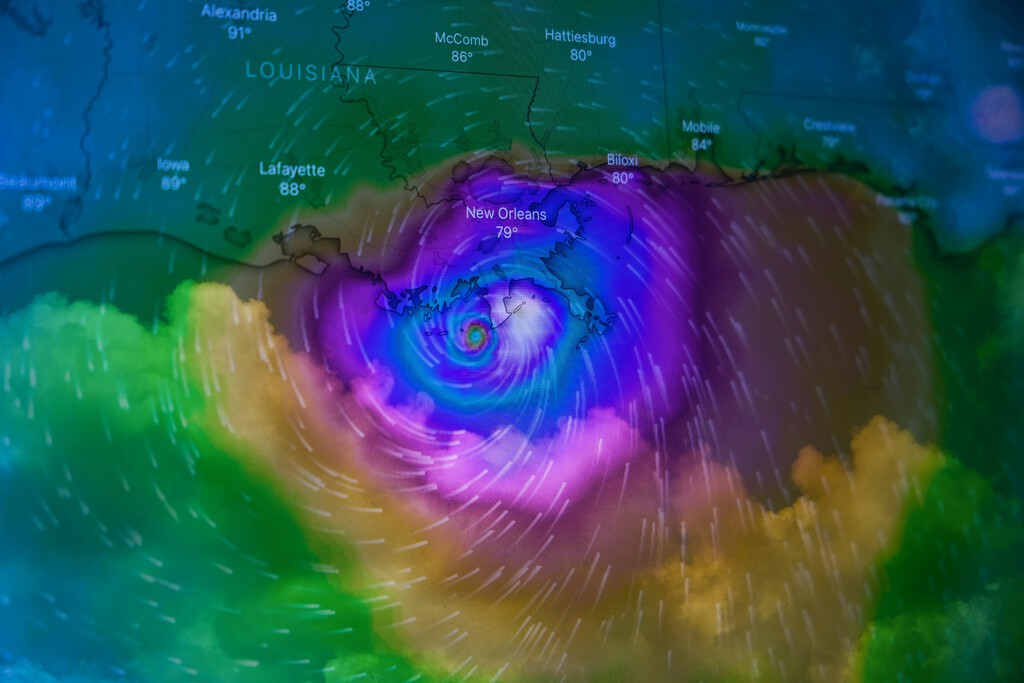

Entre las áreas en las que trabaja Google DeepMind, la predicción meteorológica es una de las que más precisión está obteniendo gracias al refinamiento de las herramientas de inteligencia artificial pensadas para ello. Y es que la compañía acaba de demostrar que la IA puede superar a los métodos tradicionales en la predicción de huracanes. Y es que su modelo Weather Lab consiguió pronosticar con mayor precisión la trayectoria e intensidad del huracán Erin, que pasó de tormenta tropical a categoría 5 en menos de 24 horas hace unos días.

El primer examen real. Hasta ahora, los modelos de IA meteorológicos eran una promesa. El huracán Erin se convirtió en la primera prueba de fuego en tiempo real para el sistema de Google. Durante los primeros tres días críticos de predicción, el modelo de inteligencia artificial superó tanto al pronóstico oficial del Centro Nacional de Huracanes estadounidense como a varios modelos físicos tradicionales, incluidos los europeos y americanos más fiables.

Cómo funciona. Los modelos tradicionales se basan en ecuaciones físicas complejas que recrean las condiciones atmosféricas actuales: humedad, presión, temperatura. El enfoque de Google es radicalmente distinto. Su IA ha sido entrenada con un conjunto masivo de datos que incluye información meteorológica histórica de toda la Tierra y una base de datos especializada con detalles de casi 5.000 ciclones observados durante los últimos 45 años. "Emparejan estos largos datos históricos con detalles sobre cómo se comportan los huracanes y los combinan estadísticamente para ver patrones que el ojo humano no podría detectar", explica James Franklin, ex jefe de la unidad de especialistas en huracanes del Centro Nacional de Huracanes.

Por qué importa tanto. La predicción precisa de huracanes es vital para conocer qué tipo de medidas se precisan para protegerse de ellos en caso de emergencias. Los días tres a cinco de pronóstico son cruciales para tomar decisiones sobre evacuaciones y medidas de preparación. En las pruebas internas de Google con tormentas de 2023 y 2024, su modelo logró predecir la ubicación final de los ciclones con unos 140 kilómetros más de precisión que el modelo europeo de conjunto (ECMWF), considerado el más exacto disponible.

Rendimiento excepcional. Franklin destaca el desempeño del sistema de Google: "Superó realmente a las otras guías en términos de intensidad. Captó la forma general del cambio del ciclo de vida casi exactamente. Prácticamente sin error". El modelo no solo acertó en la trayectoria, sino que predijo con una precisión sorprendente cómo evolucionaría la intensidad de Erin a lo largo de su ciclo de vida.

Todavía en desarrollo. Pese al éxito, el modelo de Google aún no está listo para uso público. Weather Lab incluye una advertencia que recomienda seguir confiando en los pronósticos oficiales del Centro Nacional de Huracanes. Sin embargo, Franklin es optimista sobre el futuro: "Para el año que viene, va a recibir una mirada muy seria y realmente jugará un papel en los pronósticos que salgan del centro de huracanes".

Imagen de portada | Brian McGowan

via Robótica e IA - Xataka https://ift.tt/OAVMazr