Cuando hace tres años OpenAI presentó a ChatGPT al mundo, millones de personas se hicieron la misma pregunta: "¿Me sustituirá la IA en el trabajo?". La preocupación no era nueva. La historia laboral de la humanidad ha estado marcada durante los últimos siglos por la disputa entre las fuerzas de producción humanas y las fuerzas de producción mecánicas. Un avance de las segundas se interpreta sin remedio como una derrota de las primeras.

La diferencia en 2022 residía en el grupo social objeto de la sustitución. Antes del advenimiento de la IA, la "automatización" del trabajo era una de las grandes preocupaciones de los economistas. Millones de puestos de trabajo se habrían perdido en industrias tan importantes como el automóvil o la extracción de petróleo fruto de la lenta pero inexorable incorporación de los robots y otras máquinas-herramienta. Trabajadores manuales, de cuello azul, se habrían visto desplazados económica y socialmente.

El impacto y la gravedad del "fin del trabajo", como pomposamente se vino a bautizar este debate, está en disputa. No está claro que la incorporación de un robot suponga el fin del trabajo humano. Esta era, no obstante, una cuestión ajena e incluso trivial para millones de trabajadores de cuello blanco, de producción intelectual, ajenos a esta clase de automatizaciones y sustituciones.

Hasta que llegó ChatGPT.

La irrupción de la IA ha resultado en un millar de datos y mucha confusión. Son varios los estudios que han intentado estimar la pérdida de puestos de trabajo provocados por ChatGPT y otros chatbots. Es pronto para llegar a conclusiones drásticas. Como algunas empresas están descubriendo, desprenderse de centenares de trabajadores gracias a la IA obliga acto seguido a contratar a otros en tareas que antes no estaban previstas. Este ha sido un patrón constante en la historia de la sustitución laboral humana: la tecnología mata algunos trabajos, genera otros.

Los buenos, viejos tiempos en los que al menos el horóscopo aún lo escribíamos nosotros. (Unsplash)

Los buenos, viejos tiempos en los que al menos el horóscopo aún lo escribíamos nosotros. (Unsplash)

El miedo a este proceso fue inmediato en los medios de comunicación. Si atendemos a la naturaleza de la IA generativa, esto se hace evidente sin mayor explicación. Si ChatGPT es capaz de generar un texto coherente y bien documentado en un puñado de segundos, ¿qué necesidad tendrían los periódicos de mantener en plantilla a decenas de redactores? Bastaría con un par de editores a hombros de un puñado de prompts. Alimentas a la IA con determinados datos, los cocinas y voilà: tienes una noticia muy barata.

Ha sucedido y continuará sucediendo. Algunos medios aprovecharon sus dificultades económicas y empresariales para hacer borrón y cuenta nueva: despidiendo a sus redactores y sustituyéndolos con una IA lograron un medio más barato. También mucho peor. Pero esta no ha sido la principal función de la IA en el entorno periodístico. El peligro no residía en la "sustitución", sino en algo que lleva aquejando a los medios (y a sus lectores) durante muchos años. En un problema tangible, real, no futuro.

En la obsesión por el contenido.

Escribe mi siguiente noticia, ChatGPT

Resulta que la IA no se ha comido nuestros trabajos. Al contrario, nos ha ayudado a seguir incurriendo en las mismas prácticas perversas en las que ya incurríamos antes de la llegada de ChatGPT: producir contenido a toda costa, sin discreción, cubriendo todos los frentes y las necesidades autogeneradas por nosotros mismos. Si el "contenido" era la mayor enfermedad que aquejaba a la industria de los medios de comunicación, la IA no ha funcionado como cura sino como fentanilo: una droga adictiva y acelerante, también mortal.

Así, el lector se ha tenido que acostumbrar a toda clase de experimentos relativos a la IA.

El más evidente de todos ellos es la futurología. ¿Qué hicieron muchos medios cuando un apagón dejó sin electricidad a la totalidad de España? Abrir ChatGPT, preguntarle "cuándo sería el próximo apagón" y publicar la respuesta tal cual en su web. Titulares como "Cuál será la fecha del próximo apagón eléctrico en el mundo, según la inteligencia artificial" o "Ni en 2026 ni en 2030: la fecha del próximo apagón eléctrico en todo el mundo, según la IA" se colaron en el módulo de medios de Google o en Discover.

La cuestión es que el contenido funciona.

El lector está interesado en un evento complejo en tiempo real y los medios pueden producir respuestas rápidas a bajo coste. Otra cosa es que las respuestas sean útiles. ChatGPT a duras penas podía predecir los insondables designios de una curia nonagenaria aislada en la Capilla Sixtina, pero eso no impidió a los medios de comunicación publicar cosas como "¿Quién será el próximo Papa según las predicciones de los chatbots de IA?" o "La predicción de la Inteligencia Artificial sobre quién sería el nuevo Papa". DeepSeek, Perplexity y otras daban como favoritos a Parolin o Tagle. Es decir, no tenían ni la más remota idea de lo que estaban hablando, solo regurgitaban.

¿Se acerca la final de la Copa del Rey? Utilizando herramientas solo levemente más sofisticadas que el pulpo Paul, pudimos alumbrar titulares tan sólidos como "La IA pronostica el ganador de la Copa del Rey entre el Madrid y el Barça". ¿Se alborotan las búsquedas de Google porque llega el sorteo de Navidad? Allá que acudimos a buscar respuestas en los chatbots: "¿Qué número será el ganador del Gordo este año? La IA lo desvela" o "Este es el número del Gordo de la Lotería de Navidad 2024, según los videntes y la IA" (kudos al Heraldo por respetar el digno oficio de los trabajadores videntes frente a La Máquina).

Un señor muy contento descubre que le va a tocar la Lotería según la IA. (Unsplash)

Un señor muy contento descubre que le va a tocar la Lotería según la IA. (Unsplash)

La búsqueda "según la IA" en Google Noticias ofrece infinidad de ejemplos. Podemos descubrir cuántos años pasará León XIV como Papa antes de despedirse del mundo de los vivos; cuál es el trabajo ideal para cada signo del zodiaco; cuánto dinero necesita cobrar un español cualquiera para vivir sin sobresaltos; cuál es el mejor pueblo de Zaragoza para comprarse una casa; o cuál es el once ideal de LaLiga.

Por supuesto, el ejemplo más paradigmático de todo este proceso es la guerra. El conflicto entre Irán e Israel ha despertado ciertas tensiones latentes en la psique del planeta: ¿nos acertamos a una Tercera Guerra Mundial? No lo sabemos, pero por si caso hay medios que han abierto ChatGPT y se lo han preguntado. "Esta será la fecha en la que se podría desencadenar un conflicto global, según la IA", nos prometen en 20 Minutos o La Sexta; mientras que en Las Provincias o ABC nos ofrecen "los países más seguros" en los que refugiarse en caso de Tercera Guerra Mundial, según la IA.

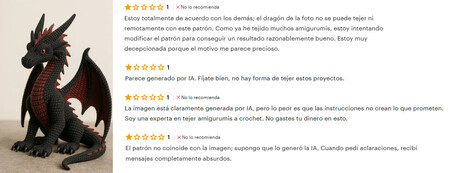

En manos de los medios de comunicación, la IA es un horóscopo glorificado. Lo saben los lectores porque, en ocasiones, como en esta noticia de OK Diario, el prompt utilizado por el redactor para escribir la noticia se cuela en el antetítulo.

Gracias por tanto, Sam

Como vemos, el problema no es tanto que la IA se haya comido nuestro trabajo: es que nos ha servido para empeorarlo aún más. La aparición de ChatGPT y otros chatbots ha creado el peor sistema de incentivos posible y nos ha colocado en el tiempo de los horrores que vaticinó Gramsci: lo viejo que no termina de morir se funde con lo nuevo que no termina de nacer y en ese impás, en ese hueco, terminamos leyendo noticias sobre el tiempo que hará en Bizkaia este verano según la IA.

No deja de tener su comedia que una de las tecnologías más aparentemente sofisticadas de nuestra era haya terminado reducida al mayor virus comunicativo de nuestro tiempo: el contenido. No importa qué intenciones elevada tenga una tecnología, siempre termina generando "slop", vídeos de presidentes convertidos en animales gigantescos, gatos participando en los JJOO, los discípulos de Jesucristo grabados con un móvil. Sam Altman puede imaginar un futuro donde desequemos lagos en Kazajistán para alimentar millones de centros de datos y automaticemos todas nuestras tediosas tareas en la IA; de momento, tenemos una versión algo más glorificada del shitopsting.

Si hemos llegado aquí es en buena medida por su culpa. Por la de Altman y por la del resto de gigantes tecnológicos que han encontrado en la "IA generativa", que no en la IA, una forma fácil y sencilla de seguir escalando sus negocios y captando inversiones. En su mayor parte, los productos que Silicon Valley lleva desarrollando tres años en torno a la IA solo han automatizado la "creación de contenido". Ni siquiera la han refinado. La utilidad que los medios están dando a la IA brota de los propios defectos de la IA generativa tal cual la conocemos a día de hoy.

Ya en tu feed de Discover.

Ya en tu feed de Discover.

Y esto es algo evidente en las propias limitaciones que OpenAI y el resto de empresas están encontrando en su camino. Cuando Altman predijo que la Inteligencia Artificial General llegaría a nuestras vidas en 2025 sabía perfectamente que no era posible. ChatGPT y el resto de chatbots reclutan inversiones, esfuerzos e infraestructuras precisamente en la clase de plataformas que nos alejan, no acercan, a la IAG. No habrá IAG en 2025 y tampoco la habrá en su nuevo deadline, 2026, simplemente porque los inmensos recursos movilizados por la industria tecnológica no se están destinando a ello.

La prioridad, por el momento, es otra. Es lograr productos atractivos que logren captar las suscripciones de los usuarios. OpenAI está en ello, si bien a precios prohibitivos. Otras empresas IA también. Mientras esperamos que la IAG nos libere y quizá, quién sabe, en un futuro nos "sustituya" laboralmente, de momento tenemos "slop".

Consumo. Contenido. Lo que siempre quisimos.

Imagen | ChatGPT

En Xataka | Unos investigadores creen que la IA nos está volviendo más tontos. Llevamos escuchando lo mismo desde la calculadora

En Xataka | Que una reportera corra detrás de un cerdo es el mejor resumen de lo que queremos de la IA: vídeos para partirnos la caja

via Robótica e IA - Xataka https://ift.tt/Ms7TQqE