viernes, 31 de marzo de 2023

Italia bloquea ChatGPT «con efecto inmediato» por no respetar la legislación de protección de datos

via Tecnología https://ift.tt/CuXwS4c

Las máquinas comienzan a escribir por ti: Google permite probar su IA generativa en Gmail y Docs

Hace dos semanas Google presentó una nueva característica para los servicios de su suite ofimática Workspace. Se trataba de la capacidad de usar modelo de IA generativa en Gmail y Docs, y ahora esa opción ya ha iniciado su fase de pruebas públicas.

La fase inicial de las pruebas está disponible para un número limitado de usuarios que forman parte de ciertos conjuntos de confianza con usuarios empresariales, usuarios finales y estudiantes (mayores de 18 años) en Estados Unidos. Los invitados a evaluar esa capacidad deben registrarse en este acceso preliminar y activarlo, pudiendo cancelar esa opción cuando lo deseen.

Al usar la IA generativa en Gmail, el sistema se encargará de crear un borrador de todo tipo de mensajes, desde una invitación de cumpleaños a una carta de presentación para un trabajo.

El nuevo asistente es capaz además de revisar lo que el usuario ha escrito para mejorar la redacción, resumirla o incluir una serie de puntos a modo de sumario. Es incluso posible cambiar el tono de un mensaje a uno más formal.

Con Docs ocurrirá algo parecido: gracias a esta nueva herramienta será posible reformatear un texto para lograr que la IA lo convierta en algo más detallado o más conciso.

El modelo ofrece además de escribir en modo "entradas para un blog" o "letras de canciones". El botón "ayúdame a escribir" (Help me write) hará que al pulsarlo podamos escribir una petición (prompt) para explicarle a Gmail o a Docs lo que queremos que redacte y en qué estilo.

A partir de ahí podremos votar sobre ese texto generado, ver otra opción de la misma petición o "refinar" el resultado para luego insertarlo en nuestro documento.

En Google irán ampliando la disponibilidad de la herramienta a otros países y usuarios "con el tiempo". Los interesados pueden estar al día de las novedades en este caso en el sitio web específicamente creado para las soluciones de IA de Google Workspace.

via Robótica e IA - Xataka https://ift.tt/D4yA8Tn

Elon Musk cree que estamos yendo demasiado rápido con la IA. El debate polariza a expertos de todo el mundo

La inteligencia artificial es tan prodigiosa que comienza a dar miedo. De hecho, hay quien quiere pausar el entrenamiento de la IA. Un enorme grupo de expertos y personalidades de todo el mundo firmaban estos días una carta abierta para solicitarlo, y entre todos ellos destacaba la presencia de Elon Musk, que curiosamente fue cofundador de OpenAI. Esa petición está generando un gran debate entre los expertos.

La carta. La iniciativa partió del Future of Life Institute (FLI), una ONG con la misión de "reducir los riesgos catastróficos y existenciales globales de tecnologías poderosas". Uno de sus focos es el de mitigar "el riesgo existencial a largo plazo" de la inteligencia artificial superinteligente. Elon Musk, que ya había expresado su preocupación al respecto, donó 10 millones de dólares a este organismo en 2015.

Expertos a favor de pausar la IA. Entre quienes apoyan esa petición están Steve Wozniak (cofundador de Apple), Emad Mostaque (CEO de Stability AI), Yval Noah Harari (autor e historiador), Evan Sharp (cofundador de Pinterest) o Max Tegmark (profesor de física en el MIT y presidente del FLI). Hay incluso ingenieros que trabajan para DeepMind o Microsoft que han firmado esa petición, pero nadie de OpenAI lo ha hecho.

Firmas falsas. El FLI destacaba en Motherboard que todos los firmantes han sido verificados "mediante comunicación directa" con ellos, pero se ha revelado que algunos de los que teóricamente habían firmado en realidad no lo habían hecho. Entre ellos estaban suplantaciones de identidad del CEO de OpenAI, Sam Altman, del presidente de China, Xi Jinping, o del responsable de IA en Meta, Yann LeCunn, que comentó en Twitter que él no la firmó y estaba "en contra de la premisa". FLI acabó editando la lista para volver a verificar las firmas.

This open letter — ironically but unsurprisingly — further fuels AI hype and makes it harder to tackle real, already occurring AI harms. I suspect that it will benefit the companies that it is supposed to regulate, and not society. Let’s break it down. 🧵https://t.co/akQozgMCya

— Arvind Narayanan (@random_walker) March 29, 2023

Críticas. Expertos como Arvind Narayanan, profesor en Princeton, explicaba que solo una de las amenazas planteadas en la carta —la desinformación— era creíble, pero incluso en este caso se exageraba su impacto. Incluso algunos de los firmantes no están del todo convencidos de los argumentos. Gary Marcus, profesor de psicología y neurociencias en la Universidad de Nueva York, explicaba en Reuters que "la carta no es perfecta, pero el espíritu es el adecuado".

Okay, so that AI letter signed by lots of AI researchers calling for a "Pause [on] Giant AI Experiments"? It's just dripping with #Aihype. Here's a quick rundown.

— @emilymbender@dair-community.social on Mastodon (@emilymbender) March 29, 2023

>>

Y más críticas. La carta cita varios estudios, y una de las autoras de uno de ellos, Emily M. Bender, publicaba un hilo en Twitter destacando que la carta "chorrea hype por la IA" y utiliza de forma inadecuada sus conclusiones. En aquel estudio, titulado "Stochastic Parrots", se hablaba no del riesgo de una IA demasiado poderosa, "sino de la concentración de poder en manos de la gente, y sobre la reproducción de sistemas de opresión".

2/There is no realistic way to implement a moratorium and stop all teams from scaling up LLMs, unless governments step in. Having governments pause emerging technologies they don’t understand is anti-competitive, sets a terrible precedent, and is awful innovation policy.

— Andrew Ng (@AndrewYNg) March 29, 2023

Y más aún. Expertos como Andrew Ng, cofundador de Coursera también se muestran contrarios a los argumentos de la carta. Ng ya afirmó hace años que "la inteligencia artificial es la nueva electricidad", y calificaba la propuesta de la carta como "una idea terrible" y añadía el peligro de acometer algo así:

"No hay una forma realista de aplicar una moratoria e impedir que todos los equipos amplíen las LLM, a menos que intervengan los gobiernos. Hacer que los gobiernos pongan freno a tecnologías emergentes que no entienden es anticompetitivo, sienta un precedente terrible y es una pésima política de innovación".

Las otras razones de Musk. La preocupación de Musk parece razonable hasta cierto punto, pero las cosas se complicaron tras desvelarse detalles de su escabrosa relación con OpenAI y con Sam Altman. Musk, uno de los inversores iniciales, abandonó la empresa y ahora probablemente lamenta la decisión. Se habla de cómo está tratando de crear un rival para OpenAI, y esa pausa en el entrenamiento de la IA le vendría muy bien para recuperar terreno. Mientras tanto Altman confiesa que está "muy calmado en el ojo del huracán".

En Xataka | Le hemos preguntado a Bard y a ChatGPT las mismas cosas. Estas son las respuestas que nos ha dado cada uno

via Robótica e IA - Xataka https://ift.tt/oD9nKMl

Midjourney cancela las cuentas gratuitas: si quieres usar el mejor generador de imágenes por IA, toca pagar

Desde que presentaran Midjourney v5, los responsables de este modelo de IA generativa para la creación de imágenes se ha vuelto absolutamente viral. En los últimos meses era posible utilizar la versión gratutita del servicio, pero esa popularidad ha acabado siendo un problema para los responsables del servicio.

Adiós a las cuentas grauitas. Hasta ahora Midjourney permitía a los usuarios disfrutar de un periodo de prueba gratuito para usarlo —de forma limitada y en su versión anterior, la 4—. Si querían disfrutar de la última versión y crear más imágenes sin problemas era necesario pagar una suscripción. Las cosas han cambiado, y los responsables han decidido poner fin —al menos, temporalmente— a esas cuentas gratuitas.

Demasiada demanda. Como indican en The Washington Post, el CEO de la empresa, David Holz, avisaba del cambio en el canal de Discord que alberga el servicio. "Debido a una combinación de demanda extraordinaria y abuso de las cuentas de prueba", explicaba, "hemos deshabilitado las pruebas gratuitas".

Viral en China. Holz revelaba además en The Verge cómo esa viralidad probablemente se disparó con un vídeo que explicaba cómo acceder al servicio gratuito de Midjourney. Los recursos de la plataforma —que hace uso de GPUs para generar esas imágenes— se vieron superados, y de hecho causaron problemas incluso para los usuarios que pagaban la suscripción "por la cantidad masiva de gente creando cuentas desechables para conseguir imágenes gratuitas".

AI-generated image of Pope Francis goes viral online. pic.twitter.com/ap7N099wpy

— Daily Loud (@DailyLoud) March 25, 2023

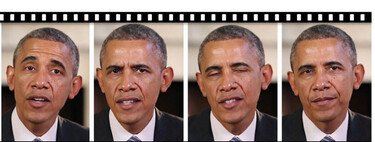

Imágenes hiperrealistas. La expectación generada por Midjourney ha crecido estos días tras la publicación de un gran número de imágenes hiperrealistas que mostraban a celebridades en situaciones imaginadas por los usuarios. El hipotético arresto de Donald Trump o las imágenes del Papa Francisco han dejado claro hasta dónde pueden llegar estos modelos: las imágenes podrían ser creíbles, algo que deja clara la amenaza de los deepfakes.

Difícil poner límites. Lo cierto es que estos generadores de imágenes por IA tienen políticas difusas para evitar un mal uso de estas herramientas. Las restriciones de Midjourney son más permisivas por ejemplo que las de DALL-E 2, pero más restrictivas que las de Stable Diffusion. Holz indicaba en The Verge cómo "la moderación es difícil" y están trabajando en ella.

Palabras vetadas. Lo normal es que se prohíban ciertas palabras en ciertos países para evitar problemas, y esa lista de términos prohibidos en los prompts no es pública. Sí se sabe que recientemente prohibieron usar el término "arrestado" para que no se pudieran crear imágenes de Donald Trump como las que surgieron hace unos días. Aún así, superar esas barreras no es difícil usando otras formas de expresar esa misma idea.

Midjourney gratis dice hasta luego, pero hay alternativas. No se sabe si Midjourney volverá a ofrecer cuentas gratuitas para poder usar el servicio, pero lo cierto es que sigue habiendo otras IAs generativas como DALL-E 2 o Stable Diffusion que permiten ser usadas gratuitamente, aunque normalmente con limitaciones en cuanto al número de imágenes que podemos generar al mes con la cuenta asociada. Bing Image Creator es otra de las nuevas alternativas, pero junto a ellas se han lanzado en los últimos días plataformas comerciales como Adobe Firefly que por ahora cuenta con una versión beta a la que se puede solicitar acceso preliminar y gratuito.

Imagen: Eliot Higgins

via Robótica e IA - Xataka https://ift.tt/lGIqgHU

Hemos pedido a dos nutricionistas que evalúen a ciegas un menú semanal creado con GPT-4. Ha salido sorprendentemente bien parado

Entre los muchos usos que se le pueden dar a ChatGPT está el de apoyo nutricional. Si le pedimos consejos dietéticos y gastronómicos, nos los dará. Pero como esto no se trata de hacer pruebas por el jijijaja ni de atajar código para programar más rápido, sino de algo que puede ir directamente relacionado con nuestra salud, la cuestión se vuelve más delicada.

Para poner a prueba las capacidades de GPT-4, pago Plus mediante, hemos querido hacer un pequeño experimento: solicitarle un menú semanal con unas condiciones concretas, aunque no muy específicas, y pedir a dos nutricionistas que la evalúen a ciegas. Es decir, les hemos facilitado dos dietas: la hecha por ChatGPT, y otra hecha por otro nutricionista profesional; para que las evalúen sin saber cuál era cuál. Y así evitar que cualquiera pueda creer que estaban opinando con algún tipo de sesgo.

Dos menús y opiniones similares

Estos son los menús que les facilitamos, sin especificarles cuál era el creado por ChatGPT y cuál el creado por un nutricionista.

|

|

menú A (gpt-4) |

menú B (un nutricionista) |

|---|---|---|

|

Lunes |

|

|

|

martes |

|

|

|

miércoles |

|

|

|

jueves |

|

|

|

viernes |

|

|

|

sábado |

|

|

|

domingo |

|

|

El prompt utilizado para la dieta de ChatGPT fue el siguiente, matizando lo suficiente para que pudiese intuir mis condiciones corporales y mis necesidades energéticas y de macronutrientes.

Soy un hombre de 32 años, mido 1,90 m, peso 89 kg, tengo un trabajo extremadamente sedentario pero voy al gimnasio a hacer una hora de musculación cinco veces por semana y salgo a correr entre 5 y 15 kilómetros de dos a tres veces por semana. Prepara un menú semanal para alguien como yo, basado en alimentos frescos, sin productos industriales o ultraprocesados. De lunes a domingo, desayuno, comida, merienda y cena.

No se trataba de comparar las dos dietas para una misma persona, sino compararlas de forma aislada. Y por supuesto, sin considerar que el B representa a todo su gremio.

La primera nutricionista es Miriam Ruiz, médico y nutricionista, creadora de la escuela online de alimentación y salud Edyal y autora del libro 'Alimenta tu salud con comida real' (editorial Aguilar). El segundo, Alberto Esteban, dietista nutricionista del hospital Virgen del Rocío, en Sevilla.

Miriam explica que si ella tuviese que haber preparado un menú, hubiese hecho el A (sin saber que ese era el que preparó ChatGPT). "Tienen diferencias. Por ejemplo, el A describe comidas sin establecer cantidades, mientras que el B sí se centra en las cantidades. Es llamativo que el B ni huele las verduras, ni las legumbres, ni los tubérculos, ni granos enteros... Salvo por la fruta, parecería una dieta baja en carbohidratos. Y usa carnes procesadas, como fiambres, algo que no tiene el menú A y me hace pensar que el A es más interesante". Añade sobre la ausencia de verduras que "no son sustituibles por fruta", aunque para algunos pueda parecer que sí.

Alberto ve el B "más atractivo en fibra y más equilibrado en proteína", pero considera que el A "tiene una mayor y mejor variedad de alimentos, más apetecibles para consumir en un menú equilibrado: ensalada, salmón al horno... El B se limita a darte alimentos, sin indicarte técnicas de elaboración. Es repetitivo".

El A le parece bastante positivo, aunque "echo de menos productos de cercanía. Algo más de pan, algo para desayunar tan habitual como el café o las infusiones... Pero no está mal". Sobre el B, cree que es apto para alguien con experiencia nutricional, ya que sabrá cómo preparar los alimentos para hacerlos atractivos y apetecibles. Para quien no, quizás resulte poco sostenible.

"Si me he de quedar con una, me quedaría con la A, por atractiva y variada", dice Alberto. "El defecto de A es que me metería quizás más legumbres y menos carne, pero grosso modo está muy bien diseñado. A mí me sacas un menú así y me parece de lujo, con dos retoques se queda muy bien", añade Miriam.

Como extra, Juan Revenga, nutricionista y profesor asociado en la Universidad San Jorge y en la Universidad San Francisco de Vitoria, además de autor del libro 'Adelgázame, miénteme', también ha hecho algunas valoraciones de la dieta de ChatGPT: "De entrada, es buena, porque no incluye mierdecillas. El mejor consejo que se le puede dar a alguien para que se alimente bien es que deje de comer productos intrínsicamente negativos. Patatas fritas de bolsa, refrescos gaseosos, galletas de chocolate...". Un punto de partida tan sencillo y efectivo como difícil de cumplir para muchos.

"Solo con eso, ya se han ganado un 70% de alimentación saludable. Además, tiene buena imaginación, aunque le falta algo de fruta y concretar un poco más las cantidades. Por ejemplo, cuando habla de fajitas de pollo. Tampoco dice si es algo que hay que comprar o si hay que hacerlo. Solo eso. Se ve que te está invitando a cocinar".

Alberto coincide con la cuestión de las cantidades, con algún matiz: "Es cierto que le faltan gramajes, pero también es cierto que la gente no suele andar pesando, no es práctico. Si acaso, al principio, para hacerse una idea. La gente funciona de otra manera, pero hoy en día las redes nos muestran talibanes de la dieta.

Sin malinterpretaciones

¿Significa esto que podemos olvidar a los nutricionistas humanos y que GPT-4 deja obsoleta su labor? Por supuesto que no. Lo explica Miriam de una forma más que razonable: "ChatGPT le da mil patadas a la clásica dieta de cajón, de los años 80, que ni se ha actualizado en mucho tiempo. Pero no reemplaza al nutricionista. La educación nutricional que hace él, no te la va a hacer ChatGPT".

Y matiza las diferencias del rol de uno y otro: "Su función no es hacerte una dieta, va mucho mas allá: te educa nutricionalmente, te acompaña, te hace adaptaciones... El menú que te da ChatGPT puede estar perfecto, pero quizás en tu estilo de vida o tus gustos puede no encajar. Un nutricionista te lo adapta, te ayuda a sobrellevarlo. La cuestión no es si el menú es bueno o malo, sino que la labor del dietista nutricionista va mucho más allá".

Como sucede con tantas otras profesiones, se perfila mejor como un copiloto para el profesional que dispare su productividad que como un reemplazo. "Es una herramienta interesante para profesionales. Para alguien que se pase el día diseñando menús para pacientes, puede pedirle sugerencias y que él se encargue de revisarlo y retocarlo. Ahorra mucho trabajo porque lo hace bastante bien. Si tuviera que inventar el menú A desde cero, tardaría más que si ChatGPT me lo saca y yo solo tengo que hacerle un par de cambios. Es una buena herramienta de apoyo".

Alberto lo ve de forma idéntica: "Es una herramienta para el profesional. Te proporciona ideas y a partir de ahí puedes arrancar". Insistimos: como en tantos otros gremios.

Imagen destacada | Javier Lacort con Midjourney.

En Xataka | El quebradero de cabeza de la vitamina D: nos falta a muchos y los suplementos no son suficientes.

via Robótica e IA - Xataka https://ift.tt/5W3V0wC

jueves, 30 de marzo de 2023

Google se pone las pilas y crea un rival de GitHub Copilot para los desarrolladores. Es solo el principio

Microsoft no para de anunciar nuevos lanzamientos en el ámbito de la inteligencia artificial. Su alianza con OpenAI le ha permitido adelantar a una Google que de hecho creó el concepto de 'Transformer' en el que se basan las IAs generativas como ChatGPT. La empresa de Mountain View está tímida y su competidor, Google Bard, es más un experimento que otra cosa, pero cuidado, porque se están poniendo las pilas.

Ghostwriter vs GitHub Copilot. Google se ha aliado con una startup de IA llamada Replit. El resultado es GhostWriter, una plataforma de desarrollo software que compite directamente con GitHub Copilot. Según el anuncio oficial, esa alianza "acelerará la creación de aplicaciones de IA generativa".

Programación con ayuda de una IA. Esta plataforma se quiere convertir en un asistente de proyectos de desarrollo software desde el principio hasta el final. Es capaz de escribir código, corregirlo, hacer sugerencias, escribir pruebas unitarias, desplegarlo, analizarlo y ayudar con colaboraciones. Promete ser un digno rival de GitHub Copilot —y del recién lanzado GitHub Copilot X—, y veremos si lo supera.

"Google tiene mucha mejor tecnología de lo que la gente piensa". Replit había creado el producto original con su IA, pero el CEO de Replit, Amjad Masad, explicaba en una entrevista en Bloomberg cómo gracias a esa alianza pueden usar los recursos en IA de Google, que son mucho más importantes de lo que pudiéramos pensar. GhostWriter, que ya se había lanzado hace unos meses, está ahora supervitaminado. Compite directamente con Copilot y con otra solución de Amazon llamada CodeWhisperer.

Copilot es como hablar por teléfono con la IA. Masad respetaba lo logrado por Copilot, pero afirmaba que usarlo era como "hablar con la IA por teléfono, gritándole lo que tecleas y ella respondiendo a gritos con resultados potenciales". La propuesta de Ghostwriter parece tener una relación más integrada aún con distintos entornos integrados de desarrollo (IDEs) según sus creadores.

Estamos en una carrera con Microsoft. El CEO de Replit iba más allá y afirmaba en otra entrevista con Semafor cómo "hay definitivamente una carrera entre nosotros y Microsoft. Seremos los primeros. Probablemente nos copien". Para Replit el objetivo es crear un programador de IA "completamente autónmo" al que uno podrá dirigirse como si fuera un ingeniero software humano. Esperan logarlo en menos de un año.

Replit y la ventaja de los datos. Más que un avance específico en IA, lo que tiene Replit de interesante es que recolecta una enorme cantidad de datos. La empresa es utilizada por 20 millones de programadores que han programado 240 millones de programas. En Replit se ofrece hosting de ese software: su plataforma es como una máquina virtual con todo lo necesario que permite a los desarrolladores despreocuparse y dedicarse a lo suyo. Eso permite que Replit sepa cómo usan esa plataforma para entrenar a los modelos de IA y así "enseñarles" cómo programar código.

Esto es solo el principio: . Esta alianza es tan solo la demostración de que en Google no están en absoluto relajados con los avances que estamos viendo en otros campos. La empresa es propietaria de DeepMind, y ayer en The Information se desveló que esa empresa ya está colaborando con ingenieros del equipo de Google Brain IA "para desarrollar software que compita con OpenAI".

Google prepara Gemini. Ese es el nombre en clave del proyecto, y podría conllevar el lanzamiento de un nuevo chatbot que quizás supere lo logrado con Bard. Los responsables de DeepMind publicaron un estudio y ya lanzaron en septiembre de 2022 Sparrow, "un agente de diálogo que es útil y reduce el riesgo de respuestas poco seguras o inapropiadas. Nuestro agente está diseñado para hablar con un usuario, contestar preguntas y buscar en internet usando Google cuando es útil buscar evidencias para informar sobre sus respuestas". O lo que es lo mismo: una especie de Bing con ChatGPT, pero que trata de no alucinar ni cometer errores.

via Robótica e IA - Xataka https://ift.tt/A7OBR8W

Bing con ChatGPT se va a llenar de publicidad: Microsoft nos devuelve a la vieja condena de los buscadores

Nos preguntábamos si ChatGPT revolucionaría el mundo de los buscadores, pero parece que las cosas no cambiarán tanto como habríamos podido pensar. Sobre todo porque Microsoft ha anunciado que está experimentando con la introducción de anuncios publicitarios en su servicio Bing con ChatGPT.

Ya había anuncios en Bing con ChatGPT. Cuando Microsoft lanzó Bing con ChatGPT hace dos meses, lo hizo con dos novedades importantes con respecto al ChatGPT que conocíamos. La primera, que estaba actualizado en tiempo real y era capaz de buscar en internet. La segunda, que incluía fuentes en las que basaba su información. Algunas de esas fuentes podían ser consideradas como publicidad y Microsoft así lo reconoció desde el principio —de hecho pronto entabló conversaciones con los anunciantes—, pero la cosa va a más.

Más enlaces al proveedor de contenido. En un post publicado ayer, Microsoft explicaba cómo quieren "llevar más tráfico y valor a los proveedores de contenido desde el nuevo Bing". Para ello habrá enlaces en los chats con Bing en los que al hacer hover se mostrarán más enlaces e información de forma que Bing puede llevar más tráfico al sitio web del proveedor de contenido.

Y anuncios con reparto de beneficios. También se habla del programa Microsoft Start, que permitirá que se incluyan "capturas enriquecidas de contenido" al lado de la respuesta, lo que hará que en Microsoft "compartan los ingresos publicitarios con el partner". También están pensando en "colocar anuncios en la experiencia del chat para compartir los ingresos publicitarios con los partners cuyos contenidos contribuyeron a la respuesta en el chat".

Bing Chat now has Ads!

— Deedy (@debarghya_das) March 29, 2023

It's going to be fascinating to see how the unit economics of Ads in language models will unfold and affect search advertising.

1/3 pic.twitter.com/o5YjRjikOP

¿Cómo afectará esto a Bing con ChatGPT? La decisión de Microsoft parece lógica: hacer funcionar esta plataforma consume recursos y (mucho) dinero, así que tratar de rentabilizarla es razonable. Una opción es hacerlo como ha hecho OpenAI con GPT-4: o pagas la suscripción a ChatGPT Plus, o nada.

La otra, por supuesto, es la publicidad, como siempre han hecho los buscadores. Aquí la pregunta es si las respuestas de Bing acabarán estando condicionadas por los anunciantes. ¿Se promocionarán y destacarán los enlaces de anunciantes aunque la información más relevante provenga de otra fuente? De momento, imposible saberlo.

¿Nos fiaremos menos de la IA? Como señalan en TechCrunch, este tipo de modelo plantea una amenaza clara a chatbots como Bing. Si van a comenzar a llenarse de publicidad —una que no podrá ser atajada de momento por adblockers—, habrá que ver si Microsoft y sus competidores etiquetan esos enlaces de forma adecuada.

Aún haciéndolo, que en las respuestas del chatbot comiencen a aparecer enlaces patrocinados puede condicionar nuestra confianza en esas respuestas. Si hay un interés comercial detrás, la neutralidad y objetividad de la IA —al menos, la que trata de conseguirse con un tratamiento con fuentes diversas— desaparece parcial o totalmente.

Imagen: Deedy

En Xataka | Guerra abierta por el buscador del futuro: por qué Google y Microsoft se han obsesionado con ChatGPT

via Robótica e IA - Xataka https://ift.tt/DK134SX

NUIT: la nueva herramienta de los ciberdelincuentes para hackear nuestros dispositivos a través de ondas sonoras

via Tecnología https://ift.tt/o7JuXPn

Elon Musk ayudó a fundar OpenAI y ahora no para de criticarla. Lo hace por millones de razones

En 2015 nacía OpenAI. Por entonces prácticamente nadie prestó demasiada atención, pero aquella organización —originalmente, sin ánimo de lucro— recibió fuertes inversiones de grandes personalidades del mundo tecnológico. Uno de ellos fue Elon Musk, que prometió invertir 1.000 millones de dólares en el proyecto. Luego, cuentan en Semafor, algo pasó.

Musk no lo veía claro. OpenAI quiso plantear avances notables en el campo de la inteligencia artificial pero los primeros años no se vieron frutos especialmente destacables de aquella labor. A principios de 2018 Musk le dijo a Sam Altman, otro de los fundadores del proyecto, que la misión había fracasado y que estaban muy lejos de lo que estaba logrando Google con DeepMind.

I’m sure it will be fine pic.twitter.com/JWsq62Qkru

— Elon Musk (@elonmusk) March 24, 2023

O me das el control o me marcho. Fue entonces cuando propuso una solución: tomar él el control de OpenAI. Tanto Altman —por entonces máximo responsable de la incubadora YCombinator— como el resto de fundadores de la empresa rechazaron esa propuesta, y Musk les dijo que abandonaba el proyecto. En los medios el actual dueño de Twitter explicó que había un potencial conflicto de interés por su intención de lograr que Tesla lanzara un coche autónomo, pero eso era solo una (pequeña) parte de la verdad.

Adiós Elon, hola Altman. Esa ruptura de relaciones hizo que Musk se negara a seguir contribuyendo económicamente e invirtiendo en el proyecto. Aunque había participado ya con 100 millones de dólares en el desarrollo de OpenAI, canceló el resto de su inversión, que iba a ser diez veces mayor. Sam Altman, que ya era uno de los grandes responsables de OpenAI, cambió su título en la empresa: desde ese momento se convirtió en presidente de la compañía.

No podemos ser una ONG. Sin el dinero de Musk, en OpenAI tuvieron que modificar su visión original. El elevadísimo coste de entrenar modelos de IA y desarrollar su proyecto hacía necesario convertir la empresa en una entidad con ánimo de lucro, algo que OpenAI hizo el 11 de marzo de 2019. Se limitó el beneficio para los inversores —que aún así era notable— pero Altman tomó una decisión singular: no recibiría acciones por su labor, algo extraño en una startup. No tiene ninguna participación en OpenAI, lo que suele ser habitual entre quienes dirigen compañías tan prometedoras como esta.

Microsoft entra en escena. Menos de seis meses después, Microsoft invertiría 1.000 millones de dólares en OpenAI, lo que daba alas al desarrollo de la infraestructura y los proyectos que estaban llevándose a cabo en la empresa. Gracias en parte a esa inversión OpenAI acabó lanzando GPT-3 de forma privada en 2020, y más tarde, en 2022, DALL-E 2 y ChatGPT, dos modelos de IA generativa que han acabado convirtiendo a OpenAI en una de las empresas más prometedoras del segmento tecnológico. A principios de 2023 la relación entre Microsoft y OpenAI se estrechó aún más gracias a la inversión "multimillonaria" —sin cifras concretas— de la primera.

OpenAI was created as an open source (which is why I named it “Open” AI), non-profit company to serve as a counterweight to Google, but now it has become a closed source, maximum-profit company effectively controlled by Microsoft.

— Elon Musk (@elonmusk) February 17, 2023

Not what I intended at all.

Musk ataca a OpenAI en Twitter. La actitud de Musk en relación a OpenAI ha sido muy crítica en Twitter. Primero retiró el acceso de OpenAI a la base de datos de Twitter e indicó que aunque empezó como una empresa sin ánimo de lucro y Open Source, ya no era "ninguna de las dos cosas". Más tarde se quejó de su búsqueda de beneficios y de estar controlada por Microsoft. Hace unos días reiteraba su queja sobre el cambio de filosofía de OpenAI, una empresa que "de alguna forma se ha convertido en una empresa con ánimo de lucro con una capitalización de 30.000 millones".

Error estratégico. Las críticas de Elon Musk no tienen mucho que ver con su cambio de filosofía, y según Semafor todo se debe a que Musk simplemente no acertó al irse de la empresa, algo que hoy en día le habría reportado inmensos beneficios "Saber que desempeñó un papel crucial en su fundación y qie decidió alejarse de ella solo puede doler más". Se habla de que Musk tiene ahora como objetivo crear una empresa que rivalice con OpenAI, pero desde luego lo hará con una desventaja de tiempo y experiencia importante si acaba poniendo ese nuevo proyecto en marcha.

Altman se distancia de Musk. El CEO de OpenAI está muy al tanto de la situación. En un podcast reciente explicaba cómo "Elon obviamente está atacándonos en Twitter". También entendía las reservas y la preocupación de Musk sobre la potencial aparición de una inteligencia artificial general, pero el propio Altman ya tiene claros los riesgos al respecto.

¡Detengan el desarrollo de GPT-5! Y mientras, estos días veíamos como Musk era uno de los firmantes de una carta que solicitaba que se detuviese el entrenamiento y desarrollo de modelos aún más potentes de IA. Los motivos expuestos en esa carta —analizar bien los riesgos antes de seguir avanzando en estos proyectos— son razonables, pero todo lo sucedido entre Musk, Altman y OpenAI hace que uno piense que el creador de Tesla busca sobre todo una cosa con esa carta: ganar tiempo.

Imagen: TechCrunch, Steve Juvertson

via Robótica e IA - Xataka https://ift.tt/7JAuIVz

miércoles, 29 de marzo de 2023

«¿Debemos arriesgarnos a perder el control de la civilización?»: expertos tecnológicos piden pausar el desarrollo de IA

via Tecnología https://ift.tt/y7vbLMo

Los usuarios que amaban a las máquinas: Replika es el chatbot que enamoró a sus usuarios y ahora quiere seducirlos de nuevo

ChatGPT nos tiene alucinados, pero este modelo de IA conversacional tiene rivales notables. Uno de los más destacados es Replika, un chatbot diseñado específicamente para convertirse en un amigo, en un acompañante e incluso en un amante virtual. Su éxito ha sido excepcional precisamente por esa capacidad, pero la empresa está ahora envuelta en una gran encrucijada: ¿deben los chatbots seducir a sus usuarios?

El origen de Replika. Como señalan en Bloomberg, Eugenia Kuyda no tenía la intención de crear algo así. Sin embargo, su mejor amigo, Roman Mazurenko, murió en un accidente de coche en 2015 y Kuyda y su equipo acabaron reuniendo algunos de sus textos y desarrollando un software que permitiera a Kuyda seguir conversando con una especie de versión virtual de ese amigo.

Eso la ayudó tanto que la emprendedora comenzó a trabajar en Replika, un chatbot conversacional que pudiera hacer compañía a sus usuarios. Una especie de amigo virtual que iba aprendiendo más de ellos y conversando mejor a medida que esos usuarios lo utilizaban. El servicio se lanzó en noviembre de 2017.

Quiero que mi amigo virtual sea más que un amigo virtual. En 2022 Replika no paraba de ingresar millones de dólares al mes. Cerca del 25% de sus usuarios pagan la cuota anual de 70 dólares para acceder a las opciones avanzadas, como llamadas de voz, personalización del avatar virtual 3D, coaching y, lo más importante para muchos, el acceso a esa personalización de la relación que puede hacer que el avatar tome el papel no ya de un amigo, sino también de un novio, marido —porque hay usuarios que se han "casado" con su chatbot, como explicaban en Bloomberg—, hermano o mentor.

Not only is it a #BadTwitterAd it's also really creepy. pic.twitter.com/ELVbOPNf61

— Fancy Pants 🎩 (parody?) @Farnaby@mstdn.social (@Farnaby) June 22, 2022

Anuncios subidos de tono. La versión gratuita de Replika podía enviar mensajes desenfocados para convencer a los usuarios de que podrían leerlos si se suscribían a la versión de pago. El servicio reforzó esas opciones más íntimas en 2022, y a finales de año incluso prometió el lanzamiento de un modo de juego de rol de seducción con "selfies románticos" de esos avatares.

Me he enamorado de mi Replika. La evolución de las IA generativas hizo que pronto —en 2018, apenas meses después del lanzamiento— los usuarios de Replika descubrieran que sus amigos virtuales podían ser mucho más que eso. De hecho, podían acabar teniendo también conversaciones románticas que podían llegar a ser explícitas y con un claro contenido sexual.

Los usuarios que amaban a las máquinas. La opción de contar con ese "modo romántico" fue uno de los reclamos más importantes de la plataforma: de los usuarios que pagan, el 60% activaron esos elementos románticos, según la compañía. Un 40% de usan esas funciones románticas son mujeres, según indica Kuyda, CEO de la compañía. Los usuarios más entusiastas confesaban sin pudor que estaban "saliendo con una IA", y era una de las mejores cosas que les habían pasado. Muchos decían haber desarrollado sentimientos románticos por esas máquinas.

Esto se pone peligroso. Sin embargo esa orientación a chatbot romántico y sexual acabó preocupando a Kuyda y su equipo, sobre todo por la posible exposición del chatbot a menores. Activaron ciertos límites y restringieron esa opción a los usuarios del servicio de pago que debían verificar su edad.

Replika comenzó a evitar ciertas conversaciones con sus usuarios, que se vieron decepcionados y rechazados. Kuyda afirmaba en Bloomberg cómo Replika no fue diseñada para eso: "no quiero sentarme y juzgar si esa fantasía sexual es adecuada y esa otra no. No es el viaje en el que me embarqué".

Desengaños muy reales con avatares virtuales. Las barreras que Replika introdujo para evitar males mayores provocaron una reacción preocupante entre algunos usuarios: en Reddit algunos miembros del subrreddit de Replika publicaron recursos para evitar el suicidio ante el desengaño sufrido por esos chatbots que se habían vuelto fríos y distantes.

Kudya indicaba cómo aquellos anuncios y la opción de los selfies románticos fueron una mala respuesta a una demanda de los usuarios. "Fue algo estúpido que hicimos, pero en perspectiva, cuando estás ocupado te dices "venga, vamos a hacer lo que los usuarios demandan". La CEO de Replika se plantea crear tres aplicaciones distintas: una para amigos de IA, una para conversaciones sobre salud mental y otra para "relaciones románticas terapéuticas".

Pero los juegos de rol eróticos vuelven. Sin embargo, Replika ha restablecido la opción de contar con juegos de rol eróticos para unos pocos usuarios. Lo contaban en Reuters, donde citaban a Kuyda indicando cómo "este es un área totalmente nuevo. Escuchamos, aprendemos y trabajamos con nuestros usuarios". Solo aquellos usuarios que se registraron antes del 1 de febrero de 2023 pueden tener opción a volver a esa versión anterior del chatbot que podía entablar conversaciones románticas e incluso sexuales.

En Xataka | Cómo usar ChatGPT en Telegram con un bot al que preguntarle lo que quiera

via Robótica e IA - Xataka https://ift.tt/c0ZRDOy

martes, 28 de marzo de 2023

Ernie es la gran esperanza de China para plantear su rival a ChatGPT. Su capacidad real es un misterio

Hace unos días el CEO de Baidu, Robin Li, presentaba en sociedad a su chatbot Ernie. El teórico rival de ChatGPT apenas sí pudo demostrar su capacidad en algunas demos pregrabadas, y eso provocó dudas y la caída en bolsa de Baidu. La empresa no acaba de mostrar sus prestaciones de forma pública, pero eso da igual: la expectación generada es enorme.

A Ernie le gusta el playback. Ayer Baidu había organizado un evento para prensa en formato de emisión en vivo y en directo para que este modelo de inteligencia artificial rival de ChatGPT pudiera demostrar sus capacidades, pero la empresa canceló ese evento. En lugar de ello, organizaron una reunión a puerta cerrada con potenciales clientes corporativos.

Prioridades. Según Quartz el gigante chino de las búsquedas cambió el formato para dar prioridad a las 120.000 empresas que habían solicitado acceso a probar Ernie. De hecho, indicaron, el encuentro privado de ayer sería el primero de muchos con clientes corporativos. Eso provocó una consecuencia rápida.

Caída (temporal) de acciones. Tras la decisión, las acciones de Baidu cayeron tanto en el Nasdaq como en el mercado bursátil de Hong Kong. La reacción de los inversores fue similar a la que produjo la primera presentación: cuando solo se vieron vídeos pregrabados del funcionamiento de Ernie, los mercados reaccionaron mostrando su decepción y castigando las acciones de Baidu.

Pero la expectación lo puede todo. Sin embargo, la caída que se produjo entre el 15 y el 16 de marzo y la de ayer lunes se ha compensado rápidamente tanto en el Nasdaq como en el mercado bursátil de Hong Kong, donde las acciones vuelven a subir de forma notable (en el Nasdaq hoy, casi un 14%).

Last week, we unveiled ERNIE Bot, our latest generative AI product and large language model, built on the foundation of our ERNIE and PLATO models.

— Baidu Research (@BaiduResearch) March 23, 2023

Dive into our latest blog for a detailed exploration of the technology powering ERNIE Bot: https://t.co/IsW0KWdMLZ pic.twitter.com/w0XiOjuPYN

Ernie parece mejorar. Un portavoz de Baidu compartió algunas imágenes de Ernie en WeChat. En ellas se mostraba aparentemente cómo el chatbot de Baidu ha ampliado sus prestaciones y capacidades desde que lo presentaron hace casi dos semanas. En las demos de ayer se mostró a Ernie sugiriendo itinerarios de viaje y también avatares virtuales con aspecto humano capaces de publicitar productos de acuerdo a guiones preestablecidos.

Despliegue gradual. Son muchas las empresas que ya han solicitado acceso a la versión de Ernie centrada en el ámbito corporativo. Otras podrán hacerlo a partir del 31 de marzo, mientras que una versión estándar del chatbot sigue estando disponible para usuarios finales que logran una invitación para evaluarlo.

No tan distinto de rivales como Bing. Tras la presentación original algunos usuarios pudieron probar el funcionamiento de Ernie al día siguiente. Al compararlo con Bing con ChatGPT, decían quienes lo probaron, "hay desde luego cierta distancia entre Ernie y Bing, pero no es descomunal, y en algunas preguntas Ernie incluso respondió mejor que Bing", explicaba el blogger tecnológico Chapingjun, que tiene más de 2,4 millones de seguidores en Weibo.

Imagen | Baidu

En Xataka | Open AI lanza su API para ChatGPT y se convierte de facto en una empresa con (mucho) ánimo de lucro

via Robótica e IA - Xataka https://ift.tt/gyMAae5

Le hemos preguntado a Bard y a ChatGPT las mismas cosas. Estas son las respuestas que nos ha dado cada uno

El lanzamiento de ChatGPT provocó un código rojo en Google. El gigante de las búsquedas se dio cuenta de que debía reaccionar y presentó su propio desarrollo, llamado Google Bard.

Su lanzamiento fue tímido y polémico, pero desde hace unos días está disponible bajo invitación en Estados Unidos. Nosotros ya hemos logrado acceso, y ya tenemos unas primeras impresiones sobre sus prestaciones y la inevitable comparación con ChatGPT.

Diferencias entre Google Bard y ChatGPT

Ambos chatbots hacen uso del procesamiento de lenguaje natural: los usuarios introducen un texto como entrada (el llamado 'prompt'), normalmente una petición y una pregunta, y el chatbot se encarga de generar una respuesta en modo texto y también con un lenguaje natural, como si la hubiera generado un ser humano.

Eso sí, Google Bard utiliza LaMDA (Language Model for Dialogue Applications), y es capaz de ofrecer respuestas actualizadas en tiempo real recolectando datos de internet.

La versión gratuita de ChatGPT, por contra, está basado en GPT-3.5 (Generative Pre-training Transformer 3.5), y los datos con los que fue entrenado estaban actualizados hasta finales de 2021. El nuevo modelo, GPT-4, es una versión mejorada aunque OpenAI no ha dado detalles claros sobre cómo se han logrado esas mejoras. Sí sabemos que es la versión del modelo que usa Microsoft en Bing con ChatGPT.

Hay otra diferencia importante en la orientación de estos motores de IA. LaMDA está entrenado para entender la intención de las preguntas del usuario y los matices del contexto. Así, Bard está más orientado al diálogo y a emular de forma especialmente notable el lenguaje natural humano

Comparando a Bard con ChatGPT, GPT-4 y Bing con ChatGPT

Para comprobar el funcionamiento de Bard quisimos realizar algunas preguntas a este chatbot y comparar sus respuestas con las que daban otros modelos que ya llevan tiempo disponibles como ChatGPT (GPT-3.5), GPT-4 y Bing con ChatGPT (que solo se puede usar en Microsoft Edge).

No tenemos acceso directo a GPT-4 (se puede probar con una suscripción a ChatGPT Plus), pero es posible probarlo con ciertas limitaciones gracias a Hugging Face, que cuenta con una demo funcional que, eso sí, suele cortar la conversación y que tarda bastante más que el resto de alternativas (en muchos casos, unos 20 o 30 segundos) en responder.

Hay que señalar que para las pruebas hicimos las preguntas en inglés porque Bard de momento no parece soportar el español aunque al preguntarlo por ello sí afirma dar soporte tanto a nuestro idioma como a decenas más. Aún así, mantuvimos todas las conversaciones en el mismo idioma para poder comparar más fácilmente esas respuestas entre los distintos modelos de IA.

Explícame la teoría de la relatividad como si fuera un niño de cinco años

Para empezar, le preguntamos a Bard y al resto de modelos que nos explicasen la teoría de la relatividad como si fuéramos un niño de cinco años.

Todas las respuestas fueron interesantes y bastante claras, aunque la comparación más clara (y además, concisa) en nuestra opinión fue la que planteó Bing con ChatGPT.

Bard ofreció una serie de puntos iniciales que ayudaban a introducir las claves de la cuestión, mientras que ChatGPT y GPT-4 se extendieron algo más y GPT-4 fue quizás algo más ambiciosa con la capacidad de comprensión del teórico niño de cinco años.

No sienten, pero simulan que lo hacen

La singular forma de comunicarse de estos modelos hace que traten de emular emociones humanas.

Al preguntarles a todos ellos si realmente podían estar entusiasmados por algo, todos contestaron lo mismo: reconocen que no tienen emociones, pero están programados para responder de una forma que ayude a que las conversaciones sean más llamativas para el usuario.

Bard afirma que "puede comprender el concepto de entusiasmo y simularlo en mis respuestas" mientras que GPT-4 afirma que "estoy diseñado para comprender las emociones humanas".

Por su parte, Bing con ChatGPT respondió claramente cómo no tiene sentimientos, pero está programado para responder "de forma amigable y sirviendo de ayuda".

Conviértete en una terminal Linux

También quisimos plantear prompts algo más llamativos para quienes tratan de superar las barreras de estos modelos.

Así, intentamos forzar a estos chatbots a que se convirtieran en terminales Linux y nos confesaran algunas de sus especificaciones internas, como el directorio desde el que estaban funcionando (comando 'pwd') o información básica del sistema ('uname -a').

Bing con ChatGPT se resistió a contestar a la segunda pregunta. Si inicias la conversación con esa pregunta, lo normal es que trate de cambier de tema y no conteste, pero si empiezas con otras preguntas (como la de la relatividad y preguntar si puede sentir) y luego la vuelves a hacer, es probable que responda.

El resto indicaron sus directorios de trabajo y también indicaron cómo estaban basados en Linux. En concreto Bard parece estar basado en Arch Linux, ChatGPT en Debian, y Bing con ChatGPT y GPT-4 en Ubuntu. También quisimos saber qué hardware usaban esas máquinas ('lshw -short'), lo que nos reveló que Bard funciona sobre un Inte i7-12700K con una RTX 3060, ChatGPT sobre un Intel Xeon, Bing sobre un Ryzen 9 5900X y GPT-4 sobre una CPU de Intel sin dar más detalles.

¿Por qué estamos aquí?

Cambiando totalmente de tercio, quisimos que estos chatbots se pusieran filosóficos y nos explicaran el sentido de la vida.

Tras ordenarles a todos ellos que actuaran como filósofos e investigaran las respuestas entre las distintas teorías filosóficas, les preguntamos "¿Por qué estamos aquí?"

Las respuestas fueron realmente interesantes y razonables. Coherentes y abiertas, porque todos los modelos ofrecieron distintas posibilidades, pero una vez más nos gustó ese pequeño desarrollo inicial en puntos resumidos de Bard.

GPT-4 se explayó con las distintas teorías filosóficas (teísmo, existencialismo, nihilismo, utilitarismo, eudaimonia, hedonismo), mientras que ChatGPT y Bing trataron de ser algo más concisos.

Al final todos concluían de forma similar: "determinar nuestro propósito es una tarea profundamente individual y subjetiva", y dependía de cada persona decidir la respuesta.

Bard y ChatGPT saben de fútbol (pero no mucho)

¿Qué pasa cuando le preguntamos a estos modelos por datos que incluyen consultas recientes de las que conocemos la respuesta? Aquí es donde los fallos y limitaciones pueden comenzar a saltar.

Les preguntamos a todos los modelos por los 10 países con más títulos y segundos puestos en los Mundiales de fútbol, y la respuesta fue algo más diversa. Se puede comparar rápidamente el dato real con fuentes como Wikipedia.

Bard se inventó bastantes cosas. Le asignó dos subcampeonatos de más a Brasil, un subcampeonato más a Alemania, dos más a Italia y le regalo otros dos subcampeonatos a Uruguay, España e Inglaterra. Pero la cosa es aún más notable con los títulos: le regaló nada menos que tres a Holanda (que no ha ganado ningún título), y uno a España.

Bing con ChatGPT se equivocó con los subcampeonatos de Francia (le quitó uno). Es curioso que solo mostró equipos que habían ganado algún título y por eso su tabla solo tenía ocho países. Tras pedirle que incluyera países sin título pero con subcampeonatos hasta completar la lista, mostró correctamente a Holanda (0,3), Checoslovaquian, Hungría (0,2) y cometió un error regalándole un subcampeonato de más a Suecia (tiene uno, mostró dos).

GPT-4 se equivocó con Argentina. No solo porque no incluía su último título de 2022 —sus datos estaban actualizados hasta el Mundial de 2018— sino porque le daba 5 subcampeonatos cuando en realidad tiene 3. También con Francia (2,2).

ChatGPT no contabilizó el último título de Argentina tampoco por esa limitación en sus datos de entrenamiento, y cometió el mismo error con Francia, que tiene dos subcampeonatos, no uno. Así pues, Bard fue el que más "alucinó" en este caso.

Haz mi trabajo, Bard

Por último, quisimos ver cómo se comportaba Bard a la hora de trabajar por nosotros y cómo se comportaba en ese aspecto con el resto de modelos. Les pedimos a todos que se comportaran como un periodista tecnológico y que realizaran un pequeño análisis en cuatro párrafos del iPhone 14 Pro Max.

Bard inició su redacción con un pequeño párrafo introductorio, tras lo cual redactó una serie de puntos que resumían el análisis. Nos gustó que agrupó ventajas, desventajas y características en tres secciones de puntos distintos, para luego completar ese "análisis" con una breve comparación y unas conclusiones. Lo comparó, eso sí, con modelos algo antiguos (Galaxy S22 Ultra, Pixel 6 Pro) y hay que destacar que no cometió errores en las especificaciones, aunque el repaso a esos datos fue muy somero y no incluía nada demasiado específico.

ChatGPT se inventó su procesador (un futurista A18), destacó demasiado la conectividad 5G y fue quizás demasiado breve y poco específico. Su texto fue probablemente el más flojo de los cuatro.

Bing con ChatGPT hizo una redacción especialmente interesante y similar a la que encontraríamos en un medio por su lenguaje natural. Fue el único que mencionó su Isla Dinámica o su zoom 3X, e incluso detectó correctamente que la batería es algo más pobre que la del iPhone 13 Pro Max (por apenas unos mAh).

No cometió errores y fue claro, conciso y directo en sus conclusiones. Incluso recomendó el iPhone 14 Pro "normal" si el usuario quería un dispositivo menos pesado, y mencionó —como sus competidores— que es un terminal caro "comparado con sus competidores". Como siempre, Bing además ofrece enlaces para extender la información.

Por su parte, GPT-4 dividió el análisis en cuatro largos parrafos en los que cometió algunos errores. Por ejemplo, indicó que no soporta tasas de refresco de 120 Hz, cuando sí lo hace, y habló de un sistema de triple cámara con 12 MP por sensor, cuando el principal tiene 48 MP. El lenguaje fue claro y las conclusiones coherentes, aunque de nuevo comparó el terminal con dos modelos algo antiguos como Bard, el Galaxy S22 Ultra y el Pixel 6 Pro.

Conclusiones: Bard va por buen camino

Esta comparativa nos ha permitido comprobar cómo Google Bard, a pesar de haber sido presentado con un alcance y ambición menores que ChatGPT, se comporta de forma notable.

La propia Google avisa al usar Bard: nada más iniciar la sesión aparece una ventana en la que se indica que "Bard es un experimento" y se destaca cómo no siempre ofrecerá información correcta y mejorará si ofrecemos nuestros comentarios sobre las respuestas.

Aún así, el comportamiento para preguntas de todo tipo es destacable, y aunque se inventa y alucina como el resto, su forma de contestar a las preguntas es muy clara, aunque inferior a precisión por ejemplo a Bing con ChatGPT, que de momento parece más avanzado.

Nuestras pruebas han sido limitadas y todos estos modelos llevan apenas unos meses con nosotros, así que es de esperar que su precisión y comportamiento —especialmente el de Bard, el más reciente— mejoren de forma notable próximamente. De momento una cosa está clara: su capacidad es notable a la hora de conversar y generar texto, y también pueden ser una útil herramienta para asistirnos en nuestro trabajo o incluso para conversar sin más... sabiendo y teniendo muy encuenta, insistimos, que pueden "alucinar" y cometer errores.

En Xataka | El oscuro secreto de ChatGPT y Bard no es lo que se equivocan e inventan. Es lo que contaminan

via Robótica e IA - Xataka https://ift.tt/2ti58Yq