A pesar de que las cuentas en OpenAI no están tan sanas como le gustaría a Sam Altman, realmente no está siendo un problema para seguir recaudando dinero de sus inversores. La lluvia de millones que se están gastando en ChatGPT llama la atención por la forma en la que buscan obtener retorno: mediante la atención de los usuarios. Y tiene más sentido de lo que puede parecer en un primer momento.

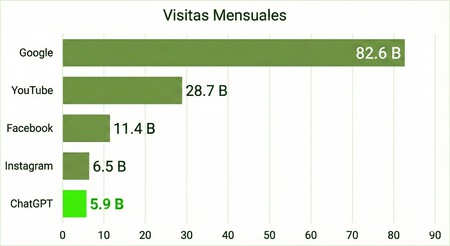

7.000 millones de visitas al mes. Un reciente análisis de Similarweb sobre la IA generativa nos ha puesto sobre la mesa cifras muy interesantes que nos vienen muy bien para medir el pulso al internet de nuestros días. En septiembre de 2025, los servicios de IA sumaron 7.000 millones de visitas al mes, lo que supone un crecimiento del 76% respecto al año anterior y corona a las IAs como uno de los principales rivales de las redes sociales en términos de tráfico.

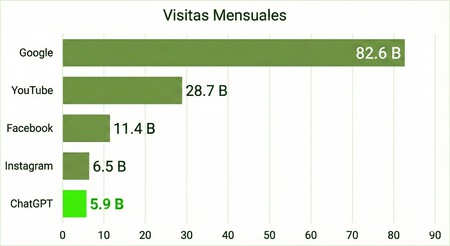

ChatGPT sigue siendo el líder indiscutible: en el mencionado mes llegó a los 5.900 millones de visitas, muy cerca de Instagram, con 6.500 millones. Las primeras posiciones son para Google (con 82.600 millones), YouTube (28.700 millones) y Facebook (11.400 millones).

Todo por nuestra atención. En la era de internet, existe algo más valioso que el propio dinero: captar la atención de los usuarios. Es el motivo por el que las redes sociales son tan atractivas para las empresas de cualquier tamaño, convirtiéndose más en un escaparate comercial que en lugar donde contar nuestras vidas.

También, esta es la misma razón por la que los ‘chatbots’ se mantienen en pie, a pesar de que pierden dinero cada vez que alguien los usa. Mientras, las grandes tecnológicas están recurriendo al endeudamiento. No se quieren quedar fuera de la burbuja de la IA y el motivo ahora está más claro que nunca.

La “columna vertebral” de internet. No solo es que ChatGPT ha logrado convertirse en la plataforma de la historia digital moderna que ha ascendido más rápido, colocándose en el podio de los cinco sitios web más importantes del mundo. Lo verdaderamente importante de esto es que han conseguir captar lo más valioso: la atención del usuario.

El siguiente paso: llenar los ‘chatbots’ de anuncios. Ante este paradigma, OpenAI se está planteando algo que ya era un secreto a voces: vestir a ChatGPT con anuncios. Una posibilidad que serviría para monetizar la herramienta, especialmente para sacar rédito económico de los usuarios de los planes gratuitos, pero que supone muchas dudas en el terreno de la privacidad y la neutralidad de las respuestas ofrecidas.

¿Beneficios para cuándo? Mientras, las tecnológicas continúan aumentando la inversión, incluso aunque los beneficios no lleguen directamente. El aguinaldo, en este caso, llega en forma de un crecimiento meteórico y varios miles de millones de visitas que demuestran que hay un motivo para ser optimista con la IA.

Imágenes | Generadas con Gemini

En Xataka | OpenAI necesita recaudar una cantidad absurda de dinero para poder seguir perdiendo dinero

via Robótica e IA - Xataka https://ift.tt/TqG83sV